Introduzione

Docker è una piattaforma software che permette lo sviluppo, il test e il deployment di applicativi in modo veloce. Docker impscchetta il software in unità standard chiamate contenitori che forniscono tutto ciò di cui l'applicativo ha bisogno, incluso librerie, strumenti di sistema, codice e ambiente runtime-

Il presente corso esamina i fondamenti della tecnologia Docker, con ogni aspetto esemplificato da esercizi pratici e nell'ottica di comprensione del funzionamento dei metodi usati.

Lo scopo è di rendere il partecipante sufficientemente edotto delle basi di Docker da permettere un approfondimento individuale successivo.

Vengono coperti i seguenti aspetti fondamentali:

- gestione di immagini e di contenitori di processo, di rete e di dati

- inserimento di un proprio applicativo in un'immagine Docker

- orchestrazione locale di più contenitori con Docker Compose

Ultimo aggiornamento: Febbraio 2024

Licenza

La presente documentazione è distribuita secondo i termini della GNU Free Documentation License Versione 1.3, 3 novembre 200t8.

Ne è garantita assoluta libertà di copia, ridistribuzione e modifica, sia a scopi commerciali che non.

L'autore detiene il credito per il lavoro originale ma nè credito nè responsabilità per le modifiche.

Qualsiasi lavoro derivato deve essere conforme a questa stessa licenza.

Il testo pieno della licenza è a:

https://www.gnu.org/licenses/fdl.txt

Architettura

Occorre comprendere il motivo dell'invenzione e rapida adozione di Docker, e quali vantaggi da.

Quindi si procede ad un overview della sua architettura.

Segue la procedura di installazione di Docker, soprattutto su piattaforma Linux.

Finalmente viene data la sintassi del comando client docker, e la struttura dei suoi sottocomandi.

Evoluzione e componenti

Docker è un ambiente di isolamento delle risorse necessarie ad un applicativo all'interno di un contenitore

- Da circa 2013, ideato da Solomon Hykes

- Contributo di Red Hat

- Richiede Linux a 64 bit Kernel 2.6+

- Licenza Apache (open)

- Scritto in linguaggio Go

- Virtualizzazione entro il sistema operativo

- Direzione: software indipendente dal sistema operativo

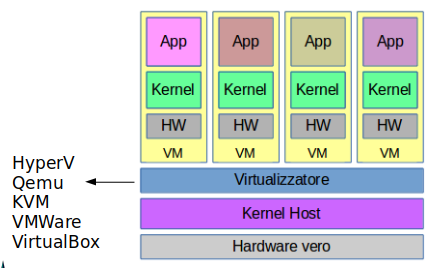

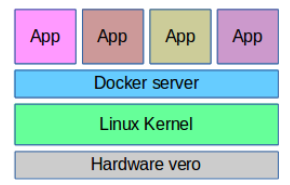

Macchine Virtuali e Contenitori

Macchine Virtuali: Virtualizzazione dell'Hardware

- Più sistemi operativi diversi

- Più flessibile

- Più maturo

Contenitori: Virtualizzazione dell'Ambiente Operativo

- Più efficienza

- Meno manutenzione di sistema

- Partenza molto più veloce

- Migliaia di immagini disponibili, con documentazione

NB: Il Kernel è quello dello host Linux

Tipi di Contenitori

- Process container - l’ambiente di esecuzione di un processo principale e possibilmente altri processi

- Network container - fornisce connettività, indirizzamento e risoluzione nomi ai contenitori di processo

- Data container - mantiene i dati in volumi e li persiste quando i contenitori di processo non sono attivi

Tutte le immagini da cui derivano i contenitori sono mantenuti in un repository sul computer locale

![]()

Docker

Docker è scritto nel linguaggio di programmazione Go

Molti dei suoi comportamenti sono dovuti al linguaggio Go

E’ distribuito da docker.com (o docker.io)

Ne esistono due versioni:

- enterprise - a sottoscrizione di licenza

- community - gratuito ed Open Source

Docker si basa su features architettoniche di Linux:

- cgroups - supporto kernel all’isolamento processi

- Union File System - FS composto da layers

La docker.com supporta il prodotto solo su Linux

Il Linux di riferimento è Ubuntu

E’ in fase di sviluppo un Linux di riferimento specifico per Docker indipendente dalle distribuzioni correnti

Immagini

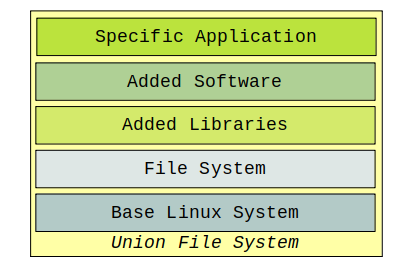

Un contenitore è l'istanza run-time di un'immagine.

Un'immagine è la combinazione di un certo numero, variabile a seconda della specifica immagine, di strati software (Layers), integrati all'interno di uno Union File System.

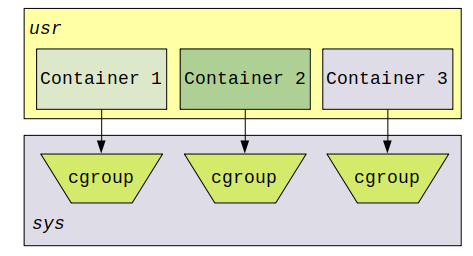

Cgroups

Un cgroup (control group) è una feature che limita, traccia ed isola l’uso di risorse di una collezione di processi.

I Cgroups sono una parte integrale del kernel Linux

Forniscono l’implementazione nel system space dei contenitori dello user space

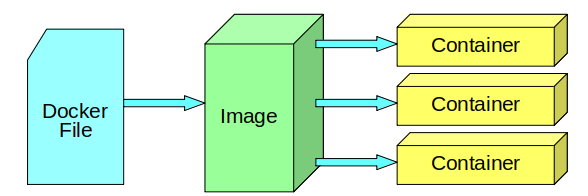

Componenti di Docker

- Dockerfile: specifica dei componenti necessari. File testuale di specifiche

- Image: risultato della compilazione del docker file. Serie di layers in un repository locale o remoto

- Container: istanza di realizzazione di una image

Più containers della stessa image sono istanze separate e indipendenti

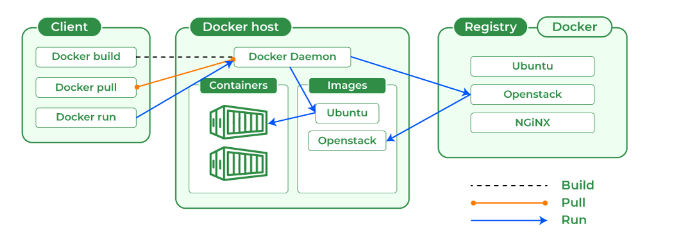

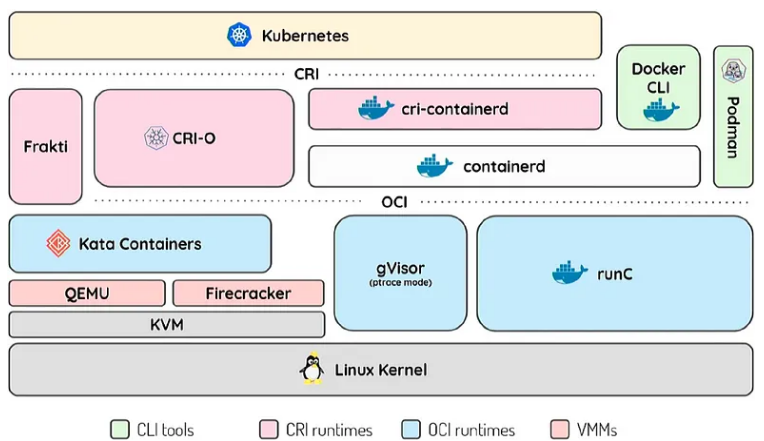

Client-Server

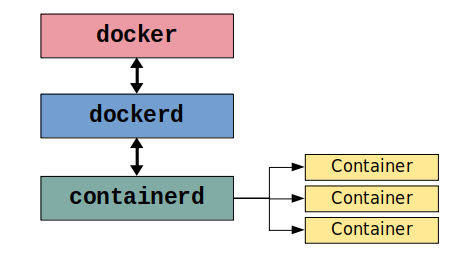

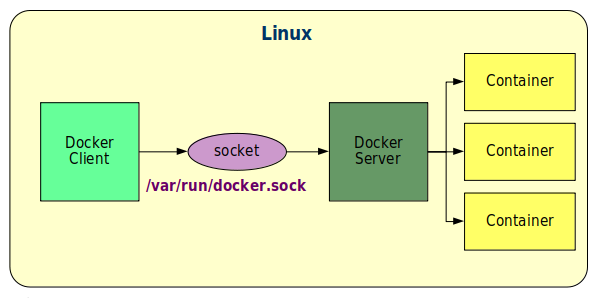

Docker segue l'architettura Client-Server. Vi sono un eseguinile client e due server.

docker - client, Command Line Interface. Interfaccia con l’utente tramite comandi shell

dockerd - high-level server, interagisce con il client. Implementa il comportamento di Docker

containerd - low-level server, gestisce i container. Usato anche con contenitori non Docker, p.es. Kubernetes

Il server è gestito come servizio standard di Linux e si può controllare con il comando amministrativo:

sudo systemctl azione docker

ove azione può essere:

- status - stato del servizio e processi attivi

- start - far partire il servizio

- stop - fermare il servizio

- enable - configurare lo start automatico al boot

- disable - disabilitare lo start automatico al boot

Due componenti del server:

- docker.service - il servizio

- docker.socket - il socket Unix di collegamento

Il collegamento tra client e server avviene tramite un socket. In locale (default) questo è un socket Unix.

Installazione su Linux

Tipi di Installazione

Linux

Ubuntu e simili [deb], RedHat e simili (CentOS) [RPM]

- Su hardware diretto (Docker Engine)

- Su Macchina Virtuale Linux (Docker Engine)

- VirtualBox (preferito)

- KVM

- Con Docker Desktop

Windows

- Su Macchina Virtuale Linux (Docker Engine)

- VirtualBox (preferito)

- VMWare

- Linux on Windows con WSL2 (Windows Subsystem for Linux)

- Con Docker Desktop

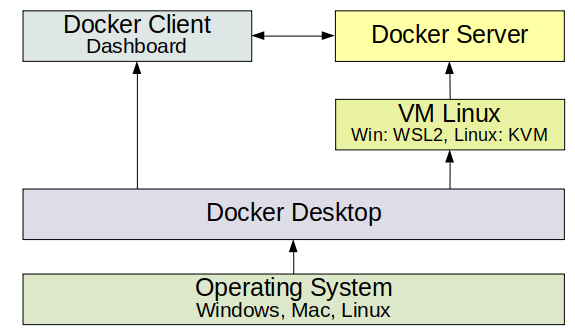

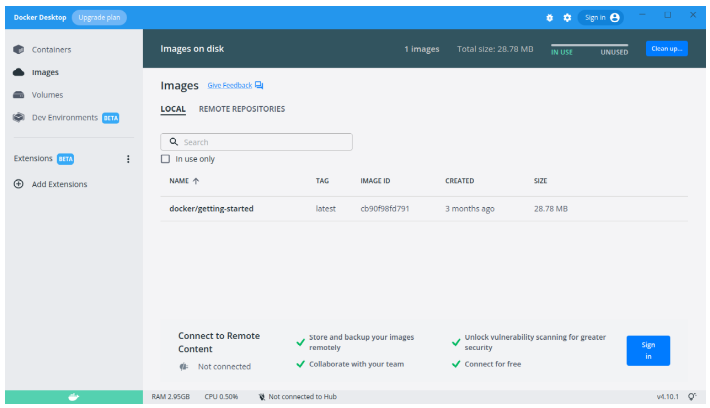

Docker Desktop

Nuova offerta Docker. Basato su Macchina Virtuale Linux.

- Soluzione per principianti

- Interfaccia grafica Dashboard comune

- Molte meno opzioni che da linea di comando

- Non ancora performante o stabile

- Promesse di migliorie

NB: Non si possono avere simultaneamente attivi Docker Engine e Docker Desktop

Su Linux, prima di Docker Desktop:

sudo systemctl stop docker

sudo systemctl disable docker.service

sudo systemctl disable docker.socket

Procedura di Installazione

Su Hardware o su VM VirtualBox, requisiti:

- Linux Ubuntu o simile (p.es. Mint), recente, 64 bit

- 4 GB RAM

- 100+ GB HD

- Connessione a Internet

Metodo 1

Installare dai pacchetti della distribuzione.

Facile, veloce e sicuramente allineato con il resto del software di distribuzione.

Ubuntu, Mint, ecc (DEB)

sudo apt update

sudo apt install docker.io

Però non è l'ultima versione disponibile.

Red Hat, CentOS, Oracle, ecc (RPM)

sudo dnf check-update

Configurare il repository di Docker:

sudo dnf install -y dnf-utils zip unzip

sudo dnf config-manager --add-repo=https://download.docker.com/linux/centos/docker-ce.repo

Installare Docker:

sudo dnf remove -y runc

sudo dnf install -y docker-ce --nobest

Abilitare e lanciare il servixio:

sudo systemctl enable docker

sudo systemctl start docker

Metodo 2

Esempio per le pacchettizzazioni DEB (Ubuntu, ...)

Installare dal repository di docker.io.

Versione più recente, e permette la successiva estensione con plugins.

Occorre configurare la locazione del repository ed scaricare il necessario certificato. Questo si compie al meglio, preparando la seguente procedura shell, docker-repo.sh:

#! /bin/bash

# Add Docker's official GPG key:

sudo apt-get update

sudo apt-get install ca-certificates curl gnupg

sudo install -m 0755 -d /etc/apt/keyrings

curl -fsSL https://download.docker.com/linux/ubuntu/gpg | sudo gpg --dearmor -o /etc/apt/keyrings/docker.gpg

sudo chmod a+r /etc/apt/keyrings/docker.gpg

# Add the repository to Apt sources:

echo \

"deb [arch=$(dpkg --print-architecture) signed-by=/etc/apt/keyrings/docker.gpg] https://download.docker.com/linux/ubuntu \

$(. /etc/os-release && echo "$UBUNTU_CODENAME") stable" | \

sudo tee /etc/apt/sources.list.d/docker.list > /dev/null

sudo apt-get update

# Install the Docker packages:

sudo apt-get install docker-ce docker-ce-cli containerd.io docker-buildx-plugin docker-compose-plugin

Rendere la procedura eseguibile e lanciarla:

chmod +x docker-repo.sh

./docker-repo.sh

Questo da l'ultima versione stabile disponibile, incluso un numero di plugin che sono l'ultima evoluzione di Docker.

Dopo l'installazione

Solo i membri del gruppo docker possono usare l'ambiente.

Configurare l’utente corrente:

sudo usermod -aG docker $USER

Reboot del sistema. In teoria un relogin è sufficiente, ma la VM Ubuntu o RedHat vuole proprio un reboot.

Test dopo il reboot:

docker info

Ambienti e comandi

Il client docker è un applicativo da linea di comando (CLI) che:

- interagisce con l’utente

- invia i comandi al server per l’esecuzione

Nella versione di Docker più moderna i comandi hanno la struttura:

docker ambiente comando

Alcuni comandi storici non hanno bisogno della specifica dell’ambiente e sono del formato:

docker comando

Per avere un veloce aiuto sui comandi disponibili basta:

docker

Per avere un veloce aiuto sui comandi disponibili in un certo ambiente:

docker ambiente

docker ambiente --help - dà anche le opzioni

Principali Ambienti

Ogni ambiente permette la gestione di un diverso aspetto di Docker:

- config - configurazioni del cluster Swarm

- container – contenitori di processo

- image - immagini

- network – contenitori di reti

- node - nodi del cluster Swarm

- plugin - plugins

- secret - segreti del cluster Swarm

- service - servizi offerti dal cluster Swarm

- swarm - il cluster Swarm

- system - aspetti generali del sistema

- trust - fiducia delle immagini

- volume - contenitori di dati

Molti comandi legacy non richiedono la specifica dell’ambiente

Manualistica

Docker è dotato di ricca manualistica di riferimento Il nome della pagina di manuale mappa il comando docker dato:

docker ambiente comando

ha manualistica con

man docker-ambiente-comando

Esempi:

man docker

man docker-run

man docker-network-create

Immagini

Un'immagine Docker è un template read-only.

Contiene un insieme di istruzioni per la creazione di un container Docker.

E' una maniera conveniente di impacchettare un applicativo e l'ambiente operativo associato di cui l'applicativo ha bisogno.

Le immagini sono conservate in un Repository o Registry, ove si possono porre una volta sviluppate, e da li sono scaricate alla piattaforma ove vengono generati i contenitori.

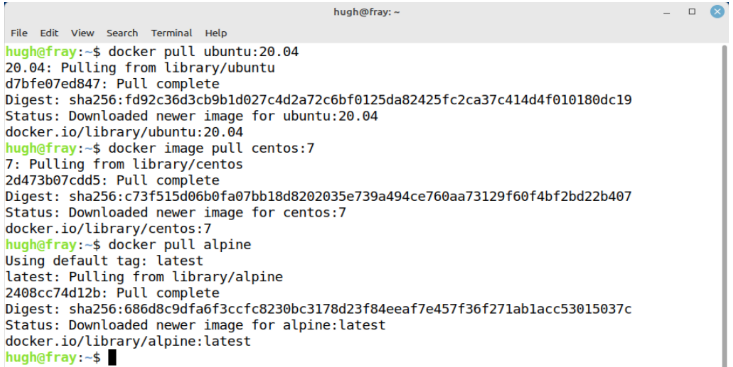

Operazioni su immagini

Le immagini sono contenute in un Registry.

Il Registry di default è su docker.io.

Vera URL corrente (non serve quasi mai saperla):

https://registry.hub.docker.com/v2/repositories/library

Il comando di gestione immagini è:

docker image sottocomando

I sottocomandi principali sono:

- docker image pull immagine

oppure

- docker pull immagine

compiono il download dell’immagine

--

- docker image ls

oppure

- docker images

lista le immagini locali

--

-

docker image rm IDimmagine

-

docker rmi IDimmagine

rimuove un’immagine locale.

IDimmagine è lo hash dell’immagine

Esempi

Registry

URL con protocollo https, alla quale docker si collega per scaricare immagini, con APi definite.

Il registry di default è: https://registry.hub.docker.com/, o https//hub.docker.com/, detto Docker Hub.

Vi sono in rete altri registries, p.es.:

- Quay (

https://quay.io/) - Google Container Registry (

https://cloud.google.com/container-registry/) - AWS Container Registry (

https://aws.amazon.com/ecr/)

E' possibile collegarsi liberamente (al momento) a Docker Hub, navigare per avere informazioni sulle immagini disponibili, e scaricare le immagini.

Per compiere l’upload occorre registrarsi

Il collegamento ad altri registries può prevedere una sottoscrizione a pagamento, e permette l'upload di immagini prodotte localmente.

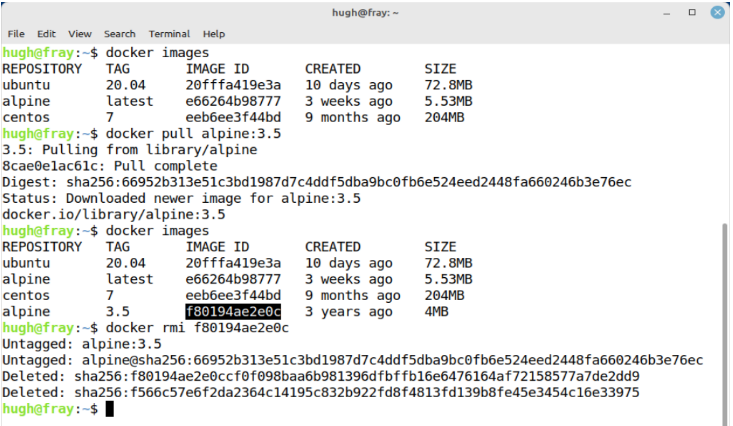

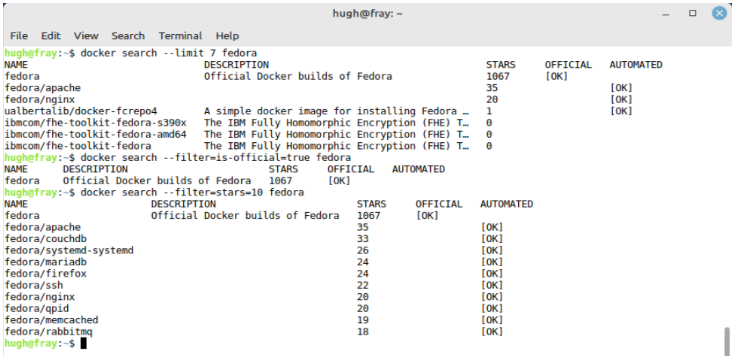

Ricerca di Immagine

Il comando è:

docker search [opzioni] immagine

Ricerca sul registry Docker Hub

Esempio:

docker search fedora

Tutte le immagini che contengono la stringa fedora

La lista ritornata è limitata alle prime 25 entries. Non si possono averne di più. Per averne di meno:

docker search --limit 4 fedora

Ogni immagine riceve stars - punti di valutazione. Limitare la ricerca ad un minimo di 3 stars:

docker search --filter=stars=3 fedora

Una delle immagini può essere ufficiale, le altre contribuite da persone registrate. Cercare solo l’immagine ufficiale;

docker search --filter=is-official=true fedora

Alcune immagini sono Automated Build: l’immagine viene ricompilata automaticamente al momento del download. Cercare le immagini non automated:

docker search --filter=is-automated=false fedora

Per avere una descrizione più completa

docker search --no-trunc fedora

Esempio

Nomi delle immagini

Struttura del Nome

Il nome di un’immagine ha il formato

autore/immagine:tag

ove:

- autore - è l’identificativo del produttore, registrato a docker.io e univoco in tale registry

- immagine - il nome dell’immagine, un autore può produrre più immagini, ciascuna con nome univoco

- tag - solitamente corrisponde alla versione

I seguenti componenti sono opzionali:

autore - se manca, si intende l’immagine ufficiale sancita da docker.io (massimo: una)

tag - se manca vale latest

Esempi:

debian

debian:9.0

s390x/debian

Ricerca Tag

Non esiste in docker search la funzionalità per conoscere i tag associati ad un’immagine.

Però si può scrivere una procedura shell.

Occorre l’utility jq che è simile a sed ma funziona su dati JSON:

sudo apt install jq

La procedura shell per cercare I tags di debian è quindi, p.es. dockertags.sh:

while [ $? == 0 ]

do

i=$((i+1))

curl https://registry.hub.docker.com/v2/repositories/library/debian/tags/?page=$i \

2>/dev/null|jq '."results"[]["name"]'

done

Scarico di Immagine

Il comando per scaricare da Docker Hub è:

docker pull immagine[:tag]

Se il tag non è indicato è latest

C’è l’opzione -a per scaricare tutti i tag.

Non usarla!: impiega troppo tempo e spazio disco

Esempio:

docker pull debian:9.0

Per un pull da un altro registry, non Docker Hub:

docker pull registry-URL/immagine[:tag]

docker pull registry-ip:porta/immagine[:tag]

Nota:

In caso di interruzione del pull di un'immagine, ripetendo il comando di pull il download ricomincia dall'inizio. La versione corrente ancora non supporta il ripristino di download.

Lista delle Immagini

Per listare le immagini locali:

docker image ls

docker images

Opzioni:

-q- quiet - lista solo gli ID-a- all - lista tutti i branches--digest- include il digest (checksum) delle immagini--no-trunc- mostra lo ID SHA per intero

Il chechsum SHA256 di un'immagine si chiama il suo Digest. Per aumentare la sicurezza si può includere nel comando di pull:

docker pull immagine:tag@digest

Per vedere i digest di un'immagine scaricata, p.es.:

docker images --digests alpine

Rimozione Immagini

Per rimuovere un'immagine:

docker rmi hash

P.es.:

docker rmi 820010c31e66

Viene rimossa l'immagine e tutti i suoi layers che non siano in condivisione con altre immagini.

Per (eventualmente) rimuovere tutte le immagini:

docker rmi -f $(docker images -q)

Attenzione che le immagini rimosse non sono più recuperabili se non riscaricandole dal registry

Salvataggio di Immagini

Per l’esercizio scaricare prima l’immagine golang:

docker pull golang

E’ possibile salvare un’immagine in un file tar, per eventuale asporto:

docker image save -o file.tar immagine

P.es.:

docker image save -o golang.tar golang

Senza l’opzione -o scrive su standard output.

Questo può essere utile quando si vuole comprimere un’immagine. p.es.:

docker image save golang | gzip - > golang.tgz

Recupero di Immagini

Per recuperare un’immagine da un file tar:

docker image load -i file.tar

P.es.:

docker image load -i golang.tar

Senza l’opzione -i legge da standard input.

Se l’immagine è compressa:

gunzip -c golang.tgz | docker image load

Dentro un’immagine ci sono tutti i suoi attributi. Questi vengono salvati e recuperati da save e load.

Si può ispezionare l’archivio tar con:

tar tvf golang.tar

Registry locale

Anzichè il registry Docker Hub si può usare un registry locale.

Un registry locale può venire fornito da un container:

docker run -d -p 5000:5000 --restart=always \

--name registry -v ~/.docker/registry:/var/lib/registry \

registry

Per salvare un’immagine al registry locale occorre prima taggarla:

docker tag ubuntu:20.04 localhost:5000/myubuntu

Ora si può salvare:

docker push localhost:5000/myubuntu

Proviamo a cancellarla e recuperarla:

docker rmi localhost:5000/myubuntu

docker pull localhost:5000/myubuntu

Lista del registry locale alla URL:

curl -X GET http://localhost:5000/v2/_catalog

L'immagine registry fornita dal Docker Hub non è molto sofisticata.

Ha i comandi di pull e push, ma mancano altri comandi di gestione amministrativa del registry.

La sua documentazione è su https://hub.docker.com/_/registry.

In alternativa è possibile usare il GitHub Container Registry se si possiede un account GitHub.

Contenitori di Processo

Un contenitore di processo è l’istanza di un’immagine.

Parallelo: file eseguibile → processo

Comando di generazione:

docker run [-ti|-d] [opzioni] immagine [comando]

Un comando di default può esistere nel contenitore.

Due tipi di contenitori:

- Interattivi

docker run -ti [opzioni] immagine [comando]

-ti - terminal interactive

Si interagisce tramite terminale col comando del contenitore- All’uscita il contenitore termina.

- Non interattivi

docker run -d [opzioni] immagine [comando]

-d - detached, in background

Altrimenti il pronto non torna.

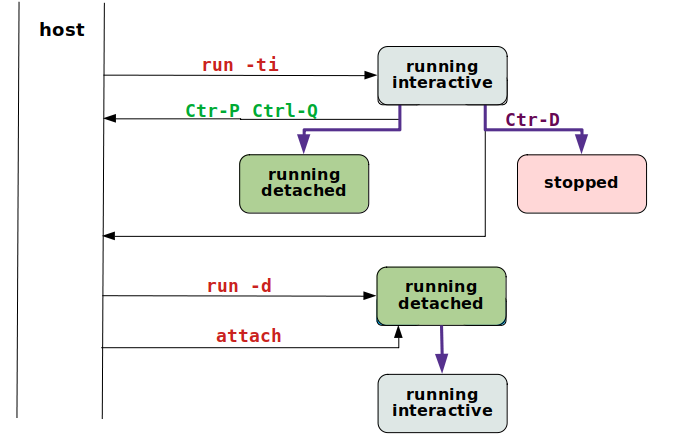

Contenitori interattivi

Esempio:

docker run -ti alpine:3.7

Il comando di default qui è /bin/sh.

Come risultato siamo dentro il sistema operativo Alpine.

Tutti i comandi che diamo sono quelli di Alpine.

Uscita temporanea:

Ctrl-P Ctrl-Q

Torna il pronto dello host Linux

Ispezione dei contenitori attivi:

docker ps

Notare lo id (hash) e il nome di fantasia assegnato d’ufficio al contenitore

Ritorno nel contenitore:

docker attach ID

oppure

docker attach nome

Uscita finale, da Alpine:

exit

Torna il pronto dello host linux. Il contenitore è terminato.

Lista contenitori attivi:

docker ps

Lista di tutti i contenitori, anche terminati

docker ps -a

I contenitori terminati vanno rimossi:

docker rm ID

oppure

docker rm nome

Eventuale rimozione di tutti i contenitori:

docker rm -f $(docker ps -aq)

Attenzione : si possono perdere dei dati importanti

Alpine Linux

La release Linux di riferimento per Docker è Ubuntu. Questa è anche l’immagine di base su cui molte immagini di applicativi sono costruite. Ma: richiede molti MB di disco.

Un’alternativa recente per lo sviluppo immagini di applicativi è Alpine Linux

- Molto ridotto nel footprint

- Richiede pochissimi MB di disco

Attenzioni:

- Alpine ha comandi di amministrazione diversi

- I comandi di base sono ottenuti con busybox

- L’ambiente runtime è MUSL e non GLIBC

Questo necessita di attenzioni quando si sviluppano eseguibili compilati dai contenitori

Contenitori detached

Contenitore interattivo

Sullo host scrivere la procedura shell forever.sh:

i=0

while true

do

sleep 2

i=`expr $i + 1`

echo $i

done

Lanciare un contenitore che esegue questa procedura:

docker run -ti alpine /bin/sh -c "$(cat forever.sh)"

L’output viene sul video del Linux host

Fermarlo: Ctrl-C

Verificare con docker ps -a che il contenitore è fermo

Test: perchè il seguente non funziona?

docker run alpine:3.7 /bin/sh forever.sh

Contenitore non interattivo

Lanciare un contenitore non interattivo che esegue la procedura:

docker run -d alpine /bin/sh -c "$(cat forever.sh)"

Il pronto torna subito, il contenitore è detached

Per vedere l’output:

docker logs IDalpine

Se ci si collega ad un contenitore detached:

docker attach IDalpine

Questo non è più detached e il suo output arriva sul terminale Linux host.

Quando si preme Ctrl-C torna il pronto host ma il contenitore è fermato.

Se invece si preme Ctrl-P Ctrl-Q torna il ptonto host e il contenitore non è fermato.

Rimuovere tutti i contenitori:

docker rm [-f] $(docker ps -qa)

-f - anche i contenitori non fermi

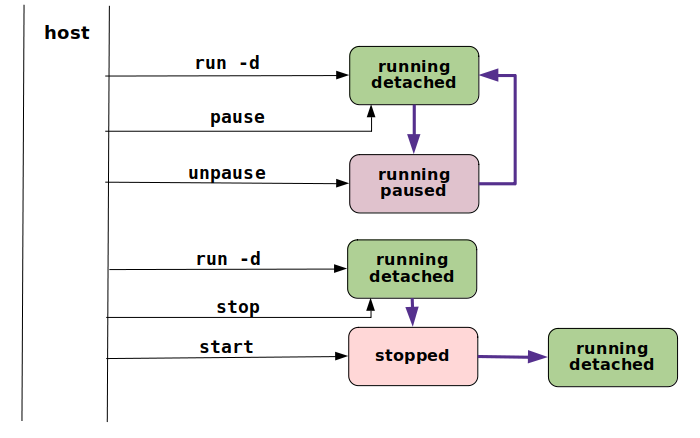

Operazioni sui contenitori

Pausa di Contenitore

Lanciare un contenitore non interattivo che esegue la nostra procedura:

docker run -d alpine /bin/sh -c "$(cat forever.sh)"

Ispezionare i logs:

docker ps - per sapere il nome

docker logs nome

Mettere in pausa il contenitore:

docker pause nome

docker ps

docker logs nome

Togliere la pausa dopo un po’:

docker unpause nome

docker ps

docker logs nome

Il comando docker pause non termina i contenitori ma li sospende temporaneamente

Fermare un Contenitore

Fermare il contenitore:

docker stop nome

docker ps

docker ps -a

docker logs nome

Riavviare il contenitore:

docker start nome

docker ps

docker logs

Un contenitore fermato e riavviato ricomincia dall’inizio

Al termine dell’esercizio fermare e rimuovere tutti i contenitori

Altre Operazioni

Forzare la rimozione di un container attivo:

docker rm -f ID

Lanciare un container in modalità 'detached':

docker run -d ubuntu:20.04 sleep 10000

Il container deve fare qualcosa

Eseguire un comando su un container attivo:

docker exec -ti ID_ubuntu bash

Il termine del comando shell (Ctrl-D) non ferma il container

Opzioni di Run

Il comando docker run ha numerosissime opzioni, alcune tra le più usate sono:

--rm - rimuove automaticamente il contenitore quando viene fermato

--name nome - assegna il nome indicato e non quello fantasia

Esempi:

docker run --rm -ti --name alp alpine:3.7 /bin/sh

- Lancia il contenitore col nome

alp - Rimuove il contenitore quando si dà il comando

exit - All’atto della rimozione di un contenitore vengono rimossi anche i suoi logs

Personalizzazioni

Formato del rapporto:

docker ps -a --format $FORMAT

ove:

export FORMAT="\nID\t{{.ID}}\nIMAGE\t{{.Image}}\

\nCOMMAND\t{{.Command}}\nCREATED\t{{.RunningFor}}\

\nSTATUS\t{{.Status}}\nPORTS\t{{.Ports}}\nNAMES\t{{.Names}}\n"

Anche:

alias dkp='docker ps -a --format $FORMAT'

alias dki='docker images'

alias dkr='docker rm'

Da inserirsi in .profile

Modifica di immagini

Lanciare uno nginx con un nome assegnato:

docker run -d --name my_nginxtemp1 nginx

docker ps

Ispezionare il contenitore e trovarne l'indirizzo IP assegnato:

docker inspect my_nginxtemp1 | grep IPAddress

Aprire il browser all'indirizzo IP indicato

Connettersi al container con una shell:

docker exec -i -t my_nginxtemp1 bash

Abbiamo una shell di root. Verificare la Document Root del server web:

cd /usr/share/nginx/html

ls

Sostituire index.html:

echo '<h1>CUSTOMIZED!</h1>' > index.html

Verificare col browser.

Uscire dal container:

exit

Creare una copia del container corrente come nuova immagine:

docker commit my_nginxtemp1 my_nginx1

Verificare:

docker images

Rimuovere il vecchio container e lanciarne uno nuovo con la nuova immagine:

docker rm -f my_nginxtemp1

docker run -d --name nuova1 my_nginx1

Verificare l'indirizzo IP:

docker inspect nuova1 | grep IPAddress

Verificare col browser all’indirizzo IP trovato.

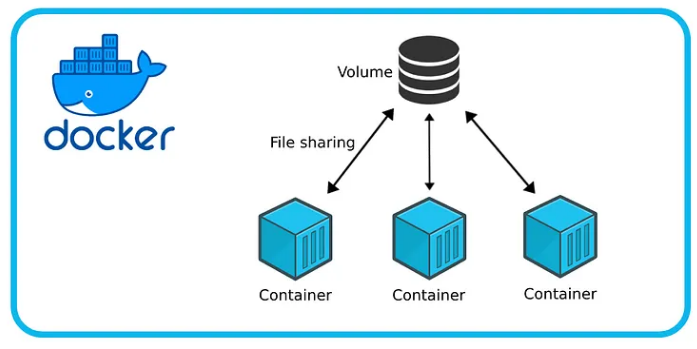

Contenitori di Dati

I contenitori lavorano su dati. Sorge il problema che i dati elaborati devono rimanere, persistere, anche quando i contenitori terminano di operare.

Questo problema è stato originariamente risolto compiendo un mappaggio tra dati sul contenitore e sulla macchina ospitante. La modifica di uno dei due lati del mappaggio è rispecchiata nella stessa modifica sull'altro lato.

Nella versione originale di Docker v'era solo il concetto di contenitori, corrispondente a quelli che ora chiamiamo contenitori di processo. Nelle versioni successive è avvenuta una differenziazione di tipi diversi di contenitori.

Sono stati introdotti i Contenitori di Dati, anche detti Volumi, che hanno un'esistenza indipendente dai Contenitori di Processo.

Docker si preoccupa quindi nativamente anche della gestione dei dati dell'applicativo. Altri ambienti simili, quali Kubernetes, non lo fanno e si basano su soluzioni esterne.

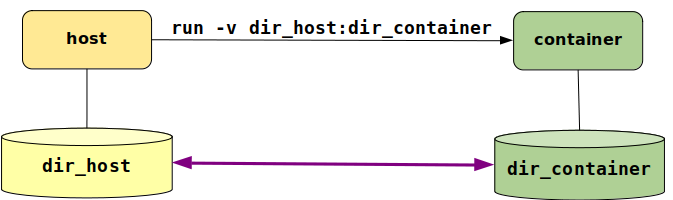

Mappaggio a host

Persistere i Dati

Quando un container è rimosso i suoi dati sono persi

Soluzione: mappare una directory dello host ad una directory del container, con l’opzione di lancio:

-v dir_host:dir_container

Mappaggio detto Host Mapping

- Si può usare l’opzione più volte, per più directories

- Si può effettuare solo al lancio del container

Dati Persistenti

Download di un web server:

docker pull nginx

Creare una directory web1 con il file index.html:

mkdir -p ~/docker/web1; cd ~/docker/web1; pwd

Editare il file index.utml:

<html><body>

<h1>FUNZIONA</h1>

</body></html>```

Lanciare un container che mappa la directory:

docker run -d -v ~/docker/web1:/usr/share/nginx/html nginx

Deve essere un percorso assoluto sullo host. Sul container può essere relativo alla dir di default

Verificare l'indirizzo IP del container:

docker inspect ID | grep IPAddress

Provare il collegamento via browser all’indirizzo IP

Condivisione di file

Si può condividere un singolo file:

cd

touch ~/docker/example.txt

Il file deve esistere prima di condividerlo al container o docker pensa che sia una directory e la crea

Da host:

cd

docker run --rm -ti --name sharing -v $PWD/docker/example.txt:/tmp/example ubuntu:14.04 bash

E nel contenitore:

echo "hello" > /tmp/example

exit

Ritornati sullo host:

cat ~/docker/example.txt

Note

I permessi di default del container sono di root

- Se una directory viene creata sullo host ha i permessi di root

- Altrimenti crearla manualmente prima del mappaggio

- Sempre attenzione ai permessi dei dati mappati

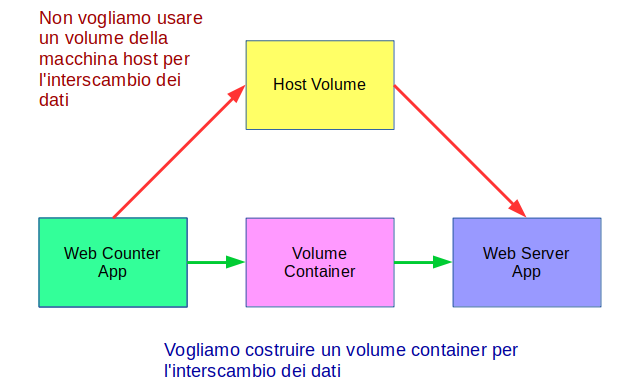

Volumi

Contenitori di Dati

I Contenitori di Dati sono formalmente chiamati Volumi.

- Sono interamente contenuti nel repository locale

- Non sono mappaggi al file system host

Due tipi:

-

Volume Persistente - continua ad esistere anche dopo la rimozione dei contenitori processo che lo usano

-

Volume Effimero - cessa di esistere con la rimozione dei contenitori che lo usano

Volume Persistente

Web Counter App

Costruiamo un'immagine che scrive alla webdir di nginx:

mkdir ~/docker/webcounter

cd ~/docker/webcounter

Editiamo il file webcounter.sh:

#! /bin/bash

x=0

while true

do

x=$[x + 1]

echo "<br/><h1>$x</h1>" > /usr/share/nginx/html/index.html

sleep 1

done

Costruiamo il file Dockerfile di specifica di una nuova immagine. Maggiori spiegazioni seguiranno.

FROM ubuntu

COPY webcounter.sh /usr/local/bin/webcounter.sh

RUN chmod +x /usr/local/bin/webcounter.sh

CMD ["/usr/local/bin/webcounter.sh"]

Con il Dockerfile costruiamo la nuova immagine my_webapp1:

docker build -t my_webapp1 .

Condivisione tramite volume

Creiamo il volume persistente:

docker volume create myvol

Non è visibile con docker ps -a ma con docker volume ls

Creiamo il contenitore di processi nginx che mappa il volume persistente alla sua directory di pagine statiche:

docker run -d --name web_server -v myvol:/usr/share/nginx/html -p 8080:80 nginx

Creiamo il contenitore di processi con l’applicativo, che prende il volume persistente da quello già mappato dal server:

docker run -d --name web_app --volumes-from web_server my_webapp1

Verifichiamo col browser a localhost:8080

Verifica della persistenza

Fermiamo e rimuoviamo i contenitori di processi:

docker stop web_server web_app

docker rm web_server web_app

Il contenitore dati esiste ancora:

docker volume ls

Rilanciamo un web_server rimappando il contenitore dati:

docker run -d --name web_server -v myvol:/usr/share/nginx/html -p 8080:80 nginx

Verifichiamo con il browser a localhost:8080

Nota

Questo non funziona:

Salvare il contenuto del contenitore dati - tentativo

Generare un’immagine

docker container commit web_server web_server_backup

Ora la si può salvare ad un file tar

docker image save -o web_server_backup.tar web_server_backup

Il commit di un contenitore dati non include i volumi dati montati

Volume Effimero

Volume effimero: scompare quando i container che lo usano sono terminati

Container che crea un volume:

docker run -ti --rm --name one -v /shared_data ubuntu bash

Container che usa un volume:

docker run -ti --rm --name two --volumes-from one ubuntu bash

Su two:

touch /shared_data/example

Su one:

ls /shared_data

E' visibile example

Terminare one. Su two è ancora visibile example.

Il volume mantenuto dal server docker

Se rilanciamo one con la stessa condivisione dati, two non lo vede più

Istanze diverse di volume condiviso

Backup e restore di volumi

Backup di Volume

Backup di un volume condiviso in un file tar

Creare la directory che ospiterà il tar:

mkdir backup

Lanciare un contenitore temporaneo:

docker run -d --rm \

-v myvol:/usr/share/nginx/html \

-v $PWD/backup:/backup ubuntu \

bash -c "cd /usr/share/nginx/html \

&& tar cvf /backup/myvol.tar ."

Si monta il volume

-v myvol:/usr/share/nginx/html

Si mappa la directory in cui viene prodotto il tar

-v $PWD/backup:/backup

Non si può usare ./backup perchè deve essere un percorso assoluto

Si esegue una shell bash passando il comando che va nella directory coi dati presi dal volume condiviso

cd /usr/share/nginx/html

ed esegue il tar

tar cvf /backup/myvol.tar .

Al termine del comando il contenitore termina e viene rimosso

Restore di Volume

Restore da un file tar

Creazione di un volume persistente:

docker volume create myvol1

Un contenitore temporaneo che compie il restore:

docker run -d --rm \

-v myvol1:/usr/share/nginx/html \

-v $PWD/backup:/backup ubuntu \

bash -c "cd /usr/share/nginx/html \

&& tar xvf /backup/myvol.tar"

Il file è estratto e va anche nel volume myvol1

Il contenitore ubuntu termina ma il volume dati persiste

Verifica: lanciare un contenitore che usa il volume dati:

docker run -d --name web_server -v myvol1:/usr/share/nginx/html -p 8080:80 nginx

Verificare col browser a localhost:8080

Utility esterna

Scaricare l’immagine:

docker pull loomchild/volume-backup

Esempio di backup di volume:

docker run -v myvol:/volume --rm loomchild/volume-backup backup - > myvol.tar.bz2

- Il file è compresso con

bzip2 - Il volume non deve al momento essere in uso da nessun contenitore processo

Esempio di restore di volume

Creare un volume destinazione, deve essere vuoto:

docker volume create myvol1

Eseguire il restore:

cat myvol.tar.bz2 | docker run -i -v myvol1:/volume --rm loomchild/volume-backup restore -

Verificare con:

docker run -d --name web_server -v myvol1:/usr/share/nginx/html -p 8080:80 nginx

docker prune

Rimuove oggetti di docker che non sono al momento in uso da parte di nessun contenitore di processo

- Non vi è nessun contenitore processi attivo che in questo momento usa l’oggetto

- Chiede conferma

Può essere molto pericoloso

docker volume prune- rimuove i volumi persistenti non in uso

Meglio usare: docker volume rm nome - il solo volume col nome

docker network prune- rimuove le reti non in uso

Meglio usare: docker network rm nome - la sola rete col nome

docker image prune- rimuove le immagini non in uso

Meglio usare: docker image rm nome - la sola immagine col nome

Contenitori di Reti

Un Contenitore di Rete è un oggetto Docker che implementa un Software Defined Network (SDN).

Ciò è ottenuto modificando automaticamente le tabelle di routing e NAT (Network Address Translation) nell'ambiente iptables di Linux.

Forwarding

Perchè le reti Docker funzionino è necessario che il forwarding (parametro kernel) di Linux sia abilitato.

Di solito lo è di default.

Proviamo a disabilitarlo:

sudo sysctl -w net.ipv4.ip_forward=0

Ora lanciamo un container:

docker run --ti --rm --name web1 -d alpine sh

Otteniamo l'avvertimento:

WARNING: IPv4 forwarding is disabled. Networking will not work.

Il container parte lo stesso, e ci troviamo nella sua shell. Ma non potremo eseguire comandi di rete.

Usciamo con exit. Il container è rimosso automaticamente poichè l'avevamo lanciato con l'opzione --rm.

Riabilitiamo il forwarding:

sudo sysctl -w net.ipv4.ip_forward=1

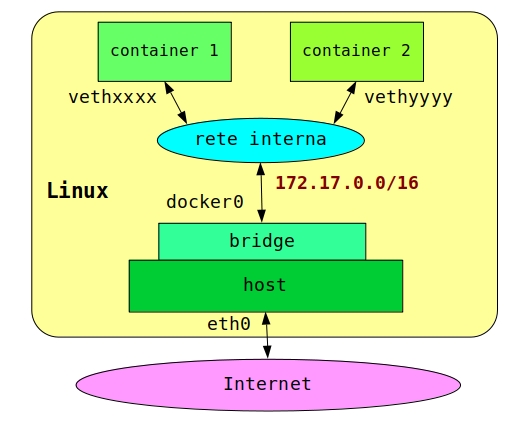

Dispositivi di rete

Rete di Base

Ad ogni container viene assegnata un’interfaccia sulla rete interna di default di Docker, 172.17.0.0/16, con un indirizzo IP in sequenza

Due containers diversi si vedono. Da macchina host:

docker run -ti --name one alpine sh

Dal container one:

ip a → IP: 172.17.0.2

Ctrl-P Ctrl-Q - per uscire senza fermare il contenitore

Da macchina host:

docker run -ti --name two alpine sh

Dal container two:

ip a → IP: 172.17.0.3

ping 172.17.0.2 → funziona

ma

ping one → non funziona

Non vi è un ambiente di risoluzione nomi indirizzi sulla rete interna di default

Port publishing

Se in un'immagine si trova un applicativo che apre una porta di rete, l'immagine espone (expose) tale porta di rete.

Quando dallo host lanciamo un container di quell'immagine occorre pubblicare (publish) tale porta di rete.

Con il comando ip scopriamo l'indirizzo IP della macchina host e chiamiamolo IPH.

Scarichiamo un'immagine che espone la porta 8080 e lanciamone un container.

NB

- Il fatto che l'immagine scaricata apra la porta 8080 non è conoscenza innata, ma ricavato dalla documentazione che l'autore dell'immagine ha fornito. Nel

Dockerfile(cf. ultra) di quell'immagine l'autore aveva specificato il parametroEXPOSE 8080. - Inoltre il programma eseguibile -- in questo caso un web server -- che era stato inserito nell'immagine, era in ascolto sulla porta 8080.

- Quando si usano immagini scaricate dal Docker Hub è necessario:

- avere la loro documentazione

- fidarsi che non compiano operazioni malefiche

docker run -d -p 8080 adejonge/helloworld

Avviene il Port Publishing parziale della porta 8080 del container ad una porta casuale della macchina host

Verificare il container con:

docker ps

Dal rapporto scopriamo la porta dello host che mappa al container, indichiamola con PH:

0.0.0.0:PH -> 8080/tcp

L'indirizzo IP 0.0.0.0 copre qualsiasi indirizzo IP della macchina host, sia quelli esterni che localhost.

Dallo host, o da qualsiasi altra macchina della rete su cui è lo host, puntare il browser a:

http://IPH:PH/

Il messaggio viene visualizzato

Terminare e cancellare il contenitore precedente:

docker ps

docker rm -f ID

Lanciare un container con Port Publishing completo:

docker run -d -p 8000:8080 adejonge/helloworld

Publish della porta 8080 del container alla porta 8000 dello host

Verificare col browser a http://localhost:8000

Infatti a qualsiasi indirizzo su cui lo host è in ascolto

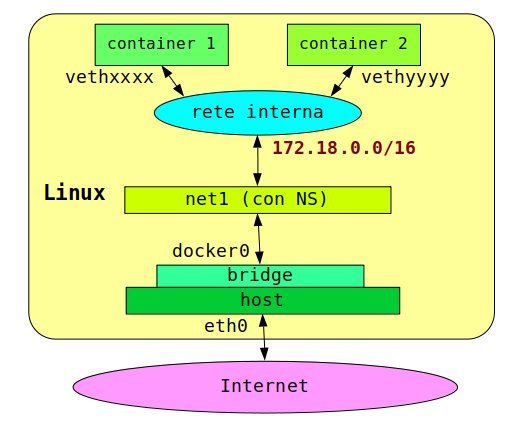

Reti con nome

Creazione Contenitori di Rete

Docker gestisce reti interne. Listarle:

docker network ls

Vi sono tre reti (driver) di base:

- bridge – sottorete di default per tutti i container

- host – rete dello host

- none - solo interfaccia di loopback

Quando si usano ambienti più complessi del Docker Base, per esempio Docker Swarm, vengono installati anche alri tipi di driver di rete, p.es. overlay.

Ispezionare i dettagli di rete (formato JSON):

docker network inspect bridge

Creare una nuova rete bridge:

docker network create net1

Lanciare due containers sulla nuova rete:

docker run -ti --net=net1 --name one alpine

docker run -ti --net=net1 --name two alpine

Si può uscire da un contenitore senza terminarlo con i tasti Ctl-P Ctrl-Q.

Per ritorbare dentro il contenitore, per esempio:

docker attach one

Da one:

ping two

Docker risolve internamente i nomi dei container nel loro indirizzo IP.

Opzioni di Creazione Rete

Sintassi:

docker network create [opzioni] rete

Opzioni principali:

--subnet CIDR- indirizzo di rete assegnato--internal- solo accesso da locale, non internet--driver nomedriver- default: bridge--gateway gw- indirizzo del gateway--attachable- si possono connettere containers alla rete--ipv6- abilita IPv6 sulla rete

Esempio:

docker network create --subnet 172.50.0.0/16 net2

Rimozione di Rete

Sintassi:

docker network rm rete

Esempio:

docker network rm net2

Si può rimuovere solo una rete per volta.

La rete che viene rimossa non deve avere contenitori che la usano. Prima rimuovere i contenitori.

Reti Host

Lo Host Networking consiste nel mappare tutte le porte del container alle stesse porte dello host.

Esempio con Host Networking:

docker run -d --net=host adejonge/helloworld

- Condivide l'indirizzo IP dello host

- Non viene più usato il bridge vethxxxx

Verificare con ifconfig e docker ps

Solo un container può usare la porta 8080 se in modalità Host Networking.

Dockerfile

Un Dockerfile è un file di specifiche per la creazione di un'immagine Docker.

Il file deve chiamarsi Dockerfile e deve essere in una directory di contesto: vedrà tutti i files al di sotto di essa.

Non usare mai la directory radice come directory di contesto.

Tutti i files della directory di contesto e sottodirectories devono essere leggibili e scrivibili.

Il file è in formato ASCII (veramente UTF-8) e contiene una serie di direttive come parole chiave.

Le direttive non sono case-sensitive, ma vengono convenzionalmente poste in maiuscolo.

L'arte di costruzione di un Dockerfile complesso è molto importante: permette di inserire un applicativo da noi sviluppato all'interno di una immagine Docker.

Tale immagine viene poi tipicamente usata in ambienti di esecuzione distribuita, come p.es. Kubernetes.

Build di immagini

Semplice Dockerfile

Occorre creare il Dockerfile.

Vogliamo un'immagine per il contatore infinito:

mkdir -p ~/docker/ex/dk1

cd ~/docker/ex/dk1

vim forever.sh

#! /bin/bash

x=0

while true

do

x=$[x + 1]

echo $x

sleep 1

done

Editare il Dockerfile:

vim Dockerfile

FROM ubuntu

MAINTAINER Hugh Fray <hugh@stormforce.ac>

COPY forever.sh /usr/local/bin/forever.sh

RUN chmod +x /usr/local/bin/forever.sh

CMD ["/usr/local/bin/forever.sh"]

Costruire l'immagine:

docker build -t forever1 .

Ove:

-t forever1: nome che diamo all'immagine.: directory di build

Verificare e lanciare l'immagine costruita:

docker images

docker run -d --name my_forever1 forever1

docker logs my_forever1

Dockerfile più complesso

Un possibile sempio di Dockerfile per nginx.

Nella directory di contesto:

mkdir -p ~/docker/ex/nginx-ubuntu

cd ~/docker/ex/nginx-ubuntu

vim Dockerfile

FROM ubuntu

# Install Nginx.

RUN \

apt-get update && \

apt-get install -y nginx && \

rm -rf /var/lib/apt/lists/* && \

echo "\ndaemon off;" >> /etc/nginx/nginx.conf && \

chown -R www-data:www-data /var/lib/nginx

# Define mountable directories.

VOLUME ["/etc/nginx/sites-enabled", "/etc/nginx/certs", "/etc/nginx/conf.d", "/var/log/nginx", "/var/www/html"]

# Define working directory.

WORKDIR /etc/nginx

# Define default command.

CMD ["nginx"]

# Expose ports.

EXPOSE 80

EXPOSE 443

Perchè tutti gli &&

Si può avere in alternativa:

- una serie di comandi RUN ciascuno dei quali compie un'operazione

- un unico comando RUN che compie più operazioni concatenate da

&&

Il secondo metodo è migliore per i seguenti motivi:

- Ogni RUN produce un'immagine intermedia, appesantendo il processo di generazione

- L'operatore && non esegue il comando che segue se quello precedente è fallito e termina subito il processamento del Dockerfile.

Ogni singolo RUN di successo procede al prossimo RUN e se uno degli ultimi fallisce, occorre più tempo per interrompere il processamento del Dockerfile.

Generazione di Immagine

Posizionarsi nella directory di contesto

- contiene il Dockerfile e tutto quello che serve

Generazione:

docker build [opzioni] -t immagine .

Opzioni principali:

--no-cache- ricostruisce completamente da zero-q- sopprime i messaggi di progresso ad output

Vi sono numerose altre opzioni. Listarle con:

docker build --help

Nel nostro esempio:

cd ~/docker/ex/nginx-ubuntu

docker build -t nginx-ubuntu .

Con base Ubuntu è un processo piuttosto lungo.

Direttive del Dockerfile

Direttive Comuni

FROM

FROM immagine - specifica l'Immagine di Base da cui si sta costruendo. Deve essere la prima istruzione del file.

RUN

Esecuzione di un comando all'interno dell'immagine in costruzione.

Vi sono due tipi di RUN:

RUN comando- il comando è eseguito in una shell, che per default è /bin/sh -c su LinuxRUN ["eseguibile", "param1", "param2"]- vettore di lancio di un comando qualsiasi, generato con exec

Un comando RUN che si estende su più linee ha ciascuna linea terminata dal carattere di escape, di default \, immediatamente prima del NEWLINE.

LABEL

LABEL chiave=valore ...

Etichette a chiave.

MAINTAINER

MAINTAINER email - gestore del Dockerfile corrente

Ddeprecato, usare p.es.

LABEL maintainer="michele@simioli.it"

CMD

CMD comando - definisce il comando da eseguire al lancio del container, deve essercene esattamente uno.

Tre varianti di CMD:

CMD ["eseguibile","param1","param2"]- vettore di lancio in formato execCMD comando param1 param2- formato shellCMD ["param1", "param2"]- parametri relativi allo ENTRYPOINT

ENTRYPOINT

Sintassi come CMD ma solo nei due formati:

ENTRYPOINT ["eseguibile", "param1", "param2"]ENTRYPOINT comando param1 param2

WORKDIR

WORKDIR dir - directory di lavoro per il comando, una sola

ADD

ADD sorgente... destinazione - aggiunge i file locali sorgente alla destinazione sull'immagine

sorgentepuò contenere caratteri jolly, e deve essere nel contesto del builddestinazionedeve essere un percorso assoluto o relativo a WORKDIR- la destinazione appartiene a UID=0 e PID=0

- se sorgente o destinazione terminano con / sono considerate directories

- in caso di copia multipla la destinazione deve essere una directory

- se la destinazione è una directory innestata, tutti i percorsi intermedi vengono creati

COPY

Stesso effetto e sintassi di ADD.

COPY sorgente... destinazione

ENV

ENV chiave[=]valore ... - settaggio di variabili d'ambiente mell'immagine

- ci può essere un = o uno spazio come separatore

- ve ne possono essere più di uno

VOLUME

VOLUME "dir" - crea un punto di montaggio per un volume fornito esternamente

- deve esserci un solo argomento, ma può essere un array in formato JSON

- "dir" deve essere un percorso assoluto

EXPOSE

EXPOSE porta - porta TCP/IP su cui ascoltare a runtime

USER

USER utente - definisce l'utente coi cui diritti viene eseguito CMD

Direttive Meno Comuni

SHELL

SHELL ["eseguibile", "parametro"] - definisce la shell con cui eseguire i comandi seguenti

- default:

SHELL ["/bin/bash", "-c"] - ve ne può essere più di uno definito nel Dockerfile: determina il comportamento per le istruzioni seguenti

ONBUILD

ONBUILD istruzione - definisce un trigger, un comando che deve venire eseguito quando l'immagine corrente è nel FROM di un altro Dockerfile

- ve ne può essere più di uno

ARG

ARG nome[=valore] - definisce un argomento per l'opzione di build --build-arg nome=valore

- ve ne può essere più di uno

- tutti gli argomenti forniti nel comando build devono essere previsti nel Dockerfile

- se un argomento non è fornito nel comando di build, ARG deve dargli un valore di default

STOPSIGNAL

STOPSIGNAL segnale - determina il segnale che viene inviato al container dal comando docker stop ID - default SIGTERM

Esempio d'uso

Esempio: nginx-alpine

Illustra l’importanza della Directory di Progetto (o di Contesto).

In un’immagine possono essere inseriti dei file

- File di configurazione

- Procedure shell

- ecc.

Tutti tali file si trovano nella directory di progetto, oppure in sue sottodirtctories.

La Directory di Progetto contiene il Dockerfile.

Directory di progetto:

mkdir -p ~/docker/ex/nginx-alpine

cd ~/docker/ex/nginx-alpine

vim Dockerfile

FROM alpine

# Install nginx package and remove cache

RUN apk add --update nginx && rm -rf /var/cache/apk/*

# Copy basic files

COPY nginx.non-root.conf /etc/nginx/nginx.conf

COPY index.html /usr/share/nginx/html/index.html

EXPOSE 8080

VOLUME ["/usr/share/nginx/html"]

# root user will run 'nginx: master process'

# nobody user will run 'nginx: worker process' as dictated in the nginx.non-root.conf

CMD ["nginx", "-g", "daemon off;"]

Nginx ha bisogno di un file di configurazione:

vi nginx.non-root.conf

worker_processes 1;

user nobody nobody;

error_log /dev/stdout;

pid /tmp/nginx.pid;

events {

worker_connections 1024;

}

http {

# Set an array of temp and cache files options

# that otherwise defaults to

# restricted locations accessible only to root.

client_body_temp_path /tmp/client_body;

fastcgi_temp_path /tmp/fastcgi_temp;

proxy_temp_path /tmp/proxy_temp;

scgi_temp_path /tmp/scgi_temp;

uwsgi_temp_path /tmp/uwsgi_temp;

# mime types

include /etc/nginx/mime.types;

default_type application/octet-stream;

server {

listen 8080;

root /usr/share/nginx/html;

access_log /dev/stdout;

error_log /dev/stdout;

}

}

E infine una pagina iniziale:

vim index.html

<html>

<head>

<title>Nginx with Alpine Linux</title>

</head>

<body>

<h1>Nginx with Alpine Linux</h1>

</body>

</html>

Build dell'immagine che chiameremo nginx-alpine:

docker build -t nginx-alpine .

Impiega molto meno tempo che con Ubuntu e l’immagine risultante è molto più piccola.

Test:

docker run -d -p 8888:8080 --name ngalp nginx-alpine

Verifica col browser a URL localhost:8888

Entrypoint

Un ENTRYPOINT ha i compiti di:

- verificare la sintassi e le opzioni del CMD

- inizializzare l’ambiente

Un ENTRYPOINT è una procedura shell con la struttura:

#! /bin/sh

.....

exec “$@”

La procedura deve iniziare con lo hash-bang, nel nostro caso #! /bin/sh

L’ultima istruzione eseguita è il chain command: esegue il CMD con gli eventuali parametri.

Esempio: postgres-alpine

Directory di progetto:

mkdir -p ~/docker/ex/postgres-alpine

cd ~/docker/ex/postgres-alpine

Dockerfile;

vim Dockerfile

FROM alpine:3.1

RUN apk add --update postgresql curl

RUN curl -o /usr/local/bin/gosu \

-SL "https://github.com/tianon/gosu/releases/download/1.2/gosu-amd64"

RUN chmod +x /usr/local/bin/gosu

RUN apk del curl && rm -rf /var/cache/apk/*

RUN mkdir /docker-entrypoint-initdb.d

RUN mkdir -p /var/run/postgresql && \

chown -R postgres /var/run/postgresql

ENV LANG en_US.utf8

ENV PATH /usr/lib/postgresql/9.3/bin:$PATH

ENV PGDATA /var/lib/postgresql/data

VOLUME /var/lib/postgresql/data

COPY docker-entrypoint.sh /

RUN chmod +x docker-entrypoint.sh

ENTRYPOINT ["/docker-entrypoint.sh"]

USER postgres

EXPOSE 5432

CMD ["postgres"]

Notare che la prima direttiva, FROM alpine:3.1, ha un'immagine con tag.

Non vogliamo usare il tag implicito latest ma una versione di alpine ben nota.

Con opportuna ricerca documentale in rete, abbiamo infatti scopero che alpine 3.1 ha nei suoi repository software la release postgres 9.3, che è la specifica versione che vogliamo installare.

Nostro Entrypoint

Uno entrypoint ha il compito di preparare l’ambiente al CMD che poi viene eseguito.

E’ quasi sempre una procedura shell.

Requisiti per la preparazione di immagini:

- conoscenza di comandi amministrativi Linux nella distribuzione scelta per l’immagine di base

- Ubuntu vs Alpine

- conoscenza della programmazione shell

- conoscenza di utilities che permettano il cambiamento batch e non interattivo di files di configurazione

sed,awk,tr, ecc.

vim entrypoint.sh

#!/bin/sh

chown -R postgres "$PGDATA"

# if the datadir does not exist, create it

if [ -z "$(ls -A "$PGDATA")" ]; then

gosu postgres initdb

# listen on all network addresses

sed -ri "s/^#(listen_addresses\s*=\s*)\S+/\1'*'/" "$PGDATA"/postgresql.conf

# acquire or set environment variables

: ${POSTGRES_USER:=postgres}

: ${POSTGRES_DB:=$POSTGRES_USER}

# if the password exists, use it with MD5

if [ "$POSTGRES_PASSWORD" ]; then

pass="PASSWORD '$POSTGRES_PASSWORD'"

authMethod=md5

# otherwise warn, then trust an access without it

else

cat >&2 <<-'EOWARN'

****************************************************

WARNING: No password has been set for the database.

****************************************************

EOWARN

pass=

authMethod=trust

fi

# prepare the rest of the environment

if [ "$POSTGRES_DB" != 'postgres' ]; then

gosu postgres postgres --single -jE <<-EOSQL

CREATE DATABASE "$POSTGRES_DB" ;

EOSQL

echo

fi

if [ "$POSTGRES_USER" = 'postgres' ]; then

op='ALTER'

else

op='CREATE'

fi

gosu postgres postgres --single -jE <<-EOSQL

$op USER "$POSTGRES_USER" WITH SUPERUSER $pass ;

EOSQL

echo

# allow anybody to connect from any IP address

{ echo; echo "host all all 0.0.0.0/0 $authMethod"; } >> "$PGDATA"/pg_hba.conf

exec gosu postgres "$@"

fi

exec "$@"

Le procedure shell, specie per entrypoint, possono essere complesse. Occorre acquisire un certo livello di esperienza di programmazione shell.

Utility gosu

L’invocazione di una procedura shell la esegue in una sottoshell, figlia di quella corrente.

- Questo non si deve fare in un Entrypoint, se si vogliono compiere cambiamenti all’ambiente che durino

- Al termine della sottoshell i cambiamenti sparirebbero

Si può usare gosu:

gosuesegue il suo argomento nella shell corrente, non in una sottoshell- riceve eventuali segnali inviati alla shell originale

- è un programma originalmente scritto in Go

Alpine lo ha come package nativo nelle versioni più recenti, in quelle precedenti occorre scaricarlo da https://github.com/tianon/gosu

Build e Test

Build:

docker build -t postgres-alpine .

Lancio del contenitore:

docker run --name postalp -p 5435:5432 postgres-alpine

(porta 5435 non 5432 sullo host per evitare potenziali collisioni con un postgres già installato)

Tattica di debugging:

- La prima volta non mettere l’opzione

-d(detached)- L’output andrà su video

- Permette il debugging specie di

docker-entrypoint.sh

- Fermare con Ctrl-C e rimuovere il contenitore

- Le volte successive mettere l’opzione

-d

Strategie d'Uso

Commit o Dockerfile

Due modi per creare un'immagine Docker:

- creare un Dockerfile e lanciare un docker build

- run di un container, modificarlo, e lanciare il comando

docker commit contenitore immagineper generare una nuova immagine

Meglio il Dockerfile:

- L'immagine di base può non essere adatta ai nostri scopi e vogliamo successivamente cambiarla

- col commit è praticamente impossibile

- col Dockerfile basta cambiare una linea

- Col commit non si può riprodurre un'immagine

- Il Dockerfile produce documentazione dei passi che sono stati seguiti nella costruzione dell'immagine

- Nel Dockerfile si possono inserire campi LABEL poi visibili col comando docker inspect

- E' possibile copiare il Dockerfile stesso nell'immagine che viene costruita, come ulteriore documentazione portatile

Dockerfiles in Rete

In un mondo realistico moderno:

- il sofware è disponibile in formato Open Source

- per molti applicativi i Dockerfile sono reperibili in rete

- le immagini Docker già pronte possono essere problemi di sicurezza

Esempio: nginx

Troviamo il sito del Dockerfile e scarichiamolo

git clone https://github.com/nginxinc/docker-nginx.git

Andiamo nella directory di contesto generata dal clone:

cd docker-nginx/stable/alpine

Generiamo il progetto:

docker build -t nginx-alpine-src .

Occorrerà molto tempo per la compilazione dei sorgenti, ma non dovrebbero esservi errori.

Miracolo Open Source non Docker.

Complementi

Il mondo Docker è vasto. Vi sono parecchi aspetti aggiuntivi che si potrebbero trattare rispetto ad un'esposizione di base.

Gli argomenti di questa sezione non sono indispensabili, ma aggiungono un certo livello di comprensione.

Vengono considerati esempi a supporto delle seguenti asserzioni forti:

- Non è una buona idea creare immagini contenenti applicativi grafici interattivi

- Il miglior linguaggio di programmazione per lo sviluppo di applicativi da inserire in immagini Docker, è il Linguaggio Go

Clients X Window

Supponiamo di voler costruire un'immagine che produca il client grafico Firefox.

mkdir -p ~/docker/ex/xwin

cd ~/docker/ex/xwin

vim Dockerfile

FROM ubuntu:14.04

RUN apt-get update && apt-get install -y firefox

# Replace 1000 with your user / group id

RUN export uid=1000 gid=1000 && \

mkdir -p /home/developer && \

echo "developer:x:${uid}:${gid}:Developer,,,:/home/developer:/bin/bash" >> /etc/passwd && \

echo "developer:x:${uid}:" >> /etc/group && \

echo "developer ALL=(ALL) NOPASSWD: ALL" > /etc/sudoers.d/developer && \

chmod 0440 /etc/sudoers.d/developer && \

chown ${uid}:${gid} -R /home/developer

USER developer

ENV HOME /home/developer

CMD /usr/bin/firefox

Costruire l’immagine con:

docker build -t firefox .

Impiega un tempo lunghissimo.

Deve scaricare e installare circa cento componenti e librerie che compongono il sistema X Window.

Docker è inteso per i server, non per i client grafici.

Al termine, lanciare con:

docker run -ti --rm \

-e DISPLAY=$DISPLAY \

-v /tmp/.X11-unix:/tmp/.X11-unix \

firefox

C’è un mappaggio del socket unix di X Window

- X Window in Ubuntu funziona solo con socket Unix non Inet

Se di usa --net=host per mappare tutti i socket:

docker run --rm -e DISPLAY --net=host firefox

Immagini e linguaggio Go

Immagine con Compilatore Go

Usiamo il metodo manuale:

- partire da un'immagine di base

- aggiungere il software necessario

- clonare il contenitore in una nuova immagine

Partiamo da Alpine:

docker run -ti --name alpine alpine sh

Aggiorniamo l’ambiente e aggiungiamo pacchetti:

apk update

apk add vim

apk add git

Installiamo il supporto go per vim da Github:

cd

git clone https://github.com/fatih/vim-go.git \

~/.vim/pack/plugins/start/vim-go

Installiamo go:

apk add go

apk add musl-dev

Alpine usa la libreria runtime MUSL non GLIBC. Occorre installarne il pacchetto di sviluppo.

Prepariamo lo scaffolding di go:

su -

mkdir -p ~/go/src ~/go/bin ~/go/pkg

Aggiunta dei plugin go a vim. Lanciare vim:

vim

Dare il comando vim (preso dal supporto installato)

:GoInstallBinaries

La possibilità di dare comandi interattivi uno dei motivi per cui alle volte si preferisce una costruzione manuale di immagine a quella tramite Dockerfile. Quest'ultimo permette solo l'esecuzione di comandi batch.

Attendere il completamento e uscire da vim con :q Enter

Prepariamo l’ambiente editando /root/.profile:

cat <<EOF >> /root/.profile

export GOROOT=/usr/lib/go

export GOPATH=/root/go

export GOBIN=\$GOPATH/bin

export GO111MODULE=off

export PATH=~/bin:\$GOBIN:\$GOROOT/bin:\$PATH

EOF

Uscire dal contenitore con Ctrl-P Ctrl-Q, NON col comando exit.

Sulla macchina host generiamo la nuova immagine:

docker commit alpine vimgo

Attenzione: è grosso, ci vuole tempo.

Uso di vimgo

Creare una directory locale da condividere:

mkdir -p ~/bin

Lanciare il contenitore:

docker run --rm -ti --name vimgo \

-v ~/bin:/root/go/bin vimgo su -

Il comando eseguito, su -, lancia una shell di login di root, che dal .profile setta tutte le variabili d'ambiente.

E' necessario eseguire su - perchè se si esegue semplicemente sh parte una shell senza ambiente.

Scrittura di un semplice programma in Go:

cd go/src

mkdir hello

cd hello

vim hello.go

package main

import "fmt"

func main() {

fmt.Println("vim-go")

}

Compilazione statica:

go build --buildmode=exe --ldflags '-linkmode external \

-extldflags "-static" -s' hello.go

Copia nella cartella condivisa:

cp hello ~/go/bin

Uscire dal contenitore con exit.

Il contenitore è automaticamente rimosso poichè era stato lanciato con l'opzione --rm.

Provare in locale:

~/bin/hello

Immagine e Go

Produrremo un altro eseguibile Go linkato staticamente e lo inseriremo in un'immagine.

Preparazione del progetto:

mkdir -p ~/docker/ex/go

cd ~/docker/ex/go

Partenza di Vimgo:

```bash

docker run --rm -ti --name vimgo \

-v $PWD:/root/go/bin vimgo su -

Questa volta mappiamo la directory corrente a quella degli eseguibili Go sul contenitore.

Prepariamo lo scaffolding:

cd go/src

mkdir helloworld

cd helloworld

vim helloworld.go

package main

import (

"fmt"

"net/http"

)

func helloHandler(w http.ResponseWriter, r *http.Request) {

fmt.Fprintln(w, "Hello World from Go in Docker")

}

func main() {

http.HandleFunc("/", helloHandler)

fmt.Println("Started, serving at 8080")

err := http.ListenAndServe(":8080", nil)

if err != nil {

panic("ListenAndServe: " + err.Error())

}

}

E’ un web server sulla porta 8080 che da un semplice messaggio.

Compilazione statica:

go build --buildmode=exe --ldflags '-linkmode external \

-extldflags "-static" -s' helloworld.go

Copia nella cartella condivisa:

cp helloworld ~/go/bin

Uscire dal contenitore con exit. Il contenitore è automaticamente rimosso.

Generazione dell'Immagine

Dovrebbe esserci nella directory corrente il file eseguibile helloworld, prodotto col contenitore.

Scrivere il Dockerfile:

vim Dockerfile

FROM scratch

ADD ./helloworld /helloworld

EXPOSE 8080

CMD ["/helloworld"]

scratch è il nome di un'immagine vuota.

Un programma Go è già il 99% di un’immagine.

Solitamente si parte da un'immagine di base perche fornisce uno scheletro di ambiente operativo di cui il nostro applicativo ha bisogno: librerie, ma anche aggancio a funzionalità del kernel, come gestione memoria e schedulazione.

Un eseguibile Go linkato staticamente non ha bisogno di librerie. Inoltre è fornito di serie di un monitor operativo, nello spazio user, che fornisce:

- schedulazione concorrente

- allocazione di memoria

- garbage collection

Non ha quindi bisogno neppure di uno stub di sistema operativo sottostante.

Compiere il build:

docker build -t greet .

Lanciare un container per testare:

docker run -d --rm --name saluti greet

Controllare alla URL: localhost:8080.

Al termine fermare il container che verrà automaticamente rimosso:

docker stop saluti

Chain Build

Possiamo compiere due migliorie:

- usare un'immagine per il compilatore Go già disponibile su Docker Hub, anzichè la nostra

vimgo - compiere la compilazione e subito la preparazione di un'immagine finale con un unico Dockerfile, usando la tecnica del chain build

Preparare un programma demo:

mkdir -p ~/docker/ex/demo

cd ~/docker/ex/demo

vim main.go

package main

import (

"fmt"

"log"

"net/http"

)

func handler(w http.ResponseWriter, r *http.Request) {

fmt.Fprintln(w, "Hello, 世界")

}

func main() {

http.HandleFunc("/", handler)

fmt.Println("Running demo app. Press Ctrl+C to exit...")

log.Fatal(http.ListenAndServe(":8888", nil))

}

Preparare il Dockerfile.

vim Dockerfile

FROM golang:1.17-alpine AS build

WORKDIR /src/

COPY main.go go.* /src/

ENV GO111MODULE="off"

RUN CGO_ENABLED=0 go build -o /bin/demo

FROM scratch

COPY --from=build /bin/demo /bin/demo

EXPOSE 8888

ENTRYPOINT ["/bin/demo"]

Build dell’immagine myhello:

docker build -t myhello .

Test dell'immagine:

docker run -d --rm --name try -p 8888:8888 myhello

Connessione al contenitore:

curl localhost:8888

Al termine del test, stop del contenitore, che lo rimuove.

Sicurezza

La sicurezza di un qualsiasi applicativo è un aspetto primario.

Anche applicativi in contenitori Docker hanno problemi di sicurezza. Questi possono essere dovuti a:

- vulnerabilità di Docker - usare una versione recente del Docker Engine, ove siano state applicate le patch ai problemi di sicurezza riscontrati

- esposizioni di configurazione - usare metodi di configurazione ed uso dell'ambiente Docker che minimizziono le esposizioni

- mancata mitigazione di problemi - limitare le risorse disponibili ai contenitori Docker in modo da limitare l'impatto di minacce realizzate con successo

Contenitori e sicurezza

Considerazioni Generali

Vi possono essere notevoli problemi di sicurezza nell'uso di default di contenitori:

- I permessi di default di docker sono quelli di root

- Usare Docker vuol dire caricare immagini non garantite dalla rete e lanciarle coi permessi di root

“Will you walk into my parlour?” - said the spider to the fly.

Prima Regola: Non scaricare immagini non fidate

- l'immagine ufficiale di un prodotto su Docker Hub si può considerare fidata

- altre immagini di altri produttori, anche su Docker Hub, non sono da considerarsi fidate

Docker Hub da la possibilità di compiere l'upload di immagini pubbliche. Non ne compie un'analisi di sicurezza.

Le uniche immagini veramente fidate sono quelle che abbiamo costruito noi, manualmente o tramite Dockerfile.

Seconda Regola: Progettare i programmi dentro i container con le stesse avvedutezze dei programmi dello host

- I server devono diminuire i privilegi

- Meglio sottoporre i contenitori a pentesting

- Controllare i log dello host

Terza Regola: Attenzione allo host mapping

Esempio pericoloso. Considerare il comando:

docker run --rm -v /:/homeroot -it alpine sh

Il processo sh del contenitore ha i diritti di root nel contenitore, ma anche sul sistema host se riesce ad uscirne. Il mappaggio -v /:/homeroot fa sì che modifiche alla cartella /homeroot del contenitore corrispondano a modifiche di / del sistema host.

Sicurezza del Server

Un server con docker dovrebbe avere solo docker come servizio attivo.

- Spostare gli altri servizi ad altri server

- Se non è possibile, spostare tutti gli altri servizi in containers

- Si può lasciare

sshdma solo con autenticazione a chiave condivisa, non password

Il server docker espone una REST API al client docker su una socket unix.

E' possibile attivarlo su una socket inet ma è estremamente pericoloso perchè espone il servizio ad attacchi Cross Site Request Forgery (XSRF).

- Limitare l'accesso al client docker - gli utenti che appartengono al gruppo

dockersono fidati e responsabili, possibilmente già con mansioni amministrative sullo host - Lanciare i comandi docker dallo host locale - prima usare

sshper accedere al server docker, poi dare comandi che eseguono in locale

Contenitori in Macchine Virtuali

Questo aggiunge uno strato di sicurezza, ma va in controtendenza alla filosofia dei contenitori.

Un contenitore che conduca un attacco di diniego di servizio può riuscire al massimo a consumare tutte le risorse della VM, non del sistema host, di altri contenitori sul sistema host o di altri contenitori in altre VM.

E' una soluzione da adottarsi solo in caso di sospetto su un contenitore particolare, non di prammatica.

Idealmente:

- le immagini di base sono derivate da repositories ufficiali di fiducia

- le immagini dipendenti, che richiedono quelle base, hanno un Dockerfile di specifica

- tutte le immagini derivate sono conservate su un repository locale

Docker Content Trust

Servizio offerto da Docker.io. Pull solo di immagini firmate dal fornitore.

Va abilitato:

export DOCKER_CONTENT_TRUST=1

Download del certificato di firma dal repository. Questo va accettato separatamente, come con SSH.

Ha un costo di licenza.

Permette anche l'upload di immagini firmate. Generata coppia di chiavi ed un certificato. Chiave privata in: ~/.docker/trust/private

Per scaricare un'immagine non firmata, quando il trust è abilitato, usare il comando:

docker pull --disable-content-trust immagine

Il Docker Content Trust non protegge da attacchi Man-In-The-Middle (MITM) o di Ingegneria Sociale.

Per configurare un repository locale con Docker Content Trust occorre installare un Notary Server. Anche questo è offerto come servizio aggiuntivo a licenza dalla Docker.io.

Capabilities

Da Linux 2.2 root non può fare tutto.

Esistono Capabilities (circa 30). Per listarle:

man capabilities

Root su host ha la capability sys-admin,

I container di docker non hanno tutte la capabilities dello host, ma un sottoinsieme limitato.

Si possono aggiungere e togliere capabilities.

Esempi:

docker run --cap-drop setuid --cap-drop setgid -ti ubuntu bash

docker run --cap-add all --cap-drop sys-admin -ti ubuntu bash

Per lanciare un contenitore con tutte le capabilities aggiungere l'opzione --privileged.

Minimo Privilegio

Ogni container deve possedere i privilegi minimi per il suo lavoro e non di più.

Un container compromesso non deve essere in grado di compiere danni eccessivi.

La difesa consiste in:

- assicurarsi che i processi nei contenitori non siano attivi come root

- mappare i filesystems host come read-only se non vi è necessità di scrittura

- ridurre le capabilities che un contenitore possiede

- limitare le risorse host che un contenitore può usare

Limiti ai contenitori

Limitare il Networking

Aprire soltanto le porte che servono.

Di default più containers sulla stessa rete possono vedersi anche se le porte non sono state ufficialmente aperte od esposte.

Esempio. Scaricare l’immagine:

docker pull amouat/network-utils

Lanciare due containers:

docker run --name nc-test -d \

amouat/network-utils nc -l 5001

docker run \

-e IP=$(docker inspect -f \

{{.NetworkSettings.IPAddress}} nc-test) \

amouat/network-utils \

sh -c 'echo "hello" | nc -v $IP 5001'

Uscire dai container con Ctrl-P Ctrl-Q.

Ispezionare il risultato:

docker logs nc-test

Al termine, ripulire i container.

I contenitori si vedono tra loro anche se la porta di rete non è esplicitamente aperta.

Si può disabilitare la comunicazione tra i container lanciandoli con l'opzione --icc=false. Inoltre l'opzione --iptables=true forza l'uso delle regole di iptables sullo host.

Meglio ancora, lanciamo i contenitori su una rete docker interna. Questo limita la visibilità ai soli contenitori sulla stessa rete interna.

SUID e SGID

E' molto probabile che non vi sia bisogno nel nostro applicativo dei programmi con il bit SUID o SGID settato.

In tal caso può essere una buona idea disabilitarli.

Per esempio, in un Dockerfile:

FROM alpine

...

RUN find / -perm +6000 -type f -exec chmod a-s {} \; || true

...

Limitare la Memoria

Scaricare il programma di stress test:

docker pull amouat/stress

Limitare memoria, swap e memoria virtuale°

docker run -m 128m --memory-swap 128m amouat/stress \

stress --vm 1 --vm-bytes 127m -t 5s

Memoria virtuale eccessiva:

docker run -m 128m --memory-swap 128m amouat/stress \

stress --vm 1 --vm-bytes 130m -t 5s

Non ponendo limiti allo swap:

docker run -m 128m amouat/stress \

stress --vm 1 --vm-bytes 255m -t 5s

Non tutte le installazioni di Docker consentono limitazioni alla memoria virtuale. Dare il comando:

docker info

e cercare la presenza eventuale del messaggio

WARNING: No swap limit support

Il supporto richiederebbe una ricompilazione del kernel Linux.

Limitare la CPU

Con l'opzione -c.

Viene dato un peso relativo ad ogni contenitore per quanto riguarda l'impegno di CPU. Il peso è una potenza di 2. Il peso di default è 1024.

Esempio:

docker run -d --name load1 -c 2048 amouat/stress

docker run -d --name load2 amouat/stress

docker run -d --name load3 -c 512 amouat/stress

docker run -d --name load4 -c 512 amouat/stress

docker stats $(docker inspect -f {{.Name}} $(docker ps -q))

Interrompere docker stats con Ctrl-C. Ripulire i contenitori al termine dell'esercizio.

Limitare i Restart

Un container può avere problemi e compiere troppi restart. Limitarli con, per esempio:

docker run -d --restart=on-failure:10 my-flaky-image

Per vedere il conto di restart corrente:

docker inspect -f "{{ .RestartCount }}" $(docker ps -lq)

Limitare i Filesystem

Con l'opzione --read-only.

Esempio:

docker run --read-only debian touch x

touch: cannot touch 'x': Read-only file system

Si può inoltre limitare l'accesso ai volumi. Per esempio:

docker run -v $(pwd):/pwd:ro debian touch /pwd/x

touch: cannot touch '/pwd/x': Read-only file system

Docker Compose

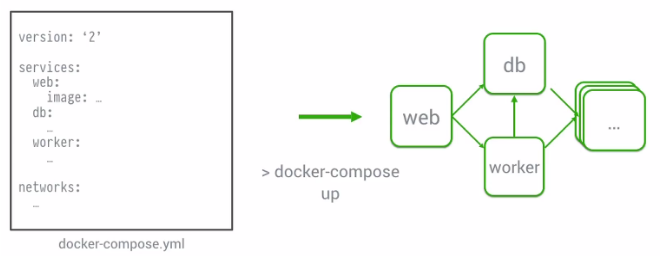

Docker Compose è uno strumento per definire ed eseguire applicatvi multi-container.

Semplifica il controllo dell'intero stack applicatvo, rendendo facile la gestione di servizi, reti e volumi con un singolo file di configurazione Yaml.

Orchestrazione locale

Docker Compose è uno strumento per definire ed eseguire applicativi composti da più contenitori.

Sono chiamati servizi.

Basato su:

- Un file di specifiche

- Un singolo comando esecutivo

Azioni:

- Start, stop e rebuild di servizi

- Vedere lo stato e i log dei servizi attivi

Utile per:

- Continuous Integration

- Creare e distruggere ambienti di testing integrati

Docker Compose è uno strumento di orchestrazione sulla singola macchina host.

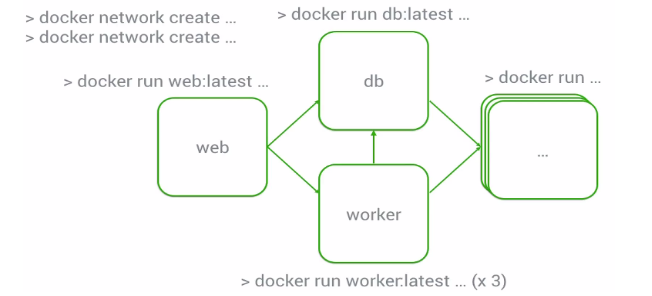

Un applicativo può essere complesso e avere più containers intercollegati:

- Sequenza di creazione?

- Interconnessioni?

- Dipendenze?

Specifiche di applicativo complesso.

- File di configurazione:

docker-compose.yml- Linguaggio yaml

- Lancio:

docker-compose up

Installazione di Docker Compose

Installazione

Sito: https://docs.docker.com/compose/install/

Da terminale:

sudo curl -L "https://github.com/docker/compose/releases/download/1.28.3/docker-compose-$(uname -s)-$(uname -m)" -o /usr/local/bin/docker-compose

sudo chmod +x /usr/local/bin/docker-compose

Test:

docker-compose version

Aiuto:

docker-compose --help

File di specifiche Yaml

Compose File

File di configurazione per la definizione dei servizi:

- Containers da caricare

- Volumi mappati

- Reti di collegamento

- Variabili d'ambiente

- Porte esposte

- ecc.

Nome di default: docker-compose.yml

Formato Yaml

- Yet Another Markup Language – YAML Ain't Markup Language

- Standard di serializzazione per qualsiasi linguaggio

- Estensione

.ymlo.yaml - Regole strette per l’indentazione (come in Python)

Prova

Test con un semplice HelloWorld:

mkdir hello

cd hello

vi docker-compose.yml

version: '2'

services:

hello:

image: tutum/hello-world

ports:

- 80

Attenzioni:

- Allineamenti e indentazioni

- Devono essere spazi non Tab

Lancio:

docker-compose up -d

-d: detached – in background

Viene scaricata l'immagine tutum/helloworld.

- Verificare con

docker images.

Viene lanciato un contenitore;

- Il contenitore è

detached - Verificare la sua porta esterna con docker ps

- Collegare un browser a questa porta

Ripulire.

Fermare e rimuovere il contenitore:

docker-compose down

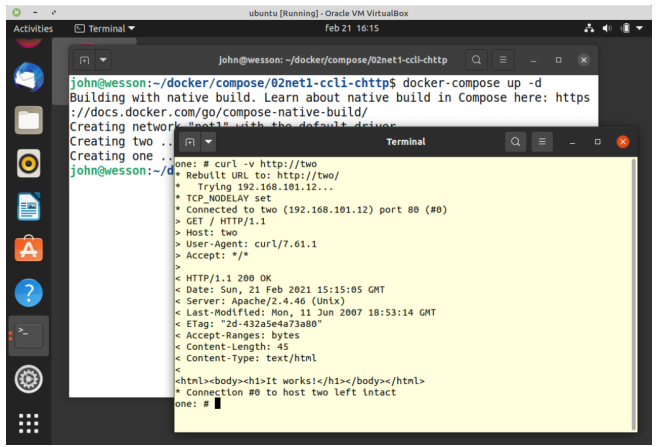

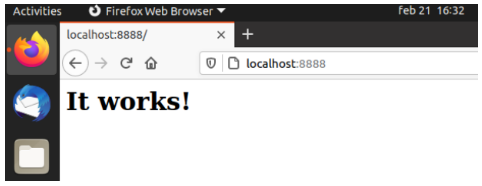

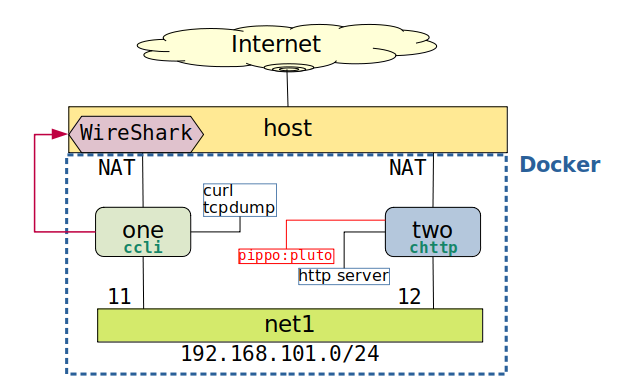

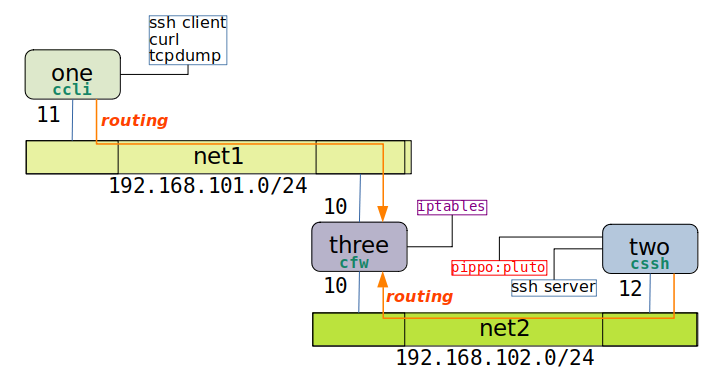

Esercizio 1: una rete

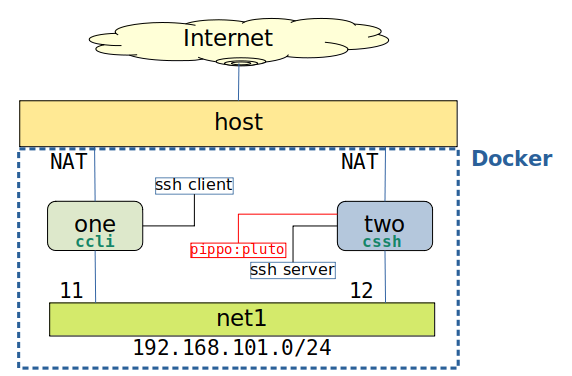

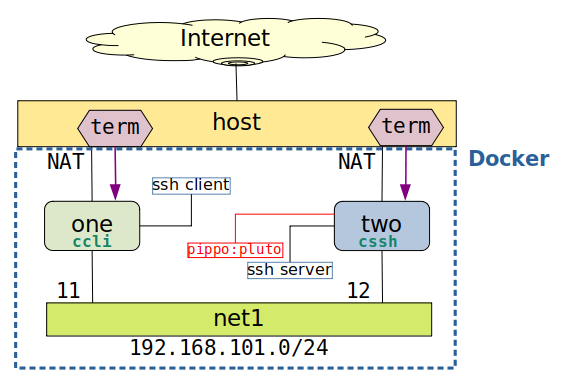

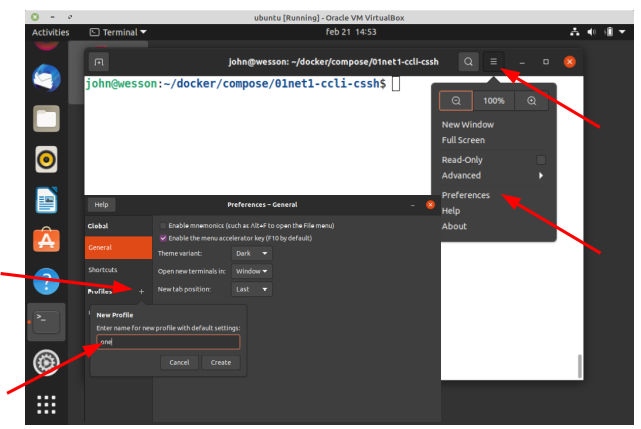

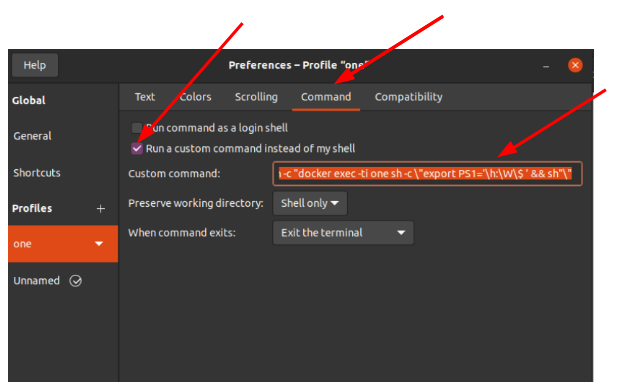

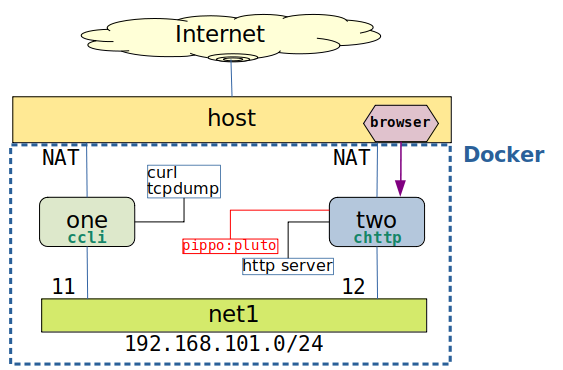

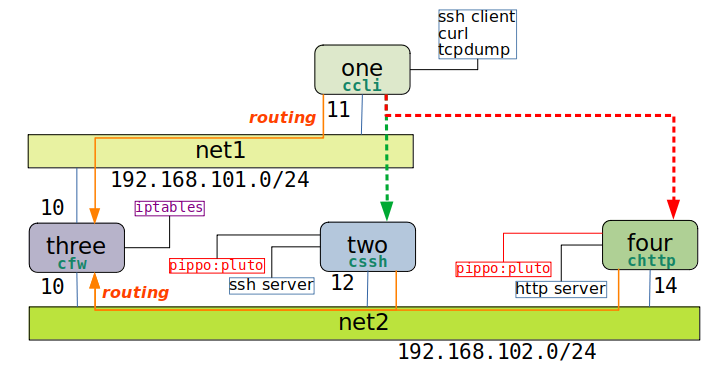

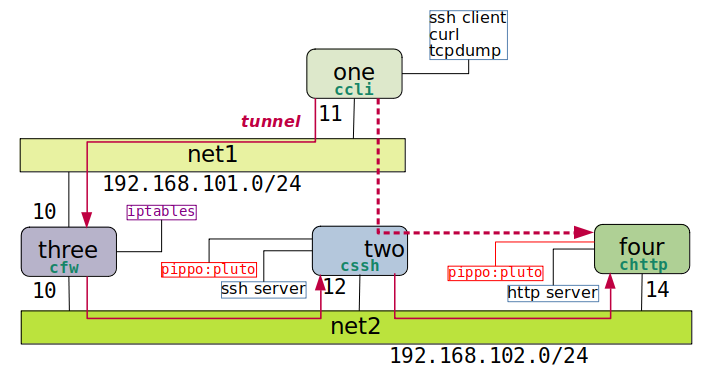

01net1-ccli-cssh

Descrizione concisa: Una rete, client e server SSH.

E' importante preparare un diagramma del progetto.

Non esiste uno specifico linguaggio di diagrammazione, ciascuno può scegliersi il suo. L'importante è rimanere consistemti in diagrammi di più progetti.

Il diagramma deve specificare tutti i componenti del progetto. Lo scopo è di passarlo ad un programmatore, che deve comprendere subito quello che deve preparare.

La rete si chiamerà net1 e il suo indirizzo CIDR sarà 192.160.100.0/24.

Sulla rete vi saranno due container: one e two, con indirizzi di host 11 e 12.

Il container one sarà generato dall'immagine ccli e sarà un client SSH, two dall'immagine cssh, un server SSH.

Il container two avrà un utente pippo, con password pluto.

Scaffolding

E' importante avere un nome distintivo del progetto, che suggerisca la struttura e le intenzioni di ciò che si vuole compiere.

Creare la directory di progetto:

mkdir 01net1-ccli-cssh

cd 01net1-ccli-cssh

L'albero dei files che comporranno il progetto è preparato prima, con i files vuoti. Questo è lo scaffolding (impalcatura) del progetto.

L'approccio è top-down.

Preparare lo scaffolding:

mkdir ccli cssh

touch ccli/Dockerfile cssh/Dockerfile

touch docker-compose.yml

Ogni immagine da generare ha una sottodirectory col nome dell'immagine, e contiene il suo Dockerfile, più ogni altro eventuale file necessario nal build.

A livello progetto vi è il file docker-compose.yml.

Il risultato è:

tree .

.

├── ccli

│ └── Dockerfile

├── cssh

│ └── Dockerfile

└── docker-compose.yml

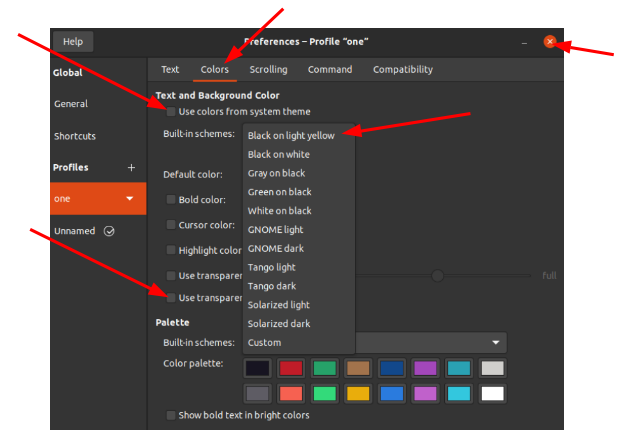

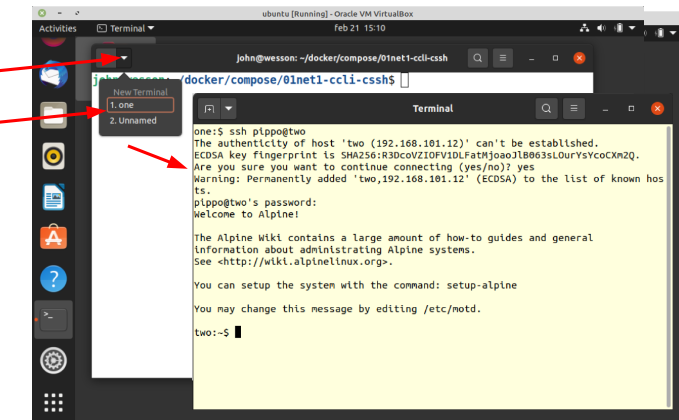

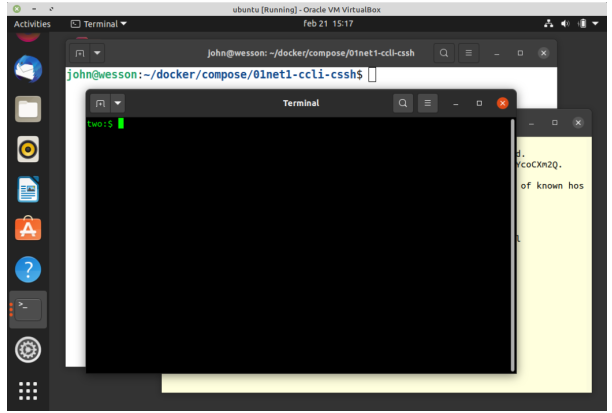

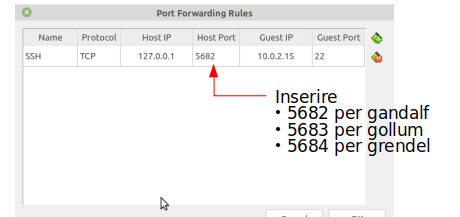

Files del Progetto