Introduzione

Kubernetes è più che oggetti di base e semplici configurazione.

Vi sono molti altri oggetti e ambienti utili nello sviluppo di applicativi più complessi, e utilities per la pacchettizzazione, distribuzione e gestione dei nostri applicativi.

Vengono qui esaminati:

- un numero di oggetti Kubernetes più complessi

- aspetti più avanzati di oggetti già noti

- l'utility di pacchettizzazione Helm

Si parte dal cluster Kind con configurazione standard già usato in precedenza.

Licenza

La presente documentazione è distribuita secondo i termini della GNU Free Documentation License Versione 1.3, 3 novembre 200t8.

Ne è garantita assoluta libertà di copia, ridistribuzione e modifica, sia a scopi commerciali che non.

L'autore detiene il credito per il lavoro originale ma nè credito nè responsabilità per le modifiche.

Qualsiasi lavoro derivato deve essere conforme a questa stessa licenza.

Il testo pieno della licenza è a:

https://www.gnu.org/licenses/fdl.txt

Tecnologia Kubernetes

Preparazione cluster KinD

Questi sono i passi per la preparazione di un cluster Kubernetes basato su Kind.

Partiamo da un sistema con il seguente software installato:

- Docker - meglio se ultima versione

- Docker Compose

- come script standalone in Python

- (meglio) come componente di Docker stesso

I comandi qui illustrati useranno l'utility standalone.

Per usare invece il Docker Compose integrato in Docker, sostituire docker compose al posto di docker-compose.

NOTA

I files di configurazione del cluster Kind standard sono raccolti nel file tar cluster-kind-std.tar Scompattare tale file nella directory di login. Procedere quindi alla sezione Lancio del Cluster Kubernetes.

kubectl

Scaricare e installare kubectl:

curl -LO https://storage.googleapis.com/kubernetes-release/release/$(curl -s \

https://storage.googleapis.com/kubernetes-release/release/stable.txt)/bin/linux/amd64/kubectl

chmod +x ./kubectl

sudo mv ./kubectl /usr/local/bin/kubectl

sudo chown root:root /usr/local/bin/kubectl

kind

Installiamo ora kind:

curl -Lo ./kind https://github.com/kubernetes-sigs/kind/releases/download/v0.14.0/kind-linux-amd64 && \

chmod +x ./kind && \

sudo mv ./kind /usr/local/bin/kind

Script di Attivazione del Cluster

Tutti gli esercizi utilizzeranno la versione del cluster costruito con Kind.

Editare il file di configurazione:

cd

vim std.sh

#!/bin/sh

set -o errexit

# crea il contenitore del registry se non esiste

reg_name='kind-registry'

reg_port='5000'

if [ "$(docker inspect -f '{{.State.Running}}' "${reg_name}" 2>/dev/null || true)" != 'true' ]; then

docker run \

-d --restart=always -p "127.0.0.1:${reg_port}:5000" --name "${reg_name}" \

-v $HOME/.docker/registry:/var/lib/registry registry:2

fi

# crea un cluster con il registry locale abilitato in containerd

cat <<EOF | kind create cluster --image kindest/node:v1.24.0 --config=-

kind: Cluster

apiVersion: kind.x-k8s.io/v1alpha4

containerdConfigPatches:

- |-

[plugins."io.containerd.grpc.v1.cri".registry.mirrors."localhost:${reg_port}"]

endpoint = ["http://${reg_name}:5000"]

nodes:

- role: control-plane

extraMounts:

- hostPath: /data

containerPath: /data

- role: worker

extraMounts:

- hostPath: /data

containerPath: /data

- role: worker

extraMounts:

- hostPath: /data

containerPath: /data

EOF

# connette il registry alla rete del cluster se non connesso

if [ "$(docker inspect -f='{{json .NetworkSettings.Networks.kind}}' "${reg_name}")" = 'null' ]; then

docker network connect "kind" "${reg_name}"

fi

# Documenta il local registry

cat <<EOF | kubectl apply -f -

apiVersion: v1

kind: ConfigMap

metadata:

name: local-registry-hosting

namespace: kube-public

data:

localRegistryHosting.v1: |

host: "localhost:${reg_port}"

help: "https://kind.sigs.k8s.io/docs/user/local-registry/"

EOF

Renderla eseguibile:

chmod +x ~/std.sh

Shell Scripts per la Gestione del Cluster

setup

sudo vim ~/setup.sh

#! /bin/sh

echo "Creating cluster ..."

echo

echo "~/std.sh"

~/std.sh

echo "Cluster info follows ..."

kubectl cluster-info --context kind-kind

echo

echo "---> Loading and configuring the Metallb load balancer ..."

echo

echo "-- Namespace"

echo "kubectl apply -f scripts/metallb-ns.yml"

kubectl apply -f scripts/metallb-ns.yml

echo

echo "-- Deployment and service"

echo "kubectl apply -f scripts/metallb-svc.yml"

kubectl apply -f scripts/metallb-svc.yml

echo

echo "-- Configmap"

echo "kubectl apply -f scripts/metallb-configmap.yml"

kubectl apply -f scripts/metallb-configmap.yml

echo

echo "Wait up to 120s for Metallb controller deployment to be ready ..."

kubectl wait deployment -n metallb-system controller --for condition=Available=True --timeout=120s

echo

echo " CLUSTER NOW READY"

echo " ===> All resources in namespace 'default'"

kubectl get all

echo

echo " ===> All resources in namespace 'metallb-system'"

kubectl get all -n metallb-system

Renderla eseguibile:

sudo chmod +x ~/setup.sh

teardown

sudo vim ~/teardown.sh

echo "About to delete cluster 'kind'"

echo "Press Control-C within 10 seconds to interrupt"

sleep 10

kind delete cluster

echo "Cluster deleted"

Renderla eseguibile:

sudo chmod +x ~/teardown.sh

Manifests di Gestione del Cluster

Metallb Load Balancer

Scarico dei manifest necessari dalla rete e trasferimento al contenitore kub:

mkdir -p ~/scripts

wget https://raw.githubusercontent.com/metallb/metallb/v0.12.1/manifests/namespace.yaml

sudo mv namespace.yaml ~/scripts/metallb-ns.yml

wget https://raw.githubusercontent.com/metallb/metallb/v0.12.1/manifests/metallb.yaml

sudo mv metallb.yaml ~/scripts/metallb-svc.yml

Configmap per Metallb

sudo vim ~/scripts/metallb-configmap.yml

apiVersion: v1

kind: ConfigMap

metadata:

namespace: metallb-system

name: config

data:

config: |

address-pools:

- name: default

protocol: layer2

addresses:

- 172.18.255.200-172.18.255.250

Lancio del Cluster Kubernetes

Scaricare l'immagine del cluster:

docker pull kindest/node:v1.24.0

Partenza del cluster:

~/setup.sh

Impiegherà un po' di tempo aggiuntivo, poichè scaricherà la sua immagine di default del cluster.

Il File Kubeconfig

Kubeconfig è un file Yaml con tutti i dettagli del cluster Kubernetes, i certificati, i token segreti.

Può essere autogenerato dall'utility di costruzione cluster o ricevuto dal cloud provider.

La sua locazione tipica ès $HOME/.kube/config.

Si può usare un altro file, ma occorre indicarlo con la variabile d'ambiente KUBECONFIG.

Per esempio:

export KUBECONFIG=$HOME/.kube/dev_cluster_config

oppure:

kubectl get nodes --kubeconfig=$HOME/.kube/dev_cluster_config

KUBECONFIG=$HOME/.kube/dev_cluster_config kubectl get nodes

Per esaminare il nostro, generato da Kind:

less ~/.kube/config

Una struttura più generica può essere:

apiVersion: v1

clusters:

- cluster:

certificate-authority-data: <ca-data-here>

server: https://your-k8s-cluster.com

name: <cluster-name>

contexts:

- context:

cluster: <cluster-name>

user: <cluster-name-user>

name: <cluster-name>

current-context: <cluster-name>

kind: Config

preferences: {}

users:

- name: <cluster-name-user>

user:

token: <secret-token-here>

Qualora vi fossero più files di configurazione di cluster, si può compiere il merge coi comandi, per esempio:

KUBECONFIG=config:dev_config:test_config kubectl config view --merge --flatten > config.new

mv $HOME/.kube/config $HOME/.kube/config.old

mv $HOME/.kube/config.new $HOME/.kube/config

Vi sono tre configurazioni principali:

- clusters - con il nome, la URL del server e il certificato

- contexts - con il nome, il cluster a cui si riferisce e l'utente con cui accede

- users - con il nome e le credenziali d'accesso, spesso un Client Certificate

Sono degli arrays, e possono avere più elementi.

Contesto di kubectl

kubectl invia le sue richieste al Server API di un determinato cluster, il contesto.

Listare i contesti disponibili:

kubectl config get-contexts

Cambiare contesto:

kubectl config use-context <context-name>

Si può anche cancellare un contesto, ma non è consigliabile, meglio usare l'utility specifica per la gestione del cluster, p.es. kind.

kubectl config delete-context <context-name>

Aspetti Avanzati I

Un particolare cluster Kubernetes ha un numero di oggetti, o risorse, disponibili.

Per listarli usare il comando:

kubectl api-resources

Daemonset

Un DaemonSet si assicura che ogni nodo del cluster abbia un pod dell'immagine specificata.

Si può restringere il numero di nodi coinvolti con le direttive nodeSelector, nodeAffinity, Taints, e Tolerations.

Usi di DaemonSet:

- Raccolta di Log - p.es. fluentd , logstash, fluentbit

- Monitoraggio di Cluster - p.es. Prometheus

- Benchmark - p.es. kube-bench

- Sicurezza - sistemi di detezione intrusioni o scansori di vulnerabilità

- Storaggio - p.es. un plugin di storaggio su ogni nodo

- Gestione di Rete - p.es. il plugin Calico per CNI

Esempio di DaemonSet

vim ~/scripts/fluentd.yml

apiVersion: apps/v1

kind: DaemonSet

metadata:

name: fluentd

namespace: logging

labels:

app: fluentd-logging

spec:

selector:

matchLabels:

name: fluentd

template:

metadata:

labels:

name: fluentd

spec:

containers:

- name: fluentd-elasticsearch

image: quay.io/fluentd_elasticsearch/fluentd:v2.5.2

resources:

limits:

memory: 200Mi

requests:

cpu: 100m

memory: 200Mi

volumeMounts:

- name: varlog

mountPath: /var/log

terminationGracePeriodSeconds: 30

volumes:

- name: varlog

hostPath:

path: /data/varlog

E' opportuno che ogni DaemonSet sia specificato entro il suo namespace esclusivo.

Creare il namespace ed applicare il manifest:

kubectl create ns logging

kubectl apply -f scripts/fluentd.yml

Verifica con:

kubectl get daemonset -n logging

kubectl get pods -n logging -o wide

kubectl describe daemonset -n logging

Editazione Istantanea

Cambiamento istantaneo dei parametri di configurazione con:

kubectl edit daemonset fluentd -n logging

L'editor invocato è quello di sistema o quello indicato dalla variabile d'ambiente EDITOR.

Si può editare soltanto la sezione spec, non ststus.

In caso di errore l'editazione viene rilanciata.

Dopo il salvataggio di un'editazione corretta, avviene un rolling update.

Taints

Un Taint si applica ai nodi.

Il Taint ha la sintassi:

kubectl taint nodes <nodo> <chiave>=<valore>:<effetto>

L'effetto si applica sul nodo indicato a tutti i pod degli oggetti che hanno la chiave e il valore indicato.

L'effetto può essere:

- NoSchedule

- PreferNoSchedule

- NoExecute

Esempio:

kubectl taint node kind-worker2 app=fluentd-logging:NoExecute

Lista di tutti i taints associati ai nodi:

kubectl get node -o custom-columns=NAME:.metadata.name,TAINT:.spec.taints[*]

Rimuovere un taint:

kubectl taint node kind-worker2 app-

Notare alla fine del comando il nome dell'etichetta seguito dal segno meno.

Tolerations

Modificare il file di specifiche del DaemonSet:

vim ~/scripts/fluentd.yml

...

tolerations:

- key: app

value: fluentd-logging

operator: Equal

effect: NoExecute

containers:

...

E riapplicare:

kubectl apply -f ~/scripts/fluentd.yml

Questo genera una eccezione al Taint.

Rimuovere il DaemonSet dell'esercizio:

kubectl delete -f ~/scripts/fluentd.yml

nodeSelector

Si può usare nodeSelector per avere i pod solo su alcuni nodi specifici. Il controller DaemonSet creai i pod sui nodi che hanno la chiave e il valore del selector.

Per esempio:

kubectl label node kind-worker2 type=platform-tools

E modificare le specifiche inserendo:

...

spec:

nodeSelector:

type: platform-tools

containers:

...

Ricreare il Daemonset e verificare:

kubectl apply -f ~/scripts/fluentd.yml

kubectl get pods -n logging -o wide

Per visualizzare i labels di un nodo:

kubectl get node kind-worker2 -o custom-columns=LABELS:.metadata.labels

Per rimuovere un label di nome type:

kubectl label node kind-worker2 type-

Rimuovere il DaemonSet dell'esercizio:

kubectl delete -f ~/scripts/fluentd.yml

nodeAffinity

Il controller DaemonSet crea i pod sui nodi che hanno il corrispondente nodeAffinity.

Vi sono due tipi di nodeAffinity:

requiredDuringSchedulingIgnoredDuringExecution- il pod non è schedulato se non si applica la regolapreferredDuringSchedulingIgnoredDuringExecution- lo scheduler prova a trovare un nodo conforme con la regola. Se non vi sono nodi che corrispondono, il pod viene schedulato ugualmente

Nel seguente DaemonSet vengono usate entrambe le regole di affinity:

- required che i nodi abbiano una certa etichetta

- preferred i nodi che abbiano l'etichetta di tipo

t2.large

Modificare il file di specifiche con il seguente.

vim ~/scripts/fluentd.yml

apiVersion: apps/v1

kind: DaemonSet

metadata:

name: fluentd

namespace: logging

labels:

app: fluentd-logging

spec:

selector:

matchLabels:

name: fluentd

template:

metadata:

labels:

name: fluentd

spec:

affinity:

nodeAffinity:

requiredDuringSchedulingIgnoredDuringExecution:

nodeSelectorTerms:

- matchExpressions:

- key: type

operator: In

values:

- platform-tools

preferredDuringSchedulingIgnoredDuringExecution:

- weight: 1

preference:

matchExpressions:

- key: instance-type

operator: In

values:

- t2.large

containers:

- name: fluentd-elasticsearch

image: quay.io/fluentd_elasticsearch/fluentd:v2.5.2

resources:

limits:

memory: 200Mi

requests:

cpu: 100m

memory: 200Mi

volumeMounts:

- name: varlog

mountPath: /var/log

terminationGracePeriodSeconds: 30

volumes:

- name: varlog

hostPath:

path: /data/varlog

Ricreare il Daemonset e verificare:

kubectl apply -f ~/scripts/fluentd.yml

kubectl get pods -n logging -o wide

E' meglio usare preferredDuringSchedulingIgnoredDuringExecution invece di requiredDuringSchedulingIgnoredDuringExecution poichè è impossibile lanciare nuovi pod se il numero di nodi richiesto è maggiore del numero di nodi disponibile.

Priorità dei Pod

Determina l'importanza relativa di un pod.

E' utile settare una più alta PriorityClass ad un DaemonSet se questo ha componenti critici, per evitare che i suoi pod vengano sfavoriti da altri pod in caso di competizione di risorse.

PriorityClass definisce la priorità del pod. Valore limite 1 milione. Numeri più alti con priorità più alta.

Creazione di un oggetto priority class:

vim ~/scripts/prioclass.yml

apiVersion: scheduling.k8s.io/v1

kind: PriorityClass

metadata:

name: high-priority

value: 100000

globalDefault: false

description: "daemonset priority class"

kubectl apply -f ~/scripts/prioclass.yml

kubectl get priorityClass

Aggiungere al nostro DaemonSet modificando il file di specifiche:

...

spec:

priorityClassName: high-priority

containers:

...

terminationGracePeriodSeconds: 30

volumes:

...

Ricreare il Daemonset e verificare:

kubectl apply -f ~/scripts/fluentd.yml

kubectl get pods -n logging -o wide

StatefulSet

Applicativi stateful gestiscono dati e hanno bisogno di tracciarli continuamente, per esempio MySQL, Oracle e PostgreSQL.

Uno StatefulSet è il controller appropriato per un applicativo stateful.

Ad ogni pod gestito viene assegnato un numero identificativo ordinale anzichè casuale e i pod vengono creati in ordine e cancellati in ordine inverso. Un nuovo pod è creato clonando il pod precedente solo quando è nello stato Running.

Le richieste di lettura da un volume associato vengono inviate a tutti i pod dello StatefulSet. Le richieste di scrittura sul volume associato vengono inviate solo al primo pod, e i dati modificati sono sincronizzati agli altri pod.

Cancellare un pod di uno StatefulSet non rimuove i volumi associati con l'applicativo.

Per l'esercizio che segue occorrono due Persistent Volumes, che i pod dello Stateful Set useranno. Normalmente un Provisioner creerebbe volumi dinamici all'occorrenza.

Il manifest che segue combina la definizione dei due persistent volumes con quella dello StatefulSet:

vim ~/scripts/stateful.yml

apiVersion: v1

kind: PersistentVolume

metadata:

name: www-volume-1

spec:

storageClassName: standard

capacity:

storage: 20Gi

accessModes:

- ReadWriteOnce

hostPath:

path: /data/www/

---

apiVersion: v1

kind: PersistentVolume

metadata:

name: www-volume-2

spec:

storageClassName: standard

capacity:

storage: 20Gi

accessModes:

- ReadWriteOnce

hostPath:

path: /data/www/

---

apiVersion: v1

kind: Service

metadata:

name: nginx

labels:

app: nginx

spec:

ports:

- port: 80

name: web

clusterIP: None

selector:

app: nginx

---

apiVersion: apps/v1

kind: StatefulSet

metadata:

name: web

spec:

serviceName: "nginx"

replicas: 2

selector:

matchLabels:

app: nginx

template:

metadata:

labels:

app: nginx

spec:

containers:

- name: nginx

image: registry.k8s.io/nginx-slim:0.8

ports:

- containerPort: 80

name: web

volumeMounts:

- name: www

mountPath: /usr/share/nginx/html

volumeClaimTemplates:

- metadata:

name: www

spec:

accessModes: [ "ReadWriteOnce" ]

resources:

requests:

storage: 1Gi

Aprire due finestre di terminale.

Nella prima digitare:

kubectl get pods --watch -l app=nginx

Nella seconda digitare:

kubectl apply -f ~/scripts/stateful.yml

Mentre nella seconda viene generato l'applicativo, il rapporto nella prima finestra è:

NAME READY STATUS RESTARTS AGE

web-0 0/1 Pending 0 0s

web-0 0/1 Pending 0 1s

web-0 0/1 ContainerCreating 0 1s

web-0 1/1 Running 0 5s

web-1 0/1 Pending 0 0s

web-1 0/1 Pending 0 2s

web-1 0/1 ContainerCreating 0 3s

web-1 1/1 Running 0 9s

I pod sono generati in sequenza.

Il pod web-1 viene generato solo quando il pod web-0 è nello stato di Running.

Il servizio è dato da:

kubectl get service nginx

Lo StatefulSet è dato da:

kubectl get statefulset web

I pod dell'applicativo si possono vedere con:

kubectl get pods -l app=nginx

Ogni pod ha uno hostname basato sul suo numero ordinale. Si possono vedere con:

for i in 0 1; do kubectl exec "web-$i" -- sh -c 'hostname'; done

Il loro nome è risolto al DNS di cluster. Si può compire un'interrogazione lanciando un pod aggiuntivo nel cluster:

kubectl run -i --tty --image busybox:1.28 dns-test --restart=Never --rm

E al pronto risultante dare:

nslookup web-0.nginx

Proviamo a cancellare esplicitamente i pod dello StatefulSet.

In una finestra digitare:

kubectl get pod --watch -l app=nginx

E nell'altra finestra digitare:

kubectl delete pod -l app=nginx

I pod vengono cancellati, ma subito ricreati, in ordine.

Scalare uno StatefulSet

In una finestra dare:

kubectl get pods --watch -l app=nginx

E nell'altra finestra:

kubectl scale sts web --replicas=5

Si nota che la creazione di nuovi pod procede per gradi, il nuovo pod sequenziale non viene creato finchè il precedente non è nello ststo di Running.

Si può anche scalare a decrescere, applicando una patch:

kubectl patch sts web -p '{"spec":{"replicas":3}}'

E' da notare che i Persistent Volume Claims sono ancora 5:

kubectl get pvc -l app=nginx

I PVC creati da uno StatefulSet non vengono cancellati anche quando sono cancellati i pod che li usano.

E' da notare che durante l'operazione di scale sono stati costruiti tre ulteriori Persistent Volumes, ma con una policy di Delete, anzichè Retain.

Cancellazione di uno StatefulSet

Tramite il manifest:

kubectl delete -f ~/scripts/stateful.yml

I PVC e i loro PV non vengono cancellati. I PV creati da manifest entrano in stato Terminating ma non sono rimossi finchè i corrispondenti PVC non vengono cancellati.

Cancellare a mano i PVC:

kubectl delete pvc www-web-0 www-web-1 www-web-2 www-web-3 www-web-4

I rimanenti PV sono temporaneamente visibili, ma vengono presto cancellati.

Gestione di Deployment e Rollout

Un Deployment, specificato da un manifest in Yaml, gestisce Pods e ReplicaSets in modo flessibile, ottenendo lo stato desiderato a partire dallo stato corrente.

NOTA: Non gestire manualmente i ReplicaSet che appartengono ad un Deployment.

Generazione di Deployment

Esempio. Un Deployment di nginx che gestisce un RepkicaSet con 3 pod.

vim ~/scripts/nginx-depl.yml

apiVersion: apps/v1

kind: Deployment

metadata:

name: nginx-deployment

labels:

app: nginx

spec:

replicas: 3

selector:

matchLabels:

app: nginx

template:

metadata:

labels:

app: nginx

spec:

containers:

- name: nginx

image: nginx:1.14.2

ports:

- containerPort: 80

Creare il deployment:

kubectl apply -f ~/scripts/nginx-depl.yml

Visualizzare il deploymant:

kubectl get deployments

Ogni deploymant è un rollout. Visualizzarne lo status:

kubectl rollout status deployment/nginx-deployment

Visualizzare il replicaset:

kubectl get rs

Visualizzare i pod e le loro etichette:

kubectl get pods --show-labels

Ogni pod acquisisce automaticamente l'etichetta pod-template-hash, che lo collega al ReplicaSet.

Update di Deployment

Cambiare la versione di nginx usata:

kubectl set image deployment/nginx-deployment nginx=nginx:1.16.1

Si può naturalmente modificare il file di specifiche ~/scripts/nginx-depl.yml e risottometterlo.

Si può inoltre editare direttamente con:

kubectl edit deployment/nginx-deployment

Verificare lo stato del rollout:

kubectl rollout status deployment/nginx-deployment

Solo un certo numero di pod sono disattivati durante il rollout. Default 25% - parametro maxUnavailable.

Solo un certo numero di pod nuovi sono creati durante il rollout.

Default 25% - parametro maxSurge.

I dettagli sul deployment si ottengono con:

kubectl describe deployments

Ogni rollout che cambia i pod crea una revisione. La revisione non viene creata quando si cambia il numero di pod con un'operazione di scale.

Rollback di un Deployment

Utile quando la nuova versione è in un loop di crash.

Per esempio un update con un errore tipografico:

kubectl set image deployment/nginx-deployment nginx=nginx:1.161

Il sintomo di fallimento è l'output del comando:

kubectl rollout status deployment/nginx-deployment

che rimane piantato a lungo.

Altri sintomi si deducono dai comandi:

kubectl get rs

kubectl get pods

kubectl describe deployment

La storia delle revisioni si ottiene con:

kubectl rollout history deployment/nginx-deployment

Per avere dettagli di una specifica revisione:

kubectl rollout history deployment/nginx-deployment --revision=2

Per compiere il rollback alla revisione precedente:

kubectl rollout undo deployment/nginx-deployment

Per compiere il rollback ad una revisione specifica:

kubectl rollout undo deployment/nginx-deployment --to-revision=2

Controllare il risultato con:

kubectl get deployment nginx-deployment

e con:

kubectl describe deployment nginx-deployment

Scalare un Deployment

Oltre che modificare il manifest, ~/scripts/nginx-depl.yml, e risottometterlo, si può modificare il Deployment col comando diretto:

kubectl scale deployment/nginx-deployment --replicas=10

Se è presente uno autoscaler, si può anche dare il comando:

kubectl autoscale deployment/nginx-deployment --min=10 --max=15 --cpu-percent=80

Questo introduce in Kubernetes un oggetto HPA - Horizontal Pod Autoscaler. Questo avviene anche se lo autoscaler non è abilitato.

Si possono vedere gli oggetti HPA con:

kubectl get hpa

kubectl get hpa -w

L'oggetto si cancella con:

kubectl delete hpa nginx-deployment

Il cluster Kind non fornisce un autoscaler. Minikube si.

Terminare l'Esercizio

kubectl delete -f ~/scripts/nginx-depl.yml

Kubernetes Jobs

Un Job è un oggetto che crea uno o più pod, i quali eseguono una sola volta poi terminano.

Semplice Job

Esempio: un job che calcola il valore di Pi Greco a 2000 cifre decimali.

Scriviamo il Manifest:

vim ~/scripts/jobpi.yml

apiVersion: batch/v1

kind: Job

metadata:

name: pi

spec:

template:

spec:

containers:

- name: pi

image: perl:5.34.0

command: ["perl", "-Mbignum=bpi", "-wle", "print bpi(2000)"]

restartPolicy: Never

backoffLimit: 4

Li parametro backoffLimit è il numero massimo di riprove prima di dichiarare fallimento definitivo, con valore di default 6.

Sottoponiamo il manifest a Kubernetes:

kubectl apply -f ~/scripts/jobpi.yml

Controlliamo l'esistenza:

kubectl get job

e del pod sottostante:

kubectl get pod

I Job si possono descrivere:

kubectl describe job pi

Quando un Job termina lo si vede dalla colonna COMPLETIONS. Quando il suo pod termina va nello stato Completed.

Per listare tutti i pod non Completed (ancora attivi) che appartengono ad un Job si può usare l'espressione:

pods=$(kubectl get pods --selector=batch.kubernetes.io/job-name=pi --output=jsonpath='{.items[*].metadata.name}')

echo $pods

Per vedere l'output dei pod di un Job si può usare:

kubectl logs jobs/pi

3.141592653589793238462643383279502884197169.....

Rimuoviamo il Job tramite Manifest:

kubectl delete -f ~/scripts/jobpi.yml

La rimozione di un job rimuove i suoi pod.

CronJob

Un CronJob compie attività a intervalli regolari schedulati nel futuro.

E' l'equivalente dell'ambiente cron nel mondo Unix/Linux.

Esempio. Un cronJob che scrive l'ora corrente e un messaggio ogni minuto.

vim ~/scripts/cronjob.yml

apiVersion: batch/v1

kind: CronJob

metadata:

name: hello

spec:

schedule: "* * * * *"

jobTemplate:

spec:

template:

spec:

containers:

- name: hello

image: busybox:1.28

imagePullPolicy: IfNotPresent

command:

- /bin/sh

- -c

- date; echo Hello from the Kubernetes cluster

restartPolicy: OnFailure

A intervalli di un minuto viene creato un nuovo pod che esegue il comando specificato.

La schedulazione è data dal campo .spec.schedule, che ha lo stesso formato del cron di Unix.

# ┌───────────── minute (0 - 59)

# │ ┌───────────── hour (0 - 23)

# │ │ ┌───────────── day of the month (1 - 31)

# │ │ │ ┌───────────── month (1 - 12)

# │ │ │ │ ┌───────────── day of the week (0 - 6) (Sunday to Saturday)

# │ │ │ │ │ OR sun, mon, tue, wed, thu, fri, sat

# │ │ │ │ │

# │ │ │ │ │

# * * * * *

Sono disponibili delle macro:

| Macro | Equivalente a |

|---|---|

| @yearly | 0 0 1 1 * |

| @monthly | 0 0 1 * * |

| @weekly | 0 0 * * 0 |

| @daily | 0 0 * * * |

| @hourly | 0 * * * * |

Il campo .spec.jobTemplate ha lo stesso schema di un Job. Si possono anche usare in esso metadati come labels e annotations.

Sottomettiamo il Manifest:

kubectl apply -f ~/scripts/cronjob.yml

Controlliamo l'esistenza del CronJob:

kubectl get cronjob

NAME SCHEDULE SUSPEND ACTIVE LAST SCHEDULE AGE

hello * * * * * False 0 14s 30s

Dopo qualche minuto controlliamo i Job e i Pod:

kubectl get cronjobs

kubectl get jobs

kubectl get pods

Notare che il nome è costruito a partire dal nome del CronJob.

I nostri pod del Cronjob scrivono ciascuno al suo standard output, quindi nei logs. L'output di un pod è visibile con, p.es.:

kubectl logs hello-28474168-pdh77

Tue Feb 20 17:38:04 UTC 2024

Hello from the Kubernetes cluster

Calibrazione dei Job

Storia dei Job

Anche dopo molti minuti il rapporto mantiene una storia di poche entries. La storia mantenuta è controllata dai parametri:

.spec.successfulJobsHistoryLimit- lunghezza della storia dei jobs/pods che hanno avuto successo (default 3).spec.failedJobsHistoryLimit- lunghezza della storia dei jobs/pods che sono falliti (default 1)

Partenza Ritardata dei Job

Il campo opzionale .spec.startingDeadlineSeconds definisce una tolleranza in secondi per la partenza di un job (default: infinito), se per qualsiasi ragione il job non riesce a partire al momento schedulato.

Non settare mai il parametro inferiore a 10 secondi, o il job può non venire mai eseguito.

Se passa il tempo di tolleranza il job è considerato fallito.

Concorrenza

E' quando il job precedente è ancora in esecuzione e viene schedulato un nuovo job uguale.

Questo è controllato dal parametro .spec.concurrencyPolicy che può avere i seguenti valori:

Allow- (default) concessoForbid- proibito. Il nuovo job schedulato fallisce.Replace- il nuovo job schedulato parte. Il vecchio job non ancora completato, fallisce.

Sospensione

Si può sospendere l'esecuzione di un Job o CronJob settando il parametro .spec.suspend al valore true (default: false).

I job già partiti non sono toccati.

Si possono cambiare i cronjob già attivi, oltre che modificare e sottomettere il Manifest. Per esempio:

kubectl patch cronjob hello -p '{"spec":{"suspend":true}}'

La stringa di patch può essere in Json o Yaml.

ATTENZIONE: Quando un CronJob è sospeso e passano i momenti di schedulazione dei suoi Job, questi vengono accodati. Quando si toglie la sospensione i Job accodati vengono eseguiti simultaneamente. Il comportamento dipende dai settaggi .spec.startingDeadlineSeconds e .spec.concurrencyPolicy.

Terminare l'Esercizio

kubectl delete -f ~/scripts/cronjob.yml

Labels ed Annotazioni

Le Label sono usate principalmente per identificare e raggruppare risorse da Kubernetes ed hanno un significato semantico.

Le Annotation sono per Kubernetes degli oggetti opachi e non hanno impatto sulle operazioni interne. Sono metadati non identificativi aggiunte arbitrariamente ad un oggetto.

Sono dei clients come strumenti e librerie che eventualmente raccolgono questi dati.

Sia le annotazioni che le etichette sono mappe chiave-valore.

Un'annotazione ha la struttura:

[prefisso/]mome: "valore"

Il nome:

- è un requisito

- é lungo al massimo 63 caratteri, inizia e termina con un carattere alfanumerico, può avere trattini, punti e underscores

Il prefisso:

- è opzionale

- è lungo al massimo 253 caratteri

- è un dominio DNS

Il valore

- è un requisito

- è una stringa formattata JSON

Esempio:

apiVersion: v1

kind: Pod

metadata:

name: annotations-demo

annotations:

imageregistry: "http://localhost:5000/"

spec:

containers:

- name: nginx

image: nginx:1.14.2

ports:

- containerPort: 80

Specifica da quale registry provengono le immagini. E'da notare però che l'immagine è comunque scaricata dal Docker Hub e non dal registry locale.

Le annotations sono lette da tools esterni, non dal Kubernetes corrente.

Le annotazioni sono in genere poste manualmente nel Manifest dell'oggetto creato. Però in certi casi possono essere create ed usate da tools esterni di controllo o gestione.

Per esempio lo Horizontal Pod Autoscaler (HPA) genera annotazioni.

Oltre che porre annotazioni nel Manifest di un oggetto si può annotare un oggetto già esistente col comando kubectl annotate.

Esempi:

- Update del pod 'foo' con la annotation 'description' e il valore 'my frontend'

kubectl annotate pods foo description='my frontend'

- Update di un pod identificato nel file "pod.json"

kubectl annotate -f pod.json description='my frontend'

- Riscrivere un'annotazione esistente

kubectl annotate --overwrite pods foo description='my frontend running nginx'

- Update di un'annotazione in tutti i pod del namespace (-A: in tutti i namespace)

kubectl annotate pods --all description='my frontend running nginx'

- Update del pod 'foo' solo se la risorsa non è cambiata dalla versione 1

kubectl annotate pods foo description='my frontend running nginx' --resource-version=1

- Rimuovere un'annotazione

kubectl annotate pods foo description-

Esempio. Sia dato il Manifest:

vi ~/scripts/annotations.yml

apiVersion: v1

kind: Pod

metadata:

name: nginx-pod

labels:

app: dashboard

environment: test

annotations:

build-info: |

{

"commit": "abcd123",

"timestamp": "2023-05-01T10:00:00Z"

}

spec:

containers:

- name: frontend-nginx

image: nginx

Una volta creato l'oggetto si possono compiere delle query basate sia sulle label che sulle annotation.

kubectl get pods nginx-pod -o yaml | grep -A2 'labels:'

labels:

app: dashboard

environment: test

kubectl get pods nginx-pod -o yaml | grep -A5 'annotations:'

annotations:

build-info: |

{

"commit": "abcd123",

"timestamp": "2023-05-01T10:00:00Z"

}

kubectl get pods --selector='app=dashboard'

NAME READY STATUS RESTARTS AGE

nginx-pod 1/1 Running 0 5m33s

kubectl get pods --selector='app in (dashboard), environment in (test)'

NAME READY STATUS RESTARTS AGE

nginx-pod 1/1 Running 0 7m36s

E in generale si può usare la meravigliosa utility jq per compiere queries su stringhe JSON:

kubectl get pods -o json | \

jq -r '.items[] | select(.metadata.annotations."build-info" | fromjson | .commit=="abcd123") | .metadata.name'

nginx-pod

Terminare l'Esercizio

kubectl delete -f ~/scripts/annotations.yml

Controllo di Sanità e Probes

Kubernetes fornisce due tipi di sonde (probes) per testare l'usabilità di un applicativo: Liveness Probes e Readiness Probes.

Un Liveness Probe testa se l'applicativo è vivo e raggiungibile. Se non lo è, il pod che lo implementa viene terminato e ristartato.

Un Readiness Probe testa se l'applicativo può ricevere traffico del tipo programmato, Se non può, non viene inviato traffico al pod che lo implementa.

Vi sono tre tipi di probe; HTTP, Comando e TCP.

- HTTP - Kubernetes accede ad un path HTTP del pod, e se il responso ha i codici tra il 200 e il 300 lo considera attivo. Un pod può implementare un miniserver HTTP a questo solo scopo.

- Command - viene eseguito un comando nel pod, e se ritorna un codice di ritorno 0 viene considerato attivo.

- TCP - viene aperta una connessione al pod, e se ha successo il pod è considerato attivo.

Command Liveness

Esempio di Liveness Probe:

vim ~/scripts/liveness.yml

apiVersion: v1

kind: Pod

metadata:

labels:

test: liveness

name: liveness-exec

spec:

containers:

- name: liveness

image: registry.k8s.io/busybox

args:

- /bin/sh

- -c

- touch /tmp/healthy; sleep 40; rm -f /tmp/healthy; sleep 600

livenessProbe:

exec:

command:

- cat

- /tmp/healthy

initialDelaySeconds: 5

periodSeconds: 5

I parametri sono:

initialDelaySeconds- quanto tempo attendere prima di inviare il primo probeperiodSeconds- ogni quanto tempo inviare i probe

Sottomettere il manifest:

kubectl apply -f ~/scripts/liveness.yml

Ispezionare gli eventi del pod:

kubectl describe pod liveness-exec

Kubernetes inizia subito ad inviare liveness probes, anche quando il pod non è in stato di Running. Quindi possono esservi degli eventi di fallimento iniziali. Possono essere gestiti aumentando il parametro initialDelaySeconds.

Dopo un certo periodo di tempo il pod è stabile e il rapporto da:

kubectl get pod

NAME READY STATUS RESTARTS AGE

liveness-exec 1/1 Running 7 (78s ago) 20m

In caso di fallimento si vede un esempio di questo tipo:

Warning Unhealthy 7m17s (x19 over 16m) kubelet Liveness probe failed: cat: can't open '/tmp/healthy': No such file or directory

Warning BackOff 2m27s (x22 over 9m17s) kubelet Back-off restarting failed container liveness in pod liveness-exec_default(0726f57d-8dd9-489d-b0c5-ff352bfdc084)

E il pod è:

kubectl get pod

NAME READY STATUS RESTARTS AGE

liveness-exec 0/1 CrashLoopBackOff 7 (5m11s ago) 17m

Terminare il pod:

kubectl delete -f ~/scripts/liveness.yml

HTTP Liveness

Esempio:

vim ~/scripts/http-liveness.yml

apiVersion: v1

kind: Pod

metadata:

labels:

test: liveness

name: liveness-http

spec:

containers:

- name: liveness

image: registry.k8s.io/liveness

args:

- /server

livenessProbe:

httpGet:

path: /healthz

port: 8080

httpHeaders:

- name: Custom-Header

value: Awesome

initialDelaySeconds: 3

periodSeconds: 3

L'immagine registry.k8s.io/liveness è appositamente didattica.

E' stata scritta in linguaggio Go e contiene il route handler:

http.HandleFunc("/healthz", func(w http.ResponseWriter, r *http.Request) {

duration := time.Now().Sub(started)

if duration.Seconds() > 10 {

w.WriteHeader(500)

w.Write([]byte(fmt.Sprintf("error: %v", duration.Seconds())))

} else {

w.WriteHeader(200)

w.Write([]byte("ok"))

}

})

Il responso è appositamente accurato per i primi 10 secondi, ma poi fallisce. Con un Liveness Probe il pod viene ristartato.

Sottomettiamo il manifest:

kubectl apply -f ~/scripts/http-liveness.yml

E ben presto abbiamo una situazione di questo tipo:

kubectl get pod

NAME READY STATUS RESTARTS AGE

liveness-http 1/1 Running 2 (13s ago) 75s

Con l'evento dedotto da:

kubectl describe pod liveness-http

.....

Warning Unhealthy 1s (x4 over 28s) kubelet Liveness probe failed: HTTP probe failed with statuscode: 500

Terminiamo l'esercizio:

kubectl delete -f ~/scripts/http-liveness.yml

HTTP Readiness

Una leggera modifica alle specifiche di liveness:

vim ~/scripts/http-readiness.yml

apiVersion: v1

kind: Pod

metadata:

labels:

test: readiness

name: readiness-http

spec:

containers:

- name: readiness

image: registry.k8s.io/liveness

args:

- /server

readinessProbe:

httpGet:

path: /healthz

port: 8080

httpHeaders:

- name: Custom-Header

value: Awesome

initialDelaySeconds: 3

periodSeconds: 3

Sottomettere il manifest:

kubectl apply -f ~/scripts/http-readiness.yml

Inizialmente il pod si comporta come prima, e dopo 10 secondi fallisce. Kubernetes lo dichiara fallito e non lo ristarta.

Il rapporto di eventi è:

kubectl describe pod readiness-http

.....

Warning Unhealthy 18s (x21 over 75s) kubelet Readiness probe failed: HTTP probe failed with statuscode: 500

E il pod:

kubectl get pod

NAME READY STATUS RESTARTS AGE

readiness-http 0/1 Running 0 2m5s

Pulire l'esercizio:

kubectl delete -f ~/scripts/http-readiness.yml

TCP Liveness e Readiness

Prepariamo un manifest:

vim ~/scripts/tcp-liveness-readiness.yml

apiVersion: v1

kind: Pod

metadata:

name: goproxy

labels:

app: goproxy

spec:

containers:

- name: goproxy

image: registry.k8s.io/goproxy:0.1

ports:

- containerPort: 8080

readinessProbe:

tcpSocket:

port: 8080

initialDelaySeconds: 15

periodSeconds: 10

livenessProbe:

tcpSocket:

port: 8080

initialDelaySeconds: 15

periodSeconds: 10

Ha entrambi i tipi di probe, a scopo didattico per notare che non vi è differenza sintattica ma solo di comportamento. Basta uno o l'altro probe.

Kubernetes prova un'apertura di connessione alla porta 8080. Se ha successo il pod è alive/ready.

Sottomettiamo il manifest:

kubectl apply -f ~/scripts/tcp-liveness-readiness.yml

Non vi sono eventi di errore dopo tempo ragguardevole. Il pod sta bene.

Terminiamo l'esercizio:

kubectl delete -f ~/scripts/tcp-liveness-readiness.yml

Sicurezza e Controllo di Accesso

Modello

Una tipica rcichiesta API dal client kubectl allo API Server di Kubernetes passa possibilmente attraveso alcune fasi di sicurezza:

Le fasi sono:

- Autenticazione

- Autorizzazione RBAC

- Controllo di Accesso

RBAC è il modello di autorizzazjone usato da Kubernetes: Role Based Access Control.

Questo modello implementa il Principio del Minimo Privilegio: tutte le azioni sono proibite a meno che esista una regola che le consenta.

Esempio: L'utente pippo vuole creare un Deployment app1 nel namespace util.

- il modulo di autenticazione determina se pippo è un utente reale o un impostore

- il modulo di autorizzazione determina se pippo ha il permesso di creare un Deloyment nel namespace util

- il controllo di accesso applica le policy di creazione di Deployment

Autenticazione

Livello indicato anche come AuthN (auth-enne).

Le richieste API includono credenziali e il modulo le verifica. Se la verifica fallisce, viene ritornato un errore HTTP 401.

Il modulo non è parte di Kubernetes, che non si occupa di gestione account. Questa è fornita dall'esterno, possibilmente con un plugin, p.es. il Cloud Provider fornisce il plugin e le credenziali di autenticazione.

Le credenziali di autenticazione sono mantenute nel file di kubeconfig, che nel caso di Linux è $HOME/.kube/config.

less ~/.kube/config

...

users:

- name: kind-kind

user:

client-certificate-data: ...

client-key-data: ...

...

Si può vedere la configurazione più concisamente col comando:

kubectl config view

Nel nostro caso è un Certificato Client, supportato da ogni versione di Kubernetes.

Questo certificato è stato prodotto da Kind in fase di installazione del cluster. Alternativamente si possono usare strumenti esterni per generarlo, e inserirlo nel file di configurazione.

Si può ispezionare il certificato degli utenti installando l'utility jq:

sudo apt install jq

E dando il comando:

kubectl config view --raw -o json \

| jq ".users[] | select(.name==\"$(kubectl config current-context)\")" \

| jq -r '.user["client-certificate-data"]' \

| base64 -d | openssl x509 -text

Autorizzazione

Abbreviato in AuthZ (auth-zi).

Si occupa di tre aspetti:

- users

- actions

- resuorces

Descrive quali users possono compire quali actions su che tipo di resources.

Un esempio può essere dato dalla seguente tabella:

| User (subject) | Action | Resource |

|---|---|---|

| Bao | create | Pods |

| Kalila | list | Deployments |

| Josh | delete | ServiceAccounts |

RBAC si basa su due concetti:

- Role - definisce un insieme di permessi

- RoleBinding - concede i permessi a utenti

Role

Un esempio di Manifest che definisce un Role:

apiVersion: rbac.authorization.k8s.io/v1

kind: Role

metadata:

namespace: shield

name: read-deployments

rules:

- apiGroups: ["apps"]

resources: ["deployments"]

verbs: ["get", "watch", "list"]

Notare la particolare apiVersion.

Notare le direttive:

namespace- si applica a questo spazio nomiapiGroups- indica la componente gruppo del campoapiVersion- per esempio sappiamo che i Deployments hanno apiVersion

apps/v1 - se

apiGroupsè omesso o seapiGroups: [""], allora è lo apiGroup core, p.es. Services che ha soloapiVersion: v1

- per esempio sappiamo che i Deployments hanno apiVersion

resources- quali oggetti Kubernetes sono influitiverbs- quali comandi dikubectlsi possono usare

Per avere una lista dei verbi disponibili per ogni risorsa:

kubectl api-resources --sort-by name -o wide

Nei campi apiGroups, resources e verbs si può mettere un asterisco (*) che indica tutti i valori.

Per esempio:

...

rules:

- apiGroups: ["*"]

resources: ["*"]

verbs: ["*"]

...

RoleBinding

Un Role deve essere collegato ad un utente con un RoleBinding.

Esempio:

apiVersion: rbac.authorization.k8s.io/v1

kind: RoleBinding

metadata:

name: read-deployments

namespace: shield

subjects:

- kind: User

name: sky

# This is the authenticated user

apiGroup: rbac.authorization.k8s.io

roleRef:

kind: Role

name: read-deployments

# This is the Role to bind to the user

apiGroup: rbac.authorization.k8s.io

L'utente autenticato "sky" può compiere un comando come: kubectl get deployments -n shield.

Con adeguata progettazione dei Role e RoleBinding si ottiene che certi utenti autenticati possano compiere solo certe azioni solo su certi oggetti di un determinato spazio nomi.

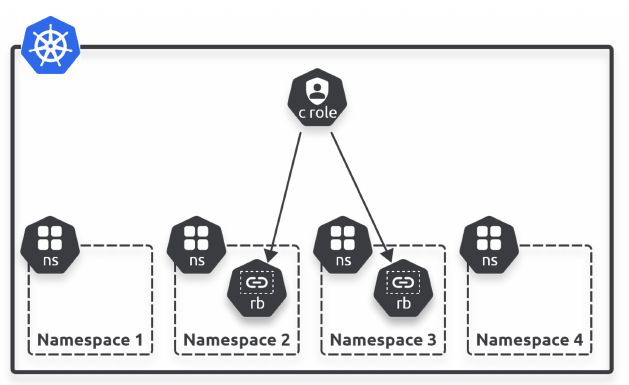

Cluster Level

Vi sono in realtà 4 oggetti RBAC:

- Roles

- ClusterRoles

- RoleBindings

- ClusterRoleBindings

Roles e RoleBindings sono specifici di namespace.

ClusterRoles e ClusterRoleBindings si applicano all'intero cluster.

ClusterRole

Esempio:

apiVersion: rbac.authorization.k8s.io/v1

kind: ClusterRole

metadata:

name: read-deployments

rules:

- apiGroups: ["apps"]

resources: ["deployments"]

verbs: ["get", "watch", "list"]

NOTA

Questo è solo un esempio. In generale non è una buona idea modificare i ClusterRole o ClusterRoleBinding se non si procede com molta cautela

Una serie di ClusterRole sono definiti nel cluster. Per vederli:

kubectl get clusterrole

Molti sono creati all'atto dell'installazione del cluster. Alcuni sono stati aggiunti da Manifests.

Per vedere i dettagli di un ClusterRole, p.es.:

kubectl describe clusterrole metallb-system:controller

ClusterRoleBinding

Vedere tutti i ClusterRoleBinding:

kubectl get vlusterrolebinding

Vedere i dettagli di uno, p.es.:

kubectl describe clusterrolebinding system:basic-user

Name: system:basic-user

Labels: kubernetes.io/bootstrapping=rbac-defaults

Annotations: rbac.authorization.kubernetes.io/autoupdate: true

Role:

Kind: ClusterRole

Name: system:basic-user

Subjects:

Kind Name Namespace

---- ---- ---------

Group system:authenticated

Sequenza

Il cluster ispeziona il certificato dell'utente che accede, ricercando il campo "Subject:". Lo possiamo vedere da:

kubectl config view --raw -o json \

| jq ".users[] | select(.name==\"$(kubectl config current-context)\")" \

| jq -r '.user["client-certificate-data"]' \

| base64 -d | openssl x509 -text | grep "Subject:"

Subject: O = system:masters, CN = kubernetes-admin

Ne estrae la proprietà O che ha valore system:masters. Questo è un gruppo predefinito che equivale agli amministratori globali di sistema.

Il ClusterRoleBinding corrispondente, predefinito, è cluster-admin. Lo si può vedere con:

kubectl describe clusterrolebinding cluster-admin

Name: cluster-admin

Labels: kubernetes.io/bootstrapping=rbac-defaults

Annotations: rbac.authorization.kubernetes.io/autoupdate: true

Role:

Kind: ClusterRole

Name: cluster-admin

Subjects:

Kind Name Namespace

---- ---- ---------

Group system:masters

Il ClusterRole associato è cluster-admin. Possiamo ispezionarlo con:

kubectl describe clusterrole cluster-admin

Name: cluster-admin

Labels: kubernetes.io/bootstrapping=rbac-defaults

Annotations: rbac.authorization.kubernetes.io/autoupdate: true

PolicyRule:

Resources Non-Resource URLs Resource Names Verbs

--------- ----------------- -------------- -----

*.* [] [] [*]

[*] [] [*]

Questo equivale in pratica a tutti i permessi su tutti gli spazi nomi.

Controllo Accesso

E' basato su una serie di Policy ed è implementato da degli Admission Controllers.

Vi sono due tipi di Admission Controllers:

- validating - controllano la validità di una richiesta ma non possono cambiarla

- mutating - possono modificare una richiesta

Gli Admission Controllers di tipo Mutating sono eseguiti per primi.

Un'implementazione di cluster ha un numero considerevole di Admission Controllers. Sono controllati da un numero considerevole di settaggi nei Manifest delle risorse gestite.

Per esempio, il settaggio .spec.containers.imagePullPolicy corrisponde al controller AlwaysPullImages.

La possibilità di loro gestione è determinata dall'implementazione del cluster, ed è di solito eseguita col comando kube-apiserver.

Nell'implementazione cluster Kind questo comando non è direttamente usabile ma è interno al pod kube-apiserver-kind-control-plane nello spazio nomi kube-system.

Per vedere i Controllers installati in Kind, il comando può essere:

kubectl exec kube-apiserver-kind-control-plane \

-n kube-system -- kube-apiserver --help | \

grep enable-admission-plugins | grep enabled | \

cut -d. -f2

Sfortunatamente il controllo fine può essere eseguito solo modificando il codice sorgente di Kind.

Esempi

Il Manifest di creazione del servizio di Metallb fornisce numerosi esempi d'uso di controllo di accesso.

Creazione di ServiceAccount

apiVersion: v1

kind: ServiceAccount

metadata:

labels:

app: metallb

name: controller

namespace: metallb-system

Definizione di ClusterRole

Il ClusterRole è globale di cluster.

Una serie di regole, ciascuna contraddistinta da apiGroups/resources.

Quali sono i verbi, cioè le azioni, che chi possiede questo ClusterRole può compiere sugli apiGroups/resources.

apiVersion: rbac.authorization.k8s.io/v1

kind: ClusterRole

metadata:

labels:

app: metallb

name: metallb-system:controller

rules:

- apiGroups:

- ''

resources:

- services

verbs:

- get

- list

- watch

- apiGroups:

- ''

resources:

- services/status

verbs:

- update

- apiGroups:

- ''

resources:

- events

verbs:

- create

- patch

- apiGroups:

- policy

resourceNames:

- controller

resources:

- podsecuritypolicies

verbs:

- use

Definizione di Role

Locale di namespace. Serie di regole serie di regole, ciascuna contraddistinta da apiGroups/resources.

Quali sono i verbi, cioè le azioni, che chi possiede questo ClusterRole può compiere sugli apiGroups/resources.

apiVersion: rbac.authorization.k8s.io/v1

kind: Role

metadata:

labels:

app: metallb

name: config-watcher

namespace: metallb-system

rules:

- apiGroups:

- ''

resources:

- configmaps

verbs:

- get

- list

- watch

Chi possiede il ruolo config-watcher, solo nel namespace metallb-system: su tutti i ConfigMaps può dare i comandi kubectl get, kubectl list e kubectl watch.

In realtà non sono comandi client di kubectl, sono verbi della API REST che vengono inviati allo API Server.

Definizione di RoleBinding

Associazione tra ServiceAccount e Role.

Questo RoleBinding si chiama config-watcher, che è anche il nome di un Role: non confondersi, sono due oggetti diversi.

apiVersion: rbac.authorization.k8s.io/v1

kind: RoleBinding

metadata:

labels:

app: metallb

name: config-watcher

namespace: metallb-system

roleRef:

apiGroup: rbac.authorization.k8s.io

kind: Role

name: config-watcher

subjects:

- kind: ServiceAccount

name: controller

- kind: ServiceAccount

name: speaker

DaemonSet

Finalmente il Daemonset contiene specifiche di chi può operare.

Contiene anche molti altri elementi interessanti, utili per imparare seguendo gli esempi.

Prima l'intera specifica:

apiVersion: apps/v1

kind: DaemonSet

metadata:

labels:

app: metallb

component: speaker

name: speaker

namespace: metallb-system

spec:

selector:

matchLabels:

app: metallb

component: speaker

template:

metadata:

annotations:

prometheus.io/port: '7472'

prometheus.io/scrape: 'true'

labels:

app: metallb

component: speaker

spec:

containers:

- args:

- --port=7472

- --config=config

- --log-level=info

env:

- name: METALLB_NODE_NAME

valueFrom:

fieldRef:

fieldPath: spec.nodeName

- name: METALLB_HOST

valueFrom:

fieldRef:

fieldPath: status.hostIP

- name: METALLB_ML_BIND_ADDR

valueFrom:

fieldRef:

fieldPath: status.podIP

# needed when another software is also using memberlist / port 7946

# when changing this default you also need to update the container ports definition

# and the PodSecurityPolicy hostPorts definition

#- name: METALLB_ML_BIND_PORT

# value: "7946"

- name: METALLB_ML_LABELS

value: "app=metallb,component=speaker"

- name: METALLB_ML_SECRET_KEY

valueFrom:

secretKeyRef:

name: memberlist

key: secretkey

image: quay.io/metallb/speaker:v0.12.1

name: speaker

ports:

- containerPort: 7472

name: monitoring

- containerPort: 7946

name: memberlist-tcp

- containerPort: 7946

name: memberlist-udp

protocol: UDP

livenessProbe:

httpGet:

path: /metrics

port: monitoring

initialDelaySeconds: 10

periodSeconds: 10

timeoutSeconds: 1

successThreshold: 1

failureThreshold: 3

readinessProbe:

httpGet:

path: /metrics

port: monitoring

initialDelaySeconds: 10

periodSeconds: 10

timeoutSeconds: 1

successThreshold: 1

failureThreshold: 3

securityContext:

allowPrivilegeEscalation: false

capabilities:

add:

- NET_RAW

drop:

- ALL

readOnlyRootFilesystem: true

hostNetwork: true

nodeSelector:

kubernetes.io/os: linux

serviceAccountName: speaker

terminationGracePeriodSeconds: 2

La linea:

serviceAccountName: speaker

specifica che questo DaemonSet opera come account Speaker, definito sopra, che ha sicuramente un RoleBinding ad un Role, e quest'ultimo lista le azioni che può compiere sulle varie risorse.

Le linee:

nodeSelector:

kubernetes.io/os: linux

richiedono che il sistema operativo sottostante sia Linux.

Le linee:

tolerations:

- effect: NoSchedule

key: node-role.kubernetes.io/master

operator: Exists

richiedono che il pod del DaemonSet corrente non venga schedulato sul Master del cluster.

Il Security Context del contenitore del pod è particolarmente interessante:

securityContext:

allowPrivilegeEscalation: false

capabilities:

add:

- NET_RAW

drop:

- ALL

readOnlyRootFilesystem: true

L'account che opera i pod di questo DaemonSet, che è speaker:

- non può dare comandi equivalenti a

sudoche compiano un Privilege Escalation - se usa il filesystem di root (quello del container), è in sola lettura

- tutti i capabilities sono tolti eccetto NET_RAW, evidentemente il programma inserito nell'immagine usa solo un socket 'Raw', come fa ad esempio ICMP.

Notare le linee:

- name: METALLB_ML_BIND_ADDR

valueFrom:

fieldRef:

fieldPath: status.podIP

Sono l'assegnazione di valore ad una variabile d'ambiente, prese dal campo status.podIP. Quando il pod è creato e allocato ad un nodo, il suo indirizzo IP è già stato assegnato.

L'interessante è che questo campo non esiste nel Manifest, che descrive il desired state, ma è parte del current state del pod appena creato.

Notare anche i probe Liveness e Readiness.

Deployment

Il Deployment è anch'esso interessante:

apiVersion: apps/v1

kind: Deployment

metadata:

labels:

app: metallb

component: controller

name: controller

namespace: metallb-system

spec:

revisionHistoryLimit: 3

selector:

matchLabels:

app: metallb

component: controller

template:

metadata:

annotations:

prometheus.io/port: '7472'

prometheus.io/scrape: 'true'

labels:

app: metallb

component: controller

spec:

containers:

- args:

- --port=7472

- --config=config

- --log-level=info

env:

- name: METALLB_ML_SECRET_NAME

value: memberlist

- name: METALLB_DEPLOYMENT

value: controller

image: quay.io/metallb/controller:v0.12.1

name: controller

ports:

- containerPort: 7472

name: monitoring

livenessProbe:

httpGet:

path: /metrics

port: monitoring

initialDelaySeconds: 10

periodSeconds: 10

timeoutSeconds: 1

successThreshold: 1

failureThreshold: 3

readinessProbe:

httpGet:

path: /metrics

port: monitoring

initialDelaySeconds: 10

periodSeconds: 10

timeoutSeconds: 1

successThreshold: 1

failureThreshold: 3

securityContext:

allowPrivilegeEscalation: false

capabilities:

drop:

- all

readOnlyRootFilesystem: true

nodeSelector:

kubernetes.io/os: linux

securityContext:

runAsNonRoot: true

runAsUser: 65534

fsGroup: 65534

serviceAccountName: controller

terminationGracePeriodSeconds: 0

Vi sono due securityContext, uno a livello container e uno a livello pod. Quest'ultimo è:

securityContext:

runAsNonRoot: true

runAsUser: 65534

fsGroup: 65534

serviceAccountName: controller

L'utente controller, che gestisce questo deployment, se ha interazioni con il Linux sottostante, è mappato all'utente di sistema 65534, gruppo di sistema 65534.

Le annotazioni:

annotations:

prometheus.io/port: '7472'

prometheus.io/scrape: 'true'

vengono usate dall'utility Prometheus se esistente.

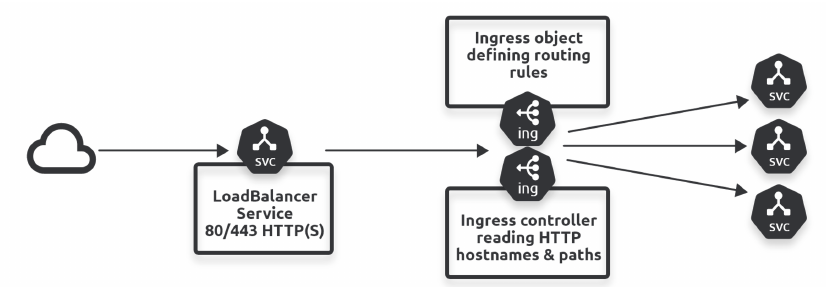

Ingress

Un LoadBalancer usa un indirizzo pubblico dal pool di indirizzi per ogni servizio configurato.

In un LoadBalancer implementato localmente gli indirizzi del pool possono essere insufficienti. Se il LoadBalancer è fornito dal Cloud Provider, ogni sua istanza ha un costo.

Ingress espone servizi multipli tramite un unico Load Balancer.

Ha due componenti:

- Ingress controller

- Ingress object

Molte installazioni di cluster Kubernetes, come Kind, non forniscono un Ingress Controller di serie, quindi va installato.

Per l'uso di un cluster Kubernetes di uno specifico Cloud Controller, leggere la documentazione appropriata.

Ingress su Kind

Kind supporta tre Ingress Controllers:

- Contour

- Ingress Kong

- Ingress Nginx

Useremo qui Ingress Nginx-

Modifica del Cluster Kind

Occorre modificare la costruzione del cluster.

Cancellare il cluster corrente con la nostra procedura shell:

cd

./teardown,sh

Creiamo una nuova procedura shell di setup del cluster chiamata ingress.sh:

vim ingerss.sh

#!/bin/sh

set -o errexit

# crea il contenitore del registry se non esiste

reg_name='kind-registry'

reg_port='5000'

if [ "$(docker inspect -f '{{.State.Running}}' "${reg_name}" 2>/dev/null || true)" != 'true' ]; then

docker run \

-d --restart=always -p "127.0.0.1:${reg_port}:5000" --name "${reg_name}" \

-v $HOME/.docker/registry:/var/lib/registry registry:2

fi

# crea un cluster con il registry locale abilitato in containerd

cat <<EOF | kind create cluster --image kindest/node:v1.24.0 --config=-

kind: Cluster

apiVersion: kind.x-k8s.io/v1alpha4

containerdConfigPatches:

- |-

[plugins."io.containerd.grpc.v1.cri".registry.mirrors."localhost:${reg_port}"]

endpoint = ["http://${reg_name}:5000"]

nodes:

- role: control-plane

kubeadmConfigPatches:

- |

kind: InitConfiguration

nodeRegistration:

kubeletExtraArgs:

node-labels: "ingress-ready=true"

extraPortMappings:

- containerPort: 80

hostPort: 80

protocol: TCP

- containerPort: 443

hostPort: 443

protocol: TCP

extraMounts:

- hostPath: /data

containerPath: /data

- role: worker

extraMounts:

- hostPath: /data

containerPath: /data

- role: worker

extraMounts:

- hostPath: /data

containerPath: /data

EOF

# connette il registry alla rete del cluster se non connesso

if [ "$(docker inspect -f='{{json .NetworkSettings.Networks.kind}}' "${reg_name}")" = 'null' ]; then

docker network connect "kind" "${reg_name}"

fi

# Documenta il local registry

cat <<EOF | kubectl apply -f -

apiVersion: v1

kind: ConfigMap

metadata:

name: local-registry-hosting

namespace: kube-public

data:

localRegistryHosting.v1: |

host: "localhost:${reg_port}"

help: "https://kind.sigs.k8s.io/docs/user/local-registry/"

EOF

La sezione aggiunta, dopo la linea - role: control-plane è:

kubeadmConfigPatches:

- |

kind: InitConfiguration

nodeRegistration:

kubeletExtraArgs:

node-labels: "ingress-ready=true"

extraPortMappings:

- containerPort: 80

hostPort: 80

protocol: TCP

- containerPort: 443

hostPort: 443

protocol: TCP

Rendiamola eseguibile:

chmod +x ingress.sh

Copiamo la procedura di setup in una nuova:

cp setup.sh setup-ingress.sh

Modifichiamo la nuova procedura setup-ingress.sh sostituendo le linee:

echo "~/std.sh"

~/std.sh

con

echo "~/ingress.sh"

~/ingress.sh

Lanciamo il nuovo cluster che supporta Ingress:

./setup-ingress.sh

Deployment di Ingress

Copiamo dalla rete il Deployment del controller di Ingress e poniamolo nella directory ~/scripts:

wget https://raw.githubusercontent.com/kubernetes/ingress-nginx/main/deploy/static/provider/kind/deploy.yaml

mv deploy.yaml ~/scripts/ingress-deploy.yml

Eseguiamo il deployment e attendiamo che sia pronto:

kubectl apply -f ~/scripts/ingress-deploy.yml

echo Waiting up to 120s for nginx-ingress pod ...

kubectl wait --namespace ingress-nginx \

--for=condition=ready pod \

--selector=app.kubernetes.io/component=controller \

--timeout=120s

Test di Ingress

Prepariamo un Manifest di test:

vim ~/scripts/nginx-test.yml

kind: Pod

apiVersion: v1

metadata:

name: foo-app

labels:

app: foo

spec:

containers:

- command:

- /agnhost

- netexec

- --http-port

- "8080"

image: registry.k8s.io/e2e-test-images/agnhost:2.39

name: foo-app

---

kind: Service

apiVersion: v1

metadata:

name: foo-service

spec:

selector:

app: foo

ports:

# Default port used by the image

- port: 8080

---

kind: Pod

apiVersion: v1

metadata:

name: bar-app

labels:

app: bar

spec:

containers:

- command:

- /agnhost

- netexec

- --http-port

- "8080"

image: registry.k8s.io/e2e-test-images/agnhost:2.39

name: bar-app

---

kind: Service

apiVersion: v1

metadata:

name: bar-service

spec:

selector:

app: bar

ports:

# Default port used by the image

- port: 8080

---

apiVersion: networking.k8s.io/v1

kind: Ingress

metadata:

name: example-ingress

annotations:

nginx.ingress.kubernetes.io/rewrite-target: /$2

spec:

rules:

- http:

paths:

- pathType: ImplementationSpecific

path: /foo(/|$)(.*)

backend:

service:

name: foo-service

port:

number: 8080

- pathType: ImplementationSpecific

path: /bar(/|$)(.*)

backend:

service:

name: bar-service

port:

number: 8080

Lo sottomettiamo:

kubectl apply -f ~/scripts/nginx-test.yml

E attendiamo che i pod vengano creati.

Connessioni di prova:

curl localhost/foo/hostname

foo-app

curl localhost/bar/hostname

bar-app

Al termine cancelliamo dal manifest:

kubectl delete -f ~/scripts/nginx-test.yml

Altro Esempio

Il seguente esempio è preso dal libro The Kubernetes Book di Nigel Poulton.

Abbiamo un Manifest con due pod e due servizi:

mkdir -p ~/scripts/ig

vim ~/scripts/ig/app.yml

apiVersion: v1

kind: Service

metadata:

name: svc-shield

spec:

type: ClusterIP

ports:

- port: 8080

targetPort: 8080

selector:

env: shield

---

apiVersion: v1

kind: Service

metadata:

name: svc-hydra

spec:

type: ClusterIP

ports:

- port: 8080

targetPort: 8080

selector:

env: hydra

---

apiVersion: v1

kind: Pod

metadata:

name: shield

labels:

env: shield

spec:

containers:

- image: nigelpoulton/k8sbook:shield-ingress

name: shield-ctr

ports:

- containerPort: 8080

imagePullPolicy: Always

---

apiVersion: v1

kind: Pod

metadata:

name: hydra

labels:

env: hydra

spec:

containers:

- image: nigelpoulton/k8sbook:hydra-ingress

name: hydra-ctr

ports:

- containerPort: 8080

imagePullPolicy: Always

Sottomettiamo il manifest:

kubectl apply -f ~/scripts/ig/app.yml

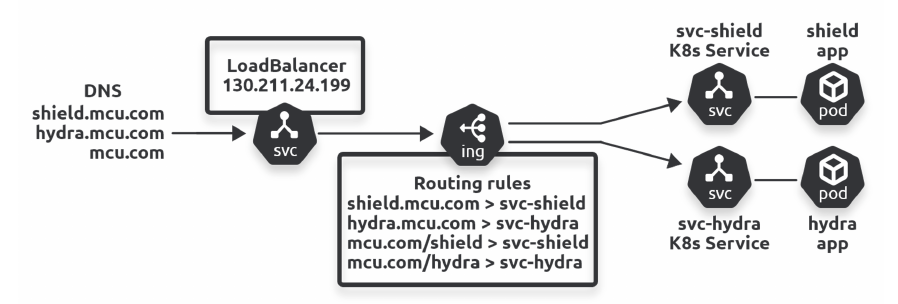

Abbiamo due possibilitè per Ingress:

- Host Based Routing - il routing al servizio avviene sulla base dello host di destinazione

- Path Based Routing - il routing al servizio avviene sulla base del Path nella URL

Nell'esercizio la situazione è:

- Host-based: shield.mcu.com >> svc-shield

- Host-based: hydra.mcu.com >> svc-hydra

- Path-based: mcu.com/shield >> svc-shield

- Path-based: mcu.com/hydra >> svc-hydra

L'oggetto Ingress viene specificato dal manifest:

vim ~/scripts/ig/ig-all.yml

apiVersion: networking.k8s.io/v1

kind: Ingress

metadata:

name: mcu-all

annotations:

nginx.ingress.kubernetes.io/rewrite-target: /

spec:

ingressClassName: nginx

rules:

- host: shield.mcu.com

http:

paths:

- path: /

pathType: Prefix

backend:

service:

name: svc-shield

port:

number: 8080

- host: hydra.mcu.com

http:

paths:

- path: /

pathType: Prefix

backend:

service:

name: svc-hydra

port:

number: 8080

- host: mcu.com

http:

paths:

- path: /shield

pathType: Prefix

backend:

service:

name: svc-shield

port:

number: 8080

- path: /hydra

pathType: Prefix

backend:

service:

name: svc-hydra

port:

number: 8080

Note

L'annotazione nginx.ingress.kubernetes.io/rewrite-target: / e' indispensabile per permettere a Ingress il reindirizzamento della richiesta.

E' un esempio di Annotation interpretata da un Controller specifico.

La specifica ingressClassName: nginx non è indispensabile se sul nostro cluster abbiamo solo lo Nginx Ingress Controller.

Qualora vi fossero più Ingress controller dovremmo configurare una classe per ciascuno, per esempio col Manifest:

apiVersion: networking.k8s.io/v1

kind: IngressClass

metadata:

name: igc-nginx

spec:

controller: nginx.org/ingress-controller

Sottoponiamo il manifest:

kubectl apply -f ~/scripts/ig/ig-all.yml

Ispezione degli oggetti Ingress:

kubectl get ing

Descrizione di un oggetto Ingress:

kubectl describe ing mcu-all

Notare la sezione Regole:

Rules:

Host Path Backends

---- ---- --------

shield.mcu.com

/ svc-shield:8080 (10.244.1.10:8080)

hydra.mcu.com

/ svc-hydra:8080 (10.244.2.5:8080)

mcu.com

/shield svc-shield:8080 (10.244.1.10:8080)

/hydra svc-hydra:8080 (10.244.2.5:8080)

Notare anche il campo Address: localhost

Modificare il file /etc/hosts aggiungendo le linee:

127.0.0.1 shield.mcu.com

127.0.0.1 hydra.mcu.com

127.0.0.1 mcu.com

Aprire un browser e testare i seguenti URL:

- shield.mcu.com

- hydra.mcu.com

- mcu.com/shield

- mcu.com/hydra

Al termine ripulire:

kubectl delete -f ~/scripts/ig/ig-all.yml

kubectl delete -f ~/scripts/ig/app.yml

Rimettere anche a posto /etc/hosts.

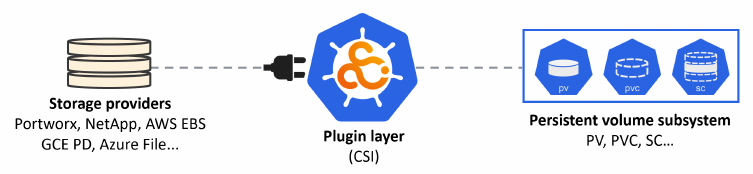

Storaggio

Kubernetes supporta numerosi tipi di storaggio: iSCSI, SMB, NFS, object storage blobs, ecc. I fornitori (Provisioner) di storaggio possono essere in-house o nel cloud.

E' necessario che Kubernetes installi un plugin per supportare lo storaggio specifico, fornito dal Provisioner.

Il plugin deve essere conforme allo standard CSI - Container Storage Interface.

Purtroppo i cluster Kind e Minikube non supportano questa funzionalità e sono limitati allo storaggio Standard - locale, o NFS visto come directory locale.

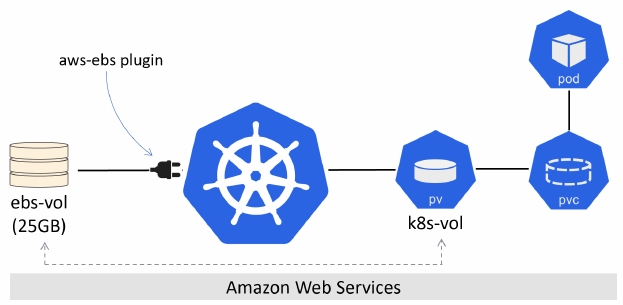

Per esempio un cluster è implementato su AWS e l'amministratore di AWS ha creato un volume di 25GB chiamato ebs-vol. L'amministratore di Kubernetes crea un PV chiamato k8s-vol collegato al volume ebs-vol dal plugin kubernetes.io/aws-ebs.

Sistema Persistent Volume

Le tre risorse principlali del sistema Persistent Volume sono:

- Persistent Volume (pv)

- Persistent Volume Claim (pvc)

- Storage Class (sc)

I passi in Kubernetes sono:

- Creare il PV

- Creare il PVC

- Definire il volume nelle specifiche di un Pod

- Montarlo in un container

Esempio di creazione di PV.

vim gke-volume.yml

apiVersion: v1

kind: PersistentVolume

metadata:

name: pv1

spec:

accessModes:

- ReadWriteOnce

storageClassName: test

capacity:

storage: 10Gi

persistentVolumeReclaimPolicy: Retain

gcePersistentDisk:

pdName: user-disk

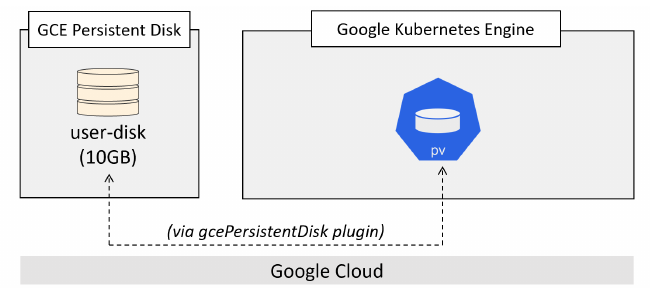

Il PV è altamente specifico al Provisioner. Per esempio l'attributo gcePersistentDisk si riferisce a Gookle e ha bisogno della presenza del plugin GCE. Il volume user-disk deve essere stato creato prima da GCE.

Anche la storage class di nome test è creata altrove.

Questo è solo un esempio illustrativo, non funziona col nostro cluster.

L'effetto graficamente espresso sarebbe:

La proprietò .spec.persistentVolumeReclaimPolicy dice a Kubernetes cosa farne del disco PV quando non è più in uso.

Due possibilità:

DeleteRetain

Retain ne conserva i dati, ma non sono più accessibili da un altro PVC in futuro. Il PV deve essere rimosso a mano.

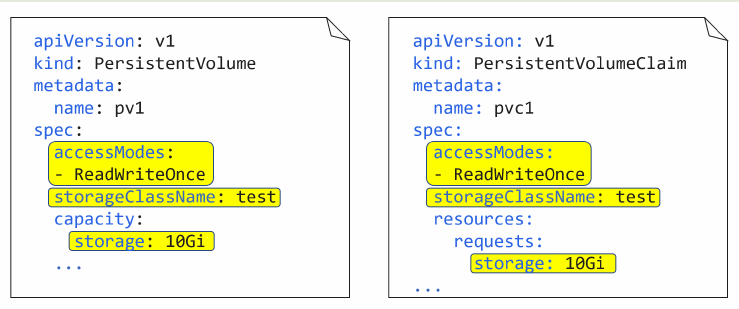

Un PVC corrispondente a questo PV sarebbe ad esempio:

vim gke-pvc.yml

apiVersion: v1

kind: PersistentVolumeClaim

metadata:

name: pvc1

spec:

accessModes:

- ReadWriteOnce

storageClassName: test

resources:

requests:

storage: 10Gi

Vi sono alcune proprietà che devono essere in corrispondenza:

Un pod che usa questo PVC potrebbe essere:

vim volpod.yml

apiVersion: v1

kind: Pod

metadata:

name: volpod

spec:

volumes:

- name: data

persistentVolumeClaim:

claimName: pvc1

containers:

- name: ubuntu-ctr

image: ubuntu:latest

command:

- /bin/bash

- "-c"

- "sleep 60m"

volumeMounts:

- mountPath: /data

name: data

Dynamic Provisioning

Il Dynamic Provisioning è la fornitura da parte del Provider di spazio disco on-demand, quando c'è un Pod che effettivamente lo usa.

Questa funzionalità è basata sul concetto di Storage Class.

Storage Class

Una StorageClass è una risorsa definita nel gruppo API storage.k8s.io/v1. Si riferisce ad un tipo di storaggio offerto da un Provisioner.

Esempio.

vim fast-sc.yml

kind: StorageClass

apiVersion: storage.k8s.io/v1

metadata:

name: fast

provisioner: kubernetes.io/aws-ebs

parameters:

type: io1

zones: eu-west-1a

opsPerGB: "10"

Sottomettere il manifest:

kubectl apply -f fast-sc.yml

Si visionano le storage classes con:

kubectl get sc

NAME PROVISIONER RECLAIMPOLICY VOLUMEBINDINGMODE ALLOWVOLUMEEXPANSION AGE

fast kubernetes.io/aws-ebs Delete Immediate false 19s

standard (default) rancher.io/local-path Delete WaitForFirstConsumer false 42h

La storage class viene creata anche se il plugin non è disponibile. E' solo al momento di creazione del PVC e Pod che si presentano dei problemi.

Si possono avere molte Storage Classee configurate. I parametri di ciascuna dipendono dal plugin del provisioner.

Per esempio:

vim sc-secure.yml

kind: StorageClass

apiVersion: storage.k8s.io/v1

metadata:

name: portworx-db-secure

provisioner: kubernetes.io/portworx-volume

parameters:

fs: "xfs"

block_size: "32"

repl: "2"

snap_interval: "30"

io-priority: "medium"

secure: "true"

Una StorageClass è un oggetto immutabile. Non si può modificare, solo cancellare e ricreare.

Le fasi d'uso sono:

- Creare il cluster Kubernetes

- Installare i necessari plugin per lo storage

- Creare una StorageClass

- Creare un PVC che si riferisce alla StorageClass

- Creare un Pod che usa un volume basato sul PVC

Non occorre quindi creare un oggetto PV, che è sostituito dalla StorageClass.

Esercizio Demo

Creare una StorageClass

Preparare la directory e creare il file di manifest:

mkdir -p ~/ex/sc

cd ~/ex/sc

vim google-sc.yml

kind: StorageClass

apiVersion: storage.k8s.io/v1

metadata:

name: slow

provisioner: kubernetes.io/gce-pd

parameters:

type: pd-standard

reclaimPolicy: Retain

Applicare il file di manifest:

kubectl apply -f google-sc.yml

Verifica:

kubectl get sc

kubectl describe sc slow

Creare un PVC

Il file di manifest:

vim google-pvc.yml

apiVersion: v1

kind: PersistentVolumeClaim

metadata:

name: pv-ticket

spec:

accessModes:

- ReadWriteOnce

storageClassName: slow

resources:

requests:

storage: 25Gi

Applicare il file di manifest:

kubectl apply -f google-pvc.yml

Verificare:

kubectl get pvc

NAME STATUS VOLUME CAPACITY ACCESS MODES STORAGECLASS AGE

pv-ticket Pending slow 3s

Notare lo stato Pending. Non abbiamo il driver CSI installato ed è in attesa che venga installato.

Ctreare un Pod

Il file fi manifest:

vim google-pod.yml

apiVersion: v1

kind: Pod

metadata:

name: class-pod

spec:

volumes:

- name: data

persistentVolumeClaim:

claimName: pv-ticket

containers:

- name: ubuntu-ctr

image: ubuntu:latest

command:

- /bin/bash

- "-c"

- "sleep 60m"

volumeMounts:

- mountPath: /data

name: data

Applicare il file di manifest: