Introduzione

Licenza

La presente documentazione è distribuita secondo i termini della GNU Free Documentation License Versione 1.3, 3 novembre 2008.

Ne è garantita assoluta libertà di copia, ridistribuzione e modifica, sia a scopi commerciali che non.

L'autore detiene il credito per il lavoro originale ma nè credito nè responsabilità per le modifiche.

Qualsiasi lavoro derivato deve essere conforme a questa stessa licenza.

Il testo pieno della licenza è a:

https://www.gnu.org/licenses/fdl.txt

Architettura Web

Abbiamo dovuto attendere circa il 1990 prima della vera rivoluzione democratica di Internet: il World Wide Web.

Il Prof. Tim Bernars-Lee del CERN di Ginevra ci ha dato un prodotto costituito da:

- un server per la distribuzione a richiesta di pagine Web

- il linguaggio di redazione delle Pagine Web: HTML - Hyper Text Markup Language

- la possibilità di collegare pagine ad altre pagine, anche su altri server, tramite degli Hyperlink

- un client per accedere al server, in realtà sviluppato più da altri che non dall'originatore iniziale

- il protocollo di comunicazione tra il client e il server: HTTP - Hyper Text Transfer Protocol

HTTP si è naturalmente molto evoluto, tecnicamente e socialmente, dagli albori, come tutto il mondo WWW.

HTTP ha una notevole importanza moderna come protocollo di accesso ad un servizio distribuito in rete, con tecnologie come Docker, Kubernetes, e altre simili.

Protocollo HTTP

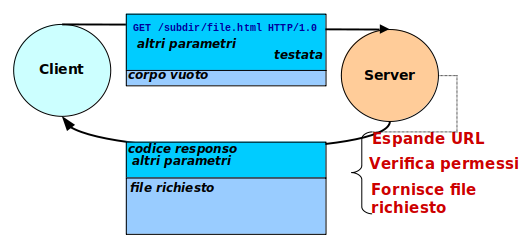

Il protocollo applicativo Hyper Text Transfer Protocol (HTTP) interscambia messaggi in codice ASCII a 7 bit tra un client e un server del protocollo.

I messaggi sono conformi ad uno standard TCP/IP, definito da una serie di documenti Request For Comments (RFC).

Struttura di un Messaggio

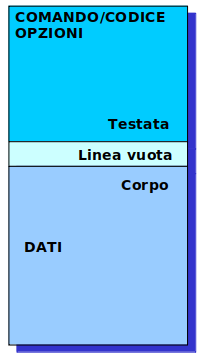

Ogni messaggio interscambiato ha:

- Testata del Messaggio

- Linea vuota separatrice

- Corpo del Messaggio - non sempre presente

Vi sono due tipi di messaggio:

- Richiesta - dal client al server

- Responso - dal server al client

Richiesta

La prima linea ha la struttura:

- Metodo - il tipo di processamento usato

- Risorsa - l'oggetto su cui il metodo opera

- HTTP/versione - l'identificativo del protocollo

Le linee seguenti sono headers della richiesta. Possono essere molte linee, una per ciascuno.

Uno header ha la struttura:

- Nome - singola parola, eventualmente contenente trattini separatori se più parole

- Due punti

- Valore - singolo, o più valori separati da virgole

Gli header consentiti sono tanti, parte dello standard. Server individuali possono avere un numero ridotto o esteso degli header accettati.

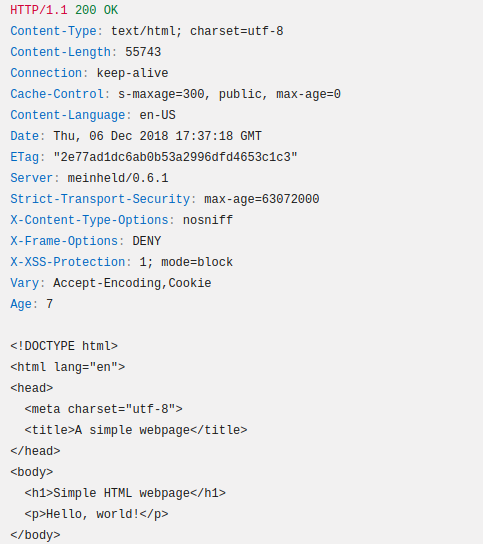

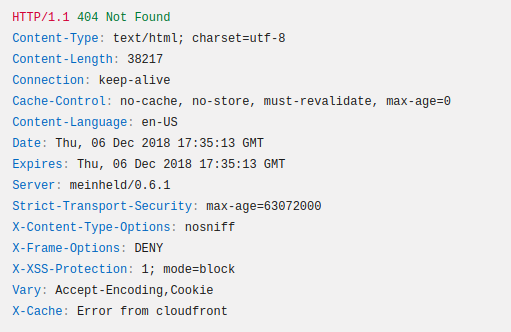

Responso

La prima linea ha la struttura:

- Codice di Stato

- Tipo Evento - corrispondente al codice

Seguono attributi, per la maggior parte informativi.

Gli attributi del responso hanno la stessa struttura sintattica di quelli della richiesta.

Tra alcuni attributi della richiesta e corrispondenti attributi del responso, è implementata una negoziazione di comportamenti, opzioni o features che il server può offrire.

Esempio di responso di successo:

Esempio di responso indicante fallimento:

Risorsa

E' l'identificativo di un oggetto su cui il server opera.

Formalmente, una URI (Uniform Resource Identifier) è l'intera stringa emessa dal browser, ed è divisa in due parti:

- la URL (Uniform Resource Locator), che indica come raggiungere e collegarsi al server

- la URN (Uniform Resource Name), la stringa che il server riceve nella prima linea della richiesta

Path

Nel caso più comune la parte path di un URN currisponde al percorso di un file al di sotto della directory principale di servizio pagine del server, la DocumentRoot.

La parte path di un URN non necessariamente corrisponde al percorso di un file, ma può essere un alias.

Il server trasforma il path iniziale in una stringa finale, detta route.

Un route specifico invoca uno handler, una funzione specifica che la elabora, o un programma esterno che viene in tal caso invocato ed esegue. Tale funzione o programma riceve come argomenti la richiesta in read-only e il responso in read-write. Legge, interpreta ed usa la richiesta, scrive il responso.

Query

I dati della richiesta possono essere:

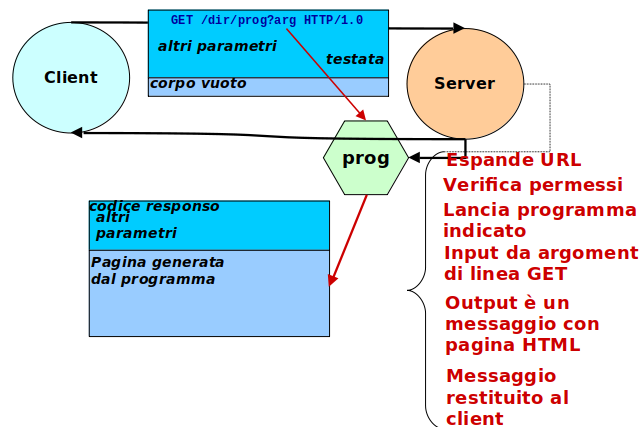

- presenti nel URN della testata, come parte query, se il metodo è

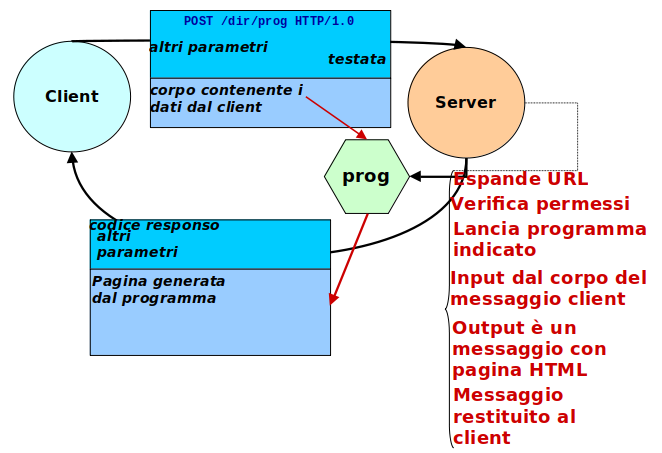

GET - presenti nel corpo se il metodo è

POST

Se i dati sono nella testata (GET) seguono le regole di costruzione stringa dette URL Encoding:

=assegna un valore ad una variabile&separa due assegnazioni+rappresenta uno spazio- qualsiasi altro carattere è rappresentato come

%xxovexxè il codice esadecimale del carattere nella tabella US ASCII

Se i dati sono nel corpo della richiesta, possono essere in un formato qualsiasi, naturalmente compreso dallo handler.

Un formato di rappresentazione dati molto usato è JSON - JavaScript Object Notation.

Fragment

Non è inviato al server ma processato dal client, in vari modi, spesso ollegati col tipo MIME della richiesta.

Metodi HTTP

| Metodo | Azione |

|---|---|

| GET | Trasferisce in download nel corpo la risorsa specificata dal server al client |

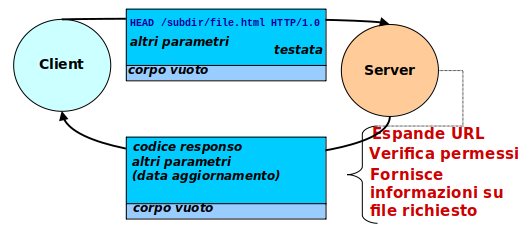

| HEAD | Responso identico a GET nello header, ma senza il dowload dell'oggetto |

| POST | Trasferisce in upload il contenuto del corpo ad un programma di processamento sul server |

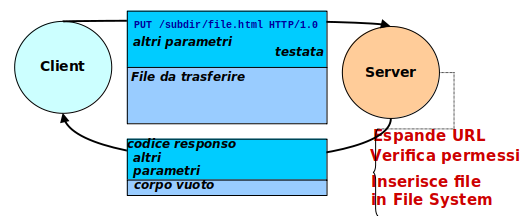

| PUT | Trasferisce in upload il contenuto del corpo alla risorsa specificata, creandola o rimpiazzandola |

| DELETE | Cancella dal server la risorsa specificata |

| CONNECT | Crea un tunnel tramite un proxy server con una destinazione finale specificata come risorsa |

| OPTIONS | Richiede i metodi disponibili per la risorsa specificata |

| TRACE | Compie un echo della richiesta nel responso, per debugging |

| PATCH | Compie una modifica parziale alla risorsa, con le istruzioni contenute nel corpo |

Esempio di Metodi HTTP

Richiesta GET

Richiesta HEAD

Richiesta PUT

Molti server non implementano la richiesta PUT: Problemi di Sicurezza

Codici di Stato HTTP

Mantenuti da IANA (Internet Assigned Numbers Authority) sulla base di vari documenti RFC.

La prima cifra del codice indica il tipo di evento verificatosi:

| Codice | Tipo Evento | Spiegazione |

|---|---|---|

| 1xx | Informational Response | Richiesta ricevuta e il processamento continua |

| 2xx | Success | La richiesta è stata accettata |

| 3xx | Redirection | Richieste ulteriori azioni per completare la richiesta |

| 4xx | Client Error | Ra richiesta contiene errori e non viene accettata |

| 5xx | Server Error | La richiesta è valida ma il server non riesce ad eseguirla per varie ragioni |

La lista completa di codici di stato è lunga e qui vengono listati i codici più comuni:

| Codice | Tipo Evento | Spiegazione |

|---|---|---|

| 200 | Ok | Richiesta completata con successo e viene ritornato l'oggetto richiesto |

| 201 | Created | Un oggetto è stato creata con successo |

| 202 | Accepted | Richiesta accettata ma non ancora processata |

| 204 | No Content | Richiesta completata con successo, ma non è richiesto on oggetto di ritorno |

| 301 | Moved Permanently | Specifica una URL a cui la richiesta deve sempre rivolgersi |

| 302 | Found (Moved Temporarily) | Specifica una URL a cui la richiesta deve rivolgersi questa singola volta |

| 400 | Bad Request | Richiesta mal formata |

| 401 | Unauthorized | Non è stata fornita autenticazione |

| 403 | Forbidden | Autenticazione errata o azione proibita dalle policy |

| 404 | Not Found | La risorsa richiesta non esiste |

| 405 | Method Not Allowed | Metodo di richiesta errato |

| 406 | Not Acceptable | Nessun metodo di negoziazione contenuto è disponibile |

| 407 | Proxy Authentication Required | Occorre prima l'autenticazione col proxy |

| 408 | Request Timeout | Troppo tempo per terminare la richiesta |

| 414 | URI Too Long | La URL di un GET è troppo lunga ed occorre usare un POST |

| 417 | Expectation Failed | Specifico tipo dello header Expect non è disponibile |

| 418 | I'm A Teapot | Uovo di Pasqua a volte usato invece di 403 Forbidden |

| 429 | Too Many Requests | Ecceduto il limite quando vi è un meccanismo di rate limiting |

| 451 | Unavailable For Legal Reasons | Accesso negato per motivi legali (da Fahrenheit 451) |

| 500 | Internal Server Error | Errore generico del server, non specificato |

| 501 | Not Implemented | Il server non conosce correntemente come processare la richiesta |

| 502 | Bad Gateway | Il server è un proxy e non riesce a contattare la destinazione |

| 503 | Service Unavailable | Indisponibilità temporanea del servizio |

| 504 | Gateway Timeout | Il server è un proxy ed è andato in timeout |

Vi sono svariati altri codici ufficiali del protocollo.

Vi sono anche codici non ufficiali, usati in specifiche implementazioni del server. Per esempio:

| Codice | Tipo Evento | Server | Spiegazione |

|---|---|---|---|

| 218 | This is fine | Apache | Errore in combinazione col settaggio ProxyErrorOverride |

| 420 | Method Failure | Spring | Fallimento di un metodo Java invocato |

| 430 | Shopify Security Rejection | Shopify | Errore di sicurezza |

| 440 | Login Time-out | Microsoft | Sessione scaduta |

| 450 | Blocked by Windows Parental Controls | Microsoft | Bloccato dal controllo parentale |

| 494 | Request header too large | Nginx | La testata della richiesta è troppo grossa |

| 495 | SSL Certificate Error | Nginx | Il certificato cliente è invalido |

| 496 | SSL Certificate Required | Nginx | Occorre un certificato cliente |

| 497 | HTTP Request Sent to HTTPS Port | Nginx | Protocollo di richiesta errato |

| 509 | Bandwidth Limit Exceeded | Apache | Superato il limite di banda |

La Specifica CGI

Common Gateway Interface:

- Il client invia dati al server

- Dati spesso generati da un FORM

- Il Server attiva un programma esterno

- Il programma riceve in input i dati del client

- Metodi GET e POST

- Il programma esegue

- p.es. Query di Database

- Il programma genera in output una pagina HTML

- La pagina viene inviata al client

Il Metodo GET

Il Metodo POST

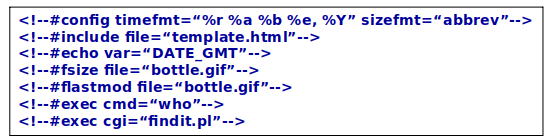

Server Side Includes

Comandi inseriti nel testo HTML, scanditi ed eseguiti dal server prima dell’invio pagina:

- Inclusi in commenti e preceduti da ‘#’

- Il server deve tipicamente essere abilitato a scandire le pagine contenenti SSI

- Le pagine contenenti SSI possono avere l'estensione

.shtml

Esempi:

Server e Client per il Web

Servers

Server Dedicati

Questa piccola lista enumera solo servers disponibili con una licenza Open Source, garanzia di qualità e trasparenza.

Apache Web Server

Scritto in Linguaggio C. Sorgenti disponibili sul sito di Apache e su https://github.com/apache/httpd.

Nato circa nel 1995, storicamente il più usato.

Solido e potente, supporta ogni feature del mondo Web.

Più del 40% dei siti mondiali.

Nginx

Pronunciato Engine-ex.

Scritto in Linguaggio C. Sorgenti disponibili, p.es. su https://github.com/nginx/nginx.

Sviluppato dal 2002, originariamente da Igor Sysoev, quindi passato ad una comunità di sviluppatori volontari.

Circa il 30% dei siti mondiali.

Apache Tomcat

Scritto in Java. Codice donato alla Apache dalla Sun Microsystem.

Sorgenti disponibili su, p.es. https://github.com/apache/tomcat.

La sua funzione primaria è come contenitore di oggetti servlet dell'universo Java. Funziona benissimo anche come normale server web.

Circa l'1% dei siti mondiali.

Lighttpd

Pronunciato Lightly.

Scritto in Linguaggio C. Sorgenti della versione 2 disponibili, p.es. su https://github.com/lighttpd/lighttpd2.

Leggero e con meno requisiti di risorse degli altri.

Non così completo come altri servers.

Circa lo 0,1% dei siti mondiali.

NOTA

Il motivo per cui la somma d'uso dei server elencati non si avvicina al 100% è che vi sono anche server non Open Source.

Server Programmati

La maggior parte dei linguaggi di programmazione permette di costruire dei server che gestiscono il protocollo HTTP e altri aspetti del mondo Web.

La complessità, e le corrispondenti prestazioni e possibilità operative variano enormemente.

Una menzione va a Node.js.

Node.js

E' in essenza un linguaggio di programmazione JavaScript lato server.

Consente quindi di redigere interi server web dal comportamento dinamico.

La sua principale limitazione, oltre che usare il JavaScript, è l'azzenza totale di parallelismo: è single-threaded di natura.

Clients

Browsers Grafici

Il primo browser grafico prodotto fu Viola, di Pei-Yuan Wei di Taiwan, e basato sull'innovativo sistema grafico X Window. L'autore lavorava sul concetto di hyperlink, con spunti da Apple Hypercard, e si dice che in realtà sia stato lui ad inventare il concetto di World Wide Web, invece di Tim Berners-Lee.

Marc Andreesen, nuovo impiegato del National Center for Supercomputing Applications (Urbana, Illinois), sviluppò a partire dai primi anni '90 il browser grafico, Mosaic.

Questo rese il nuovo ambiente WWW molto usabile da un utente comune e determinò il rapido successo del web.

Ora non più in uso, Mosaic si è presto evoluto in un nuovo (per allora) prodotto, proprietario ma gratuito, Netscape Navigator.

La Netscape ha introdotto per il suo Navigator, e per i server web, il protocollo Secure Socket Layer.

Navigator si è successivamente evoluto e gli è stato dato il nome del progetto originale di Marc Andreesen, Mozilla. Mozilla è diventata un'entità giuridica indipendente, ed ha prodotto il moderno browser Firefox.

Ad oggi di browser grafici ve ne è un numero considerevole, tra cui:

- Mozilla Firefox

- Google Chrome

- Brave

- Vivaldi

- Opera

- Apple Safari

- Microsoft Edge

Command Line Interface

Comandi da terminale, non grafici, che compiono un collegamenteo al server web col protocollo HTTP.

Il primo browser a caratteri si chiamava letteralmente www, inventato da Tim Berners-Lee stesso, ed era molto primitivo.

Altri notevoli browser a caratteri furono Lynx per i primi Linux, e MacWWW (Samba) per gli antichi Apple MacIntosh.

Vi è oggi una rinascita del CLI, sia per interazioni batch, p.es. comandi inseriti in procedure shell, sia con la diffusione di Docker e Kubernetes che mal supportano ambienti grafici.

Queste utility sono spesso usate nel testing e debugging di API REST basate su server web.

wget

Usato tipicamente per il download in modo batch di file rappresentati da una URL.

Spesso usato come web crawler, per lo scraping (download ricorsivo) di interi siti web.

curl

Un vero è proprio coltellino svizzero, usato non solo per interazioni HTTP, ma praticamente qualsiasi protocollo applicativo TCP/IP basato sull'interscambip di messaggi ASCII.

HTTPie

Comando: http. Numerose opzioni.

Flessibile nell'inviare ogni tipo di richiesta HTTP. Interazione molto amichevole.

Docker

Installazione di Docker

Su Hardware o su VM VirtualBox, requisiti:

- Linux Ubuntu o simile (p.es. Mint), recente, 64 bit

- 4 GB RAM

- 100+ GB HD

- Connessione a Internet

Ultima Versione dal Repository Ufficiale

Installare dal repository di docker.io.

Versione più recente, e permette la successiva estensione con plugins.

Occorre configurare la locazione del repository ed scaricare il necessario certificato. Questo si compie al meglio, preparando la seguente procedura shell, docker-repo.sh:

vim ~/docker-repo.sh

#! /bin/bash

# Add Docker's official GPG key:

sudo apt-get update

sudo apt-get install ca-certificates curl gnupg

sudo install -m 0755 -d /etc/apt/keyrings

curl -fsSL https://download.docker.com/linux/ubuntu/gpg | sudo gpg --dearmor -o /etc/apt/keyrings/docker.gpg

sudo chmod a+r /etc/apt/keyrings/docker.gpg

# Add the repository to Apt sources:

echo \

"deb [arch=$(dpkg --print-architecture) signed-by=/etc/apt/keyrings/docker.gpg] https://download.docker.com/linux/ubuntu \

$(. /etc/os-release && echo "$UBUNTU_CODENAME") stable" | \

sudo tee /etc/apt/sources.list.d/docker.list > /dev/null

sudo apt-get update

# Install the Docker packages:

sudo apt-get install docker-ce docker-ce-cli containerd.io docker-buildx-plugin docker-compose-plugin

Rendere la procedura eseguibile e lanciarla:

chmod +x ~/docker-repo.sh

cd

./docker-repo.sh

NOTA

Noi installiamo la release di Docker nel modo appena descritto, prendendola dal repository di docker.io.

Dopo l'installazione

Solo i membri del gruppo docker possono usare l'ambiente.

Configurare l’utente corrente:

sudo usermod -aG docker $USER

Reboot del sistema. In teoria un relogin è sufficiente, ma la VM Ubuntu vuole proprio un reboot

Test:

docker info

Package dal Repository di Release Linux

Alternativa al metodo precedente, In Ubuntu o simili:

sudo apt upgrade

sudo apt install docker.io

Questa versione di Docker così installata può essere non molto recente.

NOTA

Noi NON installiamo Docker dal repository di release di Linux.

Docker Compose

Docker Compose è uno strumento per l’orchestrazione di più contenitori sulla stessa macchina host

Installare Docker Compose su Ubuntu:

sudo curl -SL https://github.com/docker/compose/releases/download/v2.23.3/docker-compose-linux-x86_64 -o /usr/local/bin/docker-compose

sudo chmod +x /usr/local/bin/docker-compose

docker-compose version

Esiste anche una versione pacchettizzata di release, installabile con:

sudo apt install docker-compose

Ma è una versione relativamente vecchia, e sconsigliata.

NOTA

Noi non abbiamo bisogno di installare Docker Compose col procedimento sopra descritto. La release di Docker che abbiamo scaricato dal repository di docker.io include già un plugin per Docker Compose.

Nuova Versione di Docker Compose

Il Docker Compose originale è una utility sviluppata da un gruppo indipendente da Docker.io

- scritta in Python

- comando con trattino separatore

docker-compose comando [opzioni] [argomenti]

Docker.io ha di recente aggiunto la sua versione di Docker Compose scritta in Go e parte del comando docker

- comando senza trattino separatore

docker compose comando [opzioni] [argomenti]

- La sintassi non è cambiata

- Usano entrambi il file

docker-compose.yml

Installazione del Plugin

Docker Compose è un plugin scaricabile dal repository software di Docker.io.

Se è stata installata l'ultima versione di Docker tramite il repository della docker.io, allora il plugin Docker Compose è già installato.

Altrimenti si può scrivere la procedura shell docker-compose.sh:

#! /bin/bash

# Add Docker's official GPG key:

sudo apt-get update

sudo apt-get install ca-certificates curl gnupg

sudo install -m 0755 -d /etc/apt/keyrings

curl -fsSL https://download.docker.com/linux/ubuntu/gpg | sudo gpg --dearmor -o /etc/apt/keyrings/docker.gpg

sudo chmod a+r /etc/apt/keyrings/docker.gpg

# Add the repository to Apt sources:

echo \

"deb [arch=$(dpkg --print-architecture) signed-by=/etc/apt/keyrings/docker.gpg] https://download.docker.com/linux/ubuntu \

$(. /etc/os-release && echo "$UBUNTU_CODENAME") stable" | \

sudo tee /etc/apt/sources.list.d/docker.list > /dev/null

sudo apt-get update

# Install the Docker Compose plugin:

sudo apt install docker-compose-plugin

Renderla eseguibile e lanciarla. Questo installa il plugin.

NOTA

Noi non abbiamo bisogno di installare il plugin per Docker Compose.

Web Server Apache

Il Server Web Apache è presente come software da alcune decine di anni ed è ancora uno dei server web più usati.

Naturalmente si è evoluto nel tempo.

La versione corrente è la 2.4.x.

E' allineata con i seguenti componenti ausiliari:

- TLS (Transport Layer Security) 1.3

- OpenSSL 3.1.1

Ci sono per Linux due versioni di Apache, nella stessa release:

- versione Debian

- installata su Ubuntu, Mint, ecc.

- la struttura della configurazione è distribuita in più directory e file

- supporta più host virtuali contemporaneamente (più servers)

- versione Unix generico

- usata in docker Alpine Linux, ecc.

- la struttura della documentazione è molto più piatta

- è intesa per un solo server

Entrambe le versioni sono funzionalmente equivalenti.

Dal punto di vista amministrativo, gli stessi parametri di configurazione sono spesso in files diversi.

Moduli

Apache ha una parte core e svariati moduli opzionali, che vengono caricati nello spazio di indirizzamento del programma e aggiungono funzionalità.

Sono moduli statici, la variazione di configurazione dei moduli richiede un restart del programma.

Altri programmi modulari, p.es. il Kernel Linux, usano moduli dinamici o pluggable modules che possono essere caricati o scaricati dallo spazio di indirizzamento a runtime, senza interrompere il programma.

In generale l'intera configurazione di Apache è statica, viene letta allo start del programma. La variazione di configurazione richiede quasi sempre un restart del server Apache.

Piattaforme

Apache è disponibile per Windows, Mac, Linux ed altri sistemi operativi. Esamineremo qui il caso Libux.

Lo Apache Web Server moderno, viene in due varianti maggiori:

- versione Debian/Ubuntu - installata di default su piattaforme hardware e macchine virtuali

- disponibile per tutte le distribuzioni Linux

- completa e complessa

- installata con

apt install apache2 - gestita come servizio standard di systemctl, service o init

- versione Unix - preferita dalle immagini Docker

- ridotta a pochi componenti indispensabili

- eventualmente estendibile con pacchetti aggiuntivi

- controllata con comandi manuali,

httpdoapachectl

Vista l'importabza del mondo Docker negli applicativi distribuiti moderni, è necessario considerare entrambe le versioni.

Hanno metodi e comandi di amministrazione diversi, anche se la filosofia di base è la stessa.

Le versioni Docker possono mancare di alcuni features più complessi della versione HW/VM.

La differenza si nota nell'organizzazione della directory di configurazione.

Configurazione Debian/Ubuntu

Installata da gestione pacchetti di sistema.

Configurazione in: /etc/apache2.

Struttura:

.

├── apache2.conf

├── conf-available

│ ├── ...

│ └── serve-cgi-bin.conf

├── conf-enabled

│ ├── ...

│ └── serve-cgi-bin.conf -> ../conf-available/serve-cgi-bin.conf

├── envvars

├── magic

├── mods-available

│ ├── ...

│ └── xml2enc.load

├── mods-enabled

│ ├── ...

│ └── status.load -> ../mods-available/status.load

├── ports.conf

├── sites-available

│ ├── 000-default.conf

│ └── default-ssl.conf

└── sites-enabled

└── 000-default.conf -> ../sites-available/000-default.conf

Controllato con apache2ctl, ma restart da systemctl o altro gestore di servizi.

Gestione dei moduli con comandi di abilitazione e disabilitazione.

Configurazione Docker Alpine

Immagine: httpd:2.4-alpine.

Configurazione in: /usr/local/apache2.

Struttura:

.

|-- bin

| |-- ab

| |-- apachectl

| |-- apxs

| |-- checkgid

| |-- dbmmanage

| |-- envvars

| |-- envvars-std

| |-- fcgistarter

| |-- htcacheclean

| |-- htdbm

| |-- htdigest

| |-- htpasswd

| |-- httpd

| |-- httxt2dbm

| |-- logresolve

| |-- rotatelogs

| `-- suexec

|-- build

|-- cgi-bin

|-- conf

| |-- extra

| | |-- httpd-autoindex.conf

| | |-- httpd-dav.conf

| | |-- httpd-default.conf

| | |-- httpd-info.conf

| | |-- httpd-languages.conf

| | |-- httpd-manual.conf

| | |-- httpd-mpm.conf

| | |-- httpd-multilang-errordoc.conf

| | |-- httpd-ssl.conf

| | |-- httpd-userdir.conf

| | |-- httpd-vhosts.conf

| | `-- proxy-html.conf

| |-- httpd.conf

| |-- magic

| |-- mime.types

| `-- original

|-- error

|-- htdocs

|-- icons

|-- include

|-- logs

`-- modules

File di configurazione principale: /usr/local/apache2/conf/httpd.conf.

Si aggiungono configurazioni di virtual hosts, proxy, ecc. ponendole in: /usr/local/apache2/conf/extra.

Controllato con: apachectl.

Configurazione Docker Ubuntu

Immagine: httpd:2.4.

Più pesante dell'immagine Alpine. Mancano numerose utilities come ip, ping, vi, ecc. - ma sono installabili.

Configurazione in /usr/local/apache2.

Struttura uguale a quella di Docker Alpine.

Controllato con: apachectl.

Configurazione Manuale su Docker Alpine

Lanciare un contenitore Alpine e collegarsi:

docker run -d --name alp alpine sleep 1000000

docker exec -ti alp sh

Installare menualmente Apache di base:

apk add apache2 apache2-utils

Immagine molto leggera.

Configurazione in: /etc/apache2.

Struttura:

.

├── conf.d

│ ├── default.conf

│ ├── info.conf

│ ├── languages.conf

│ ├── mpm.conf

│ └── userdir.conf

├── httpd.conf

├── magic

└── mime.types

Si possono aggiungere pacchetti che ne estendono le funzionalità.

File di configurazione principale: /etc/apache2/httpd.conf

Si aggiungono configurazioni di virtual hosts, proxy, ecc. ponendole in: /etc/apache2/conf.d.

I moduli si gestiscono a mano commentandoli o scommentandoli nel file di configurazione principale.

Controllato con httpd, incluso i restart.

Installazione

Installazione su Linux Ubuntu o Linux Mint

Aggiornamento delle cache del software:

sudo apt update

Installazione di Apache:

sudo apt install apache2

L'installazione automaticamente abilita il servizio al prossimo reboot e lo fa partire immediatamente. Controllare lo stato del servizio con:

sudo systemctl status apache2

● apache2.service - The Apache HTTP Server

Loaded: loaded (/lib/systemd/system/apache2.service; enabled; vendor preset: enabled)

Active: active (running) since Wed 2024-03-06 14:54:49 CET; 57s ago

Docs: https://httpd.apache.org/docs/2.4/

Main PID: 2825 (apache2)

Tasks: 55 (limit: 5137)

Memory: 4.9M

CPU: 58ms

CGroup: /system.slice/apache2.service

├─2825 /usr/sbin/apache2 -k start

├─2829 /usr/sbin/apache2 -k start

└─2830 /usr/sbin/apache2 -k start

Mar 06 14:54:49 apache systemd[1]: Starting The Apache HTTP Server...

Mar 06 14:54:49 apache apachectl[2824]: AH00558: apache2: Could not reliably determine the server's>

Mar 06 14:54:49 apache systemd[1]: Started The Apache HTTP Server.

Il servizio è di stile nowait: vengono lanciati un numero di processi figli, pronti a ricevere e gestire connessioni da client.

Il numero di processi figli varia dinamicamente col numero statistico di richieste da un minimo a un massimo, entrambi configurabili.

Controllo di Apache

Controllo tramite systemd

In un Linux completo il servizio è gestito da systemd, col comando systemctl:

sudo systemctl start apache2- lancia il serviziosudo systemctl stop apache2- ferma il serviziosudo systemctl enable apache2- abilita il servizio, cioè lo lancia automaticamente al prossimo bootsudo systemctl disable apache2- disabilita il servizio, cioè NON lo lancia automaticamente al prossimo bootsudo systemctl status apache2- da un rapporto sullo stato del servizio

Controllo tramite apache2 o apache2ctl

In un sistema ove systemd è assente, il server apache si può controllare col comando apache2.

La sintassi si ottiene chiedendo aiuto:

apache2 -h

Usage: apache2 [-D name] [-d directory] [-f file]

[-C "directive"] [-c "directive"]

[-k start|restart|graceful|graceful-stop|stop]

[-v] [-V] [-h] [-l] [-L] [-t] [-T] [-S] [-X]

Si può usare questo comando per avere la versione di Apache:

apache2 -v

Server version: Apache/2.4.52 (Ubuntu)

Server built: 2023-10-26T13:44:44

Esiste anche il comando apache2ctl, che ha le stesse funzionalità di controllo di apache2.

Il comando apache2ctl, a differenza di apache2, legge le variabili d'ambiente di Apache. In molti casi è da preferirsi.

Verifichiamo l'accessibilità della pagina principale del sito, aprendo un browser a localhost.

La pagina è complessa e informativa.

Installazione su Docker Alpine Linux

Lanciamo un contenitore Alpine:

docker run -d --name alp -p 8888:80 alpine sleep 1000000

Mappiamo la porta 80 del contenitore alla porta 8888 dello host per evitare collisioni con l'installazione precedente di Apache sullo host.

Colleghiamoci al contenitore:

docker exec -ti alp sh

Installiamo Apache:

apk add apache2 apache2-utils

Il comando di controllo è httpd, con la stessa sintassi di apache2 sulla versione Ubuntu.

Questo comando di controllo è indispensabile, poichè il contenitore Alpine non ha systemd.

Lanciamo Apache:

httpd -k start

Da un warning sistemabile in seguito con la variazione di configurazione. Anche la versione Ubuntu da lo stesso warning, ma non è comparso a video, bensi inserito in un log appropriato.

Controlliamo la partenza:

ps wax

PID USER TIME COMMAND

1 root 0:00 sleep 1000000

22 root 0:00 httpd -k start

23 apache 0:00 httpd -k start

24 apache 0:00 httpd -k start

25 apache 0:00 httpd -k start

26 apache 0:00 httpd -k start

27 apache 0:00 httpd -k start

29 apache 0:00 httpd -k start

50 root 0:00 sh

55 root 0:00 ps wax

Controlliamo la versione:

httpd -v

Server version: Apache/2.4.58 (Unix)

Server built: Nov 24 2023 15:41:14

Accediamo alla pagina principale con curl:

apk add curl

curl localhost

<html><body><h1>It works!</h1></body></html>

E' molto più semplificata.

Usciamo dal contenitore:

exit

Possiamo accedere dallo host alla pagina web principale offerta dal contenitore Alpine, aprendo un browser alla URL localhost:8888, oppure col comando:

curl localhost:8888

Configurazione Principale

Configurazione della Versione Debian/Ubuntu

La directory di configurazione è /etc/apache2.

La struttura di configurazione è:

/etc/apache2/

├── apache2.conf

├── conf-available

│ └── *.conf

├── conf-enabled

│ └── serve-cgi-bin.conf -> ../conf-available/*.conf

├── envvars

├── magic

├── mods-available

│ └── *.load

├── mods-enabled

│ ├── *.conf -> ../mods-available/*.conf

│ └── *.load -> ../mods-available/*.load

├── ports.conf

├── sites-available

│ └── *.conf

└── sites-enabled

└── *.conf -> ../sites-available/*.conf

Elementi di Configurazione

File Principale

Il file di configurazione principale è /etc/apache2/apache2.conf.

vim /etc/apache2/apache2.conf

Originariamente questo file di configurazione era molto lungo, ora è stato accorciato e segmenti di configurazione si trovano in sottodirectories di /etc/apache2.

envvars

Prima di leggere il file di configurazione principale, Apache crea delle variabili d'ambiente dal file /etc/apache2/envvars.

vim /etc/apache2/envvars

Non è necessario editare quest'ultimo file a meno di configurazioni diverse dal default.

magic

Contiene l'associazione tra i tipi MIME e i magic numbers di Unix.

Un magic number è l'etichetta composta da alcuni bytes che si trova all'inizio di un file e che ne dichiara il tipo. Unix non usa estensioni del nome, ma magic numbers.

Il tipo MIME (Multimedia Internet Mail Extensions) è il metodo standard Internet per dichiarare un tipo di file.

ports

La specifica delle porte usate dal server.

mods

Lista di tutti i moduli di Apache:

mods-available/*.load- moduli disponibilimods-enabled/*.load- moduli abilitati, comando di caricamento del modulomods-enabled/*.conf- eventuale configurazione di un modulo abilitato

In mods-enabled i files sono dei link simbolici ai corrispondenti files di mods-available.

sites

Siti virtuali configurati:

sites-available/*.conf- configurazione di un sito virtuale disponibilesites-enabled/*.conf- configurazione di un sito virtuale abilitato

In sites-enabled i files sono dei link simbolici ai corrispondenti files di sites-available.

Inizialmente vi sono due configurazioni disponibili:

000-default.conf- sito di base HTTP senza SSLdefault-ssl.conf- configurazione di un sito HTTPS con SSL

Solo il sito di base HTTP è abilitato. HTTPS richiede la fornitura di un certificato.

conf

Segmenti di configurazione.

conf-available/*.conf- configurazioni che estendono la capacità del server di baseconf-enabled/*.conf- configurazioni abilitate

In conf-enabled i files sono dei link simbolici ai corrispondenti files di conf-available.

Tutte le configurazioni extra disponibili sono abilitate.

Configurazione della Versione Unix/Alpine

Una struttura di configurazione molto più semplice:

/etc/apache2

├── conf.d

│ ├── default.conf

│ ├── info.conf

│ ├── languages.conf

│ ├── mpm.conf

│ └── userdir.conf

├── httpd.conf

├── magic

└── mime.types

Elementi

magic della versione Unix

Associa i tipi MIME ai magic numbers standard di Unix.

mime.types

Associa i tipi MIME alle estensioni dei nomi dei file. Questa versione può essere usata anche su sistemi operativi, come Windows, che non usano magic numbers.

File Principale della versione Unix

E' httpd.conf e contiene molte più informazioni qui aggregate che non il corrispondente file principale dalla versione Ubuntu.

Per esempio qui vi è la lista dei moduli.

conf.d

Directory con un numero limitato di file di configurazione di estensioni, che vengono inclusi in httpd.conf:

default.conf- parametri globali del serverinfo.conf- parametri per il route alias/statuslanguages.conf- supporto a lingue oltre l'americano e set di caratteri oltre ASCIImpm.conf- gestione del pool dei servers, o del numero di processi figli generatiuserdir.conf- settaggi che consentono a sottodirectories di utenti di essere pubblicate dal server web oltre alla DocumentRoot principale

Note

La configurazione della versione Unix/Alpine di Apache è di più semplice comprensione, più tradizionale, e più adattabile a sistemi operativi diversi.

Parametri di Configurazione di Base

Sono qui descritti solo alcuni parametri, i più importanti. I files di configurazione sono peraltro ben commentati, e leggendoli si può comprendere il significato di tutti i parametri.

Questa esposizione segue la struttura della versione Unix. L'equivalente versione Debian mantiene i parametri in altri files. Per scoprire la loro esatta locazione si può compiere una ricerca con grep, per esempio:

cd /etc/apache2

grep -r ServerRoot .

File httpd.conf:

ServerRoot /var/www- directory di base di tutti i files gestiti, p.es. anche i logsDocumentRoot "/var/www/localhost/htdocs"- directory di base per le pagine staticheListen 80- ascolta sulla porta 80ServerName www.example.com:80- nome ufficiale del server. Se manca, viene preso allo start l'indirizzo IP del server, e prodotto un warningServerAdmin you@example.com- posta elettronica dell'amministratoreServerSignature On- aggiunge nel responso uno header con la versione del server e nome del virtual host. Possibilità:On | Off | EMail. ConEMailaggiunge anche unmailto:all'amministratoreServerTokens OS- quantità di Headers di identificazione da usare. Possibilità:Full | OS | Minor | Minimal | Major | Prod.OS: solo concernenti il sistema operativo.

File conf.d/default.conf:

Timeout 60- per il completamento di una richiesta, in secondiKeepAlive On- se i client possono inviare più richieste nella stessa sessioneMaxKeepAliveRequests 100- numero massimo di richieste per sessioneKeepAliveTimeout 5- intervallo in secondi tra richieste successive nella stessa sessioneUseCanonicalName Off- se identificarsi con il Fully Qualified Domain Name (FQDN) del DNS [On] o con ilServerName[Off]HostnameLookups Off- se risolvere a DNS l'indirizzo IP dei client delle richiesteAccessFileName .htaccess- nome del file di override dei permessi di accesso per la directory corrente

User Directory

Una piattaforma Unix tradizionalmente configura parecchi utenti che vi possono compiere login.

Questo da la possibilità che tali utenti pubblichino le proprie pagine web, sotto la propria directory $HOME/public_html.

Se il nome del server è www.example.com e il nome dell'utente è paperino, la URL per accedere alle pagine web di quell'utente è www.sample.com/~paperino. Questo da il suo file index.html.

Non serve a niente se il server web è in un contenitore Docker.

Configurata nel file conf.d/userdir.conf:

<IfModule userdir_module>

UserDir public_html

<Directory "/home/*/public_html">

AllowOverride FileInfo AuthConfig Limit Indexes

Options MultiViews Indexes SymLinksIfOwnerMatch IncludesNoExec

Require method GET POST OPTIONS

</Directory>

</IfModule>

Lingue ed Encoding

Lingue

Si può cambiare la lingua in cui una pagina HTML è scritta con il tag principale:

<html lang="it">

o in uno span:

<p> French " <span lang="fr"> Bonjour </span> " </p>

o anche tramite uso opportuno di codice JavaScript.

Apache permette di ospitare varianti di un documento in più lingue, aggiungendo un suffisso, p.es. summary.html.fr, summary.html.it, ...

Se non vi è tale suffisso vale la lingua di default.

La selezione della lingua è spesso offerta da una voce di menù del browser. Viene compiuta una negoziazione con opportuni header nella richiesta e nel responso.

Il file conf.d/languages.conf descrive le lingue accettabili al server.

Encoding

Una simile negoziazione avviene per lo encoding ovvero il metodo usato per rappresentare caratteri visivi in sequenze di byte.

I caratteri visivi venivano anche chiamati glifi (glyphs). Lo standard moderno Linux usa lo encoding UTF-8 con numero variabile di bytes. Con vocabolo preso dal Linguaggio Go, il carattere visivo o glifo si chiama runa, ed è diverso dal byte o bytes che lo rappresentano.

L'antico ASCII usa 7 bit per carattere. Le codifiche ISO-8859-x usano 8 bit per carattere; i codici 129-255 sono variabili e permettono in alternativa di rappresentare rune in cirillico, greco, ecc.

Lo standard cinese, introdotto dalla IBM, si chiama Big 5. Il Giappone ha una serie di standard JIS (Japanese Industry Standard). Unicode prometteva di uniformare la situazione ma ha infatti introdotto molte varianti.

Il server Apache supporta molti encodings, i browser solitamente permettono di selezionare quello visualizzato.

Una pagina HTML dichiara lo encoding nella testata, per esempio:

<!DOCTYPE html>

<html lang="en">

<head>

<meta charset="utf-8">

...

oppure

<!DOCTYPE html>

<html lang="en">

<head>

<meta http-equiv="Content-Type"

content="text/html; charset=utf-8">

...

Multi Process Management

Apache usa il metodo no wait di gestione del servizio. Le richieste non sono gestite direttamente dal processo principale, che solo riceve le richieste sul listen port 80.

All'arrivo di una richiesta il server principale la passa ad un processo figlio, nello stesso Cgroup, che apre una porta effimera e prosegue la connessione col client.

La gestione dei processi figli si chiama Multi Process Management (MPM), ed è congigurata nel file conf.d/mpm.conf.

Vi sono più tipi di MPM:

- prefork MPM

- worker MPM

- event MPM

- NetWare MPM

- OS/2 MPM

- WinNT MPM

Il funzionamento dei vari MPM dipende dalle strutture architettoniche del kernel del sistema operativo ospitante.

Quale MPM sia selezionato dipende dall'abilitazione di un modulo anzichè un altro.

Apache su Linux usa prefork MPM nella versione Unix e event MPM nella versione Debian.

Il segmento di controllo di prefork MPM è:

<IfModule mpm_prefork_module>

StartServers 5

MinSpareServers 5

MaxSpareServers 10

MaxRequestWorkers 250

MaxConnectionsPerChild 0

</IfModule>

StartServers- processi inizialiMinSpareServers- numero minimo dei processiMaxSpareServers- numero massimo dei processiMaxRequestWorkers- numero massimo di richieste per processoMaxConnectionsPerChild- numero massimo di connessioni per processo [0: terminare la connessione e il processo dopo il servizio al client]

Moduli

Lista dei moduli

Versione Debian:

apache2ctl -M

Versione Unix:

httpd -M

La lista da i moduli correntemente caricati nello spazio di indirizzamento del programma.

Vi sono tre tipi di moduli:

- Static - linkati staticamente nel programma principale

- Shared - librerie condivise (shared objects) linkati allo start del programma

- Dynamic - che permettono il caricamento a runtime. Apache non usa questo tipo di moduli.

Abilitazione e Disabilitazione Moduli

Versione Debian

Abilitare un modulo, esempio:

sudo a2enmod rewrite

Disabilitare un modulo, esempio:

sudo a2dismod status

I comandi rispettivamente aggiungono o tolgono un link simbolico nella sottodirectory mods-enabled alla sottodirectory mods-available.

Basta, p.es., rewrite e non mod_rewrite.

Occorre restartare il servizio:

sudo systemctl restart apache2

Versione Unix

Editare il file di configurazione principale:

vi /etc/apache2/httpd.conf

Non c'è sudo nel contenitore alpine. Siamo già root.

Trovare nel file il modulo desiderato.

Togliere o porre il cancelletto (#) a inizio riga per abilitare o disabilitare il modulo.

Restartare Apache:

httpd -k restart

Installazione Moduli

In versione Debian

Debian/Ubuntu possiede un numero elevato di moduli Apache aggiuntivi, nella distribuzione di release.

Per listarli:

sudo apt update

sudo apt search libapache2-mod-

Possono poi venir installati col normale comando sudo apt install ....

In Versione Alpine/Docker

Alpine possiede un numero più limitato di moduli di Apache, sviluppati e contribuiti da terzi.

Listare i moduli disponibili:

apk update

apk search apache | grep mod

Vengono poi installati col comando di installazione pacchetti di Alpine: apk add ....

A volte un ente contribuisce un suo modulo e lo rende disponibile nel suo repository come package. Per averlo dobbiamo aggiungere il repository e la chiave pubblica alla configurazione.

Per esempio:

wget -q https://apk.signalsciences.net/sigsci_apk.pub ; mv sigsci_apk.pub /etc/apk/keys/

echo https://apk.signalsciences.net/3.19/main | tee -a /etc/apk/repositories && apk update

Configurazione Condizionale

La presenza o meno di moduli determina se venga attivato o meno un parametro di configurazione, che ha un modulo come prerequisito, o venga caricato un modulo dipendente.

Per esempio, caricamento di un modulo dipendente:

<IfModule !mpm_prefork_module>

LoadModule cgid_module modules/mod_cgid.so

</IfModule>

<IfModule mpm_prefork_module>

LoadModule cgi_module modules/mod_cgi.so

</IfModule>

Esempio di configurazioni dipendenti:

<IfModule unixd_module>

User apache

Group apache

</IfModule>

Quest'ultimo serve per lanciare Apache coi permessi di un utente e di un gruppo particolari, invece di root.

Altro esempio:

<IfModule dir_module>

DirectoryIndex index.html

</IfModule>

Quando il Path è una directory, viene mostrato questo file in essa contenuta.

Altro esempio:

<IfModule alias_module>

# Redirect permanent /foo http://www.example.com/bar

# Alias /webpath /full/filesystem/path

ScriptAlias /cgi-bin/ "/var/www/localhost/cgi-bin/"

</IfModule>

Directories, Files e Locazioni

Accesso a Directories

Ogni directory coinvolta nelle operazioni del server deve avere uno schema di permessi di accesso.

Lo schema di accesso della directory principale, per esempio, è:

<Directory />

AllowOverride none

Require all denied

</Directory>

Dalla directory radice in giù:

Require all denied- a tutti è negato l'accessoAllowOverride none- non sono consentite deroghe

Lo schema di accesso alla directory è:

<Directory "/var/www/localhost/htdocs">

Options Indexes FollowSymLinks

AllowOverride None

Require all granted

</Directory>

ove:

Require all granted- a tutti è permesso l'accessoOptions Indexes FollowSymLinks- gli indici di directory sono abilitati, e i link simbolici vengono seguitiAllowOverride none- non sono consentite deroghe

Una directory più specifica vince su una directory più generica. I parametri di /var/www/localhost/htdocs vincono su quelli di /.

Lo schema di accesso alla directory ove vengono posti programmi invocabili con il Common Gateway Interface è:

<Directory "/var/www/localhost/cgi-bin">

AllowOverride None

Options None

Require all granted

</Directory>

Override

Singole directories possono contenere configurazioni di accesso specifiche, in estensione o sostituzione (Override) di quelle del file principale di configurazione. Il file principale deve però permetterlo, e dichiarare quali overrides sono concessi.

Tali overrides sono nel file .htaccess della directory configurata.

AllowOverride può contenere uno o più dei seguenti argomenti separati da spazio:

AuthConfig- configurazioni di autenticazioneFileInfo- informazioni sui fileIndexes- indici: ilGETdi una directory ritorna l'indice della directoryLimit- lista di metodi HTTP consentiti nella directoryOptions=opzioni- lista delle opzioni, separate da virgolaall- tuttonone- niente

Options

Le opzioni possibili sono:

Indexes- indici della directoryFollowSymLinks- seguire tutti i link simbolici (default in assenza di altri)SymLinksIfOwnerMatch- seguire un link solo se dello stesso utente del file riferitoIncludes- usare i Server Side Includes (SSI). Richiede il modulomod_includeIncludesNOEXEC- usare gli SSI eccettoexecExecCGI- eseguire programmi configurati col Common Gateway Interface (CGI). Richiede il modulomod_cgiMultiViews- negoziazione di contenuto. Richiede il modulomod_negotiationsAll- tutte le opzioni tranneMultiViews

Require

Direttiva che implementa le autorizzazioni di accesso ad una risorsa. Richiede i moduli mod_authz_core e mod_authz_host.

La sintassi è flessibile. Alcuni esempi sono:

Require all granted- permesso a tuttiRequire all denied- negato a tuttiRequire valid-user- permesso ad utenti che si sono autenticati con uno schema di accesso, definito precedentemente in configurazioneRequire host starshell.sh- qualsiasi compclientuter appartenente al dominioRequire not host gov- clients non appartenenti al dominioRequire ip 192.168.27- clients con indirizzo IP in una certa retaRequire not ip 192.168.27.11- clients non col determinati indirizzo IPRequire expr %{HTTP_USER_AGENT} != 'BadBot'- espressione che testa un campo header della richiesta

Limitazioni di accesso basate sugli header, indirizzi IP o nomi di dominio non sono sicure. La richiesta può essere contraffatta. L'intero pacchetto IP e payload può essere un forgery, costruito con tecniche e strumenti di packet crafting.

Apache possiede una ricca sintassi di espressioni, con variabili, operatori, costrutti di controllo.

Accesso a Files

Oltre che schemi di accesso per directories, vi sono quelli per protezione di files.

Per esempio:

<Files ".ht*">

Require all denied

</Files>

Impediscono che i file .htaccess e .htpasswd vengano visti dagli utenti.

Questi sono files usati nel limitare l'accesso a directories solo a utenti che si devono autenticare con username e password.

Il file .htaccess è posto nella directory che si protegge e contiene un override di settaggi di configurazione.

Il file .htpasswd può essere posto nella stessa directory, e contiene nomi utenti e le corrispondenti password in formato hash.

Di solito si preferisce porlo fuori da DocumentRoot, in tal modo proteggendolo da accessi automaticamente.

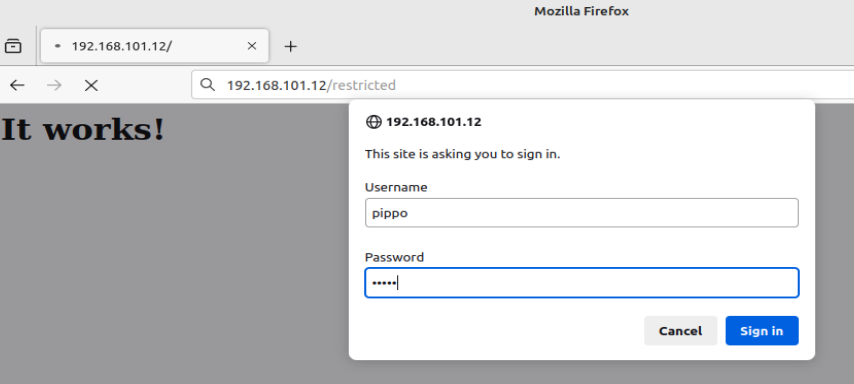

Accesso Autenticato

Directory ad Accesso Limitato

Questo esempio segue i nomi files della versione Unix di Apache, ma per la versione Debian è completamente equivalente.

Nella DocumentRoot creare una directory restricted e una pagina HTML di prova:

cd /var/www/localhost/htdocs

mkdir restricted

cd restricted

vi index.html

<html>

<head>

<title>Club Privato</title>

</head>

<body bgcolor="white">

<h1>Ciao</h1>

</body>

</html>

Autenticazione Basic

Scrivere il file di limitazione accessi nella directory riservata:

vi .htaccess

AuthType Basic

AuthName "Restricted Access"

AuthUserFile /etc/apache2/users

<Limit GET>

require valid-user

</Limit>

Modificare i permessi del file di configurazione globale /etc/apache2/httpd.conf

Nella sezione di protezione della directory corrispondente al DocumentRoot, da:

AllowOverride None

a

AllowOverride AuthConfig Limit

Generare il file dei permessi:

cd /etc/apache2

htpasswd -mc users pippo

Password:pluto

Repeat password:pluto

Restartare il server:

httpd -k restart

Analisi del Traffico

Chiudere il browser poi riaprirlo, poichè usa delle cache.

Installare l'utility tcpdump su Alpine:

apk add tcpdump

Aprire la cattura di traffico con dump ASCII con:

tcpdump -A

Aprire il browser e connettersi a localhost:8888/restricted, dando l'utente pippo e la password pluto.

Controllare il traffico catturato da tcpdump. Troveremo:

GET /restricted/ HTTP/1.1

Host: 192.168.101.12

User-Agent: Mozilla/5.0 (X11; Linux x86_64; rv:121.0) Gecko/20100101 Firefox/121.0

Accept: text/html,application/xhtml+xml,application/xml;q=0.9,image/avif,image/webp,*/*;q=0.8

Accept-Language: en-US,en;q=0.5

Accept-Encoding: gzip, deflate

Connection: keep-alive

Upgrade-Insecure-Requests: 1

If-Modified-Since: Sat, 02 Mar 2024 20:13:15 GMT

If-None-Match: "70-612b31f6ae088"

Authorization: Basic cGlwcG86cGx1dG8=

La coppia nome:password viene inviata nella testata della richiesta http come stringa non crittografata, ma solo trasformata con l'algoritmo Base64.

Uno sniffer può intercettare la richiesta http e uno hacker la può decodificare, p.es.:

echo "cGlwcG86cGx1dG8K=" | base64 -d

pippo:pluto

Autenticazione Digest

E' un metodo challenge-response.

Non occorre inviare la password, basta dimostrare di saperla.

Scrivere il file di limitazione accessi nella directory riservata:

cd /var/www/localhost/htdocs/restricted

vi .htaccess

AuthType Digest

AuthName "club"

AuthDigestDomain /restricted/ http://localhost/restricted/

AuthDigestProvider file

AuthUserFile /etc/apache2/secure

<Limit GET>

require valid-user

</Limit>

Generare il file dei permessi:

cd /etc/apache2

htdigest -c secure club tizio

Adding password for user tizio in realm club.

New password:caio

Repeat password:caio

Nel file /etc/apache2/httpd.conf:

Togliere il commento alla linea

LoadModule auth_digest_module modules/mod_auth_digest.so

Restart del server corrente:

httpd -k restart

La cattura traffico è completamente differente:

GET /restricted/ HTTP/1.1

Host: 192.168.101.12

User-Agent: Mozilla/5.0 (X11; Linux x86_64; rv:121.0) Gecko/20100101 Firefox/121.0

Accept: text/html,application/xhtml+xml,application/xml;q=0.9,image/avif,image/webp,*/*;q=0.8

Accept-Language: en-US,en;q=0.5

Accept-Encoding: gzip, deflate

Connection: keep-alive

Upgrade-Insecure-Requests: 1

Authorization: Digest username="tizio", realm="club", nonce="FBRN4bMSBgA=d74359083de5b800e832d25773dcbc555768d016", uri="/restricted/", algorithm=MD5, response="3a4fce5ee9163dd376b803e9cb4f8bbe", qop=auth, nc=00000001, cnonce="0e32602512c548ec"

La password non compare, nemmeno trascodificata.

Se vi sono errori, verificare il file di log /var/www/logs/error.log.

Errori e MIME

Errori

Log degli Errori

File e Livello di Logging

Parametri:

ErrorLog logs/error.log- file di log, sottoServerRootLogLevel warn- sono loggati gli errori uguali o superiori a questo livello di severità- possibilità, in ordine crescente di severità:

debug, info, notice, warn, error, crit, alert, emerg

- possibilità, in ordine crescente di severità:

Formato dei Log

Ogni evento di log è una singola linea. Quali siano gli elementi su tale linea dipende dal formato del log.

Sono definiti tre formati:

common- tradizionale, più cortocombined- con più informazionicombinedio- con anche informazioni di input e output

<IfModule log_config_module>

LogFormat "%h %l %u %t \"%r\" %>s %b \"%{Referer}i\" \"%{User-Agent}i\"" combined

LogFormat "%h %l %u %t \"%r\" %>s %b" common

<IfModule logio_module>

LogFormat "%h %l %u %t \"%r\" %>s %b \"%{Referer}i\" \"%{User-Agent}i\" %I %O" combinedio

</IfModule>

#CustomLog logs/access.log common

CustomLog logs/access.log combined

</IfModule>

Gli elementi del log sono rappresentati da segnalini

| Segnalino | Elemento |

|---|---|

| %h | indirizzo IP del client |

| %l | un trattino (-) |

| %u | nome utente, o trattino se manca |

| %t | timestamp |

| %r | richiesta |

| %>s | stato del responso |

| %b | dimensione dell'oggetto ritornato |

| %I | bytes ricevuti |

| %O | bytes inviati |

| %{Referer}i | referer - indirizzo da cui la richiesta è provenuta tramite un link |

| %{User-Agent}i | informazioni sul browser |

Esempio di linea log combinedio:

81.95.52.96 - - [12/Oct/2012:11:25:58 +0100] "GET /docs HTTP/1.1" 200 3623

"http://webarch.net/docs/hosting-logs" "Mozilla/5.0 (X11; Linux i686; rv:15.0)

Gecko/20100101 Firefox/15.0.1" 1224 6793

Errori Customizzabili

Esempi:

ErrorDocument 500 "The server made a boo boo."- testo direttoErrorDocument 404 /missing.html- pagina statica localeErrorDocument 404 "/cgi-bin/missing_handler.pl"- programma CGI di gestioneErrorDocument 402 http://www.example.com/subscription_info.html- pagina remota

Gestione MIME

Il Multimedia Internet Message Extensions identifica files non US ASCII.

Ognuno di tali files ha una possibile codifica, handler di gestione, filtro di output.

Il seguente è un estratto del segmento di configurazione:

<IfModule mime_module>

TypesConfig /etc/apache2/mime.types

#AddEncoding x-compress .Z

#AddEncoding x-gzip .gz .tgz

AddType application/x-compress .Z

AddType application/x-gzip .gz .tgz

#AddHandler cgi-script .cgi

#AddHandler type-map var

#AddType text/html .shtml

#AddOutputFilter INCLUDES .shtml

</IfModule>

Ove:

TypesConfig /etc/apache2/mime.types- file di definizione dei tipi MIME#AddEncoding x-compress .Z- aggiunta di una codificaAddType application/x-compress .Z- aggiunta del tipo MIME corrispondente alla codificaAddType application/x-gzip .gz .tgz- aggiunta di un tipo MIME#AddHandler cgi-script .cgi- aggiunta di uno handler: tutti i files con estensione.cgi, nella directory appropriata definita altrove, sono programmi con interfaccia CGI#AddHandler type-map var- aggiunta di una mappa (opzione negoziabile)#AddType text/html .shtml- l'estensione.shtmlidentifica un file HTML#AddOutputFilter INCLUDES .shtml- l'estensione.shtmlinvoca il filtro Server Side Includes

Host Virtuali

Versione Debian e Ubuntu

Struttura di Directories

Creazione delle directory:

sudo mkdir -p /var/www/your_domain_1/public_html

sudo mkdir -p /var/www/your_domain_2/public_html

Permessi alle directory create:

sudo chown -R $USER:$USER /var/www/your_domain_1/public_html

sudo chown -R $USER:$USER /var/www/your_domain_2/public_html

sudo chmod -R 755 /var/www

Pagine di Default

Creazione di pagine di default per i due siti:

vim /var/www/your_domain_1/public_html/index.html

<html>

<head>

<title>Welcome to your_domain_1!</title>

</head>

<body>

<h1>Success! The your_domain_1 virtual host is working!</h1>

</body>

</html>

vim /var/www/your_domain_2/public_html/index.html

<html>

<head>

<title>Welcome to your_domain_2!</title>

</head>

<body> <h1>Success! The your_domain_2 virtual host is working!</h1>

</body>

</html>

Configurazione degli Host Virtuali

Primo Virtual Server

Copiare il file di configurazione di default:

sudo cp /etc/apache2/sites-available/000-default.conf \

/etc/apache2/sites-available/your_domain_1.conf

Modificare il nuovo file:

sudo vim /etc/apache2/sites-available/your_domain_1.conf

Modificare le direttive esistenti:

<VirtualHost *:80>

...

ServerAdmin webmaster@localhost

DocumentRoot /var/www/html

...

ErrorLog ${APACHE_LOG_DIR}/error.log

CustomLog ${APACHE_LOG_DIR}/access.log combined

</VirtualHost>

Aggiungere le direttive ServerName, ServerAlias e DocumentRoot:

<VirtualHost *:80>

...

ServerAdmin admin@your_domain_1

ServerName your_domain_1

ServerAlias www.your_domain_1

DocumentRoot /var/www/your_domain_1/public_html

...

ErrorLog ${APACHE_LOG_DIR}/error.log

CustomLog ${APACHE_LOG_DIR}/access.log combined

...

</VirtualHost>

Secondo Virual Server

Copiare il file di configurazione di del primo server virtuale:

sudo cp /etc/apache2/sites-available/your_domain_1.conf \

/etc/apache2/sites-available/your_domain_2.conf

Editare il file generato in modo equivalente a quello del primo sito:

sudo vim /etc/apache2/sites-available/your_domain_2.conf

<VirtualHost *:80>

...

ServerAdmin admin@your_domain_2

ServerName your_domain_2

ServerAlias www.your_domain_2

DocumentRoot /var/www/your_domain_2/public_html

...

ErrorLog ${APACHE_LOG_DIR}/error.log

CustomLog ${APACHE_LOG_DIR}/access.log combined

...

</VirtualHost>

Abilitazione degli Host Viruali

sudo a2ensite your_domain_1.conf

sudo a2ensite your_domain_2.conf

Disabilitazione del server di default:

sudo a2dissite 000-default.conf

Test della configurazione:

sudo apache2ctl configtest

Modifica di /etc/hosts

Per la risoluzione nomi indirizzi, aggiungere i nomi dei nostri domini:

sudo vim /etc/hosts

127.0.0.1 localhost

127.0.2.1 your_domain_1

127.0.2.2 your_domain_2

Restart del Server

sudo systemctl restart apache2

Test

Con un browser o con curl, accedere a http://your_domain_1 e http://your_domain_2

Pulizia

Al termine rimettere a posto la configurazione iniziale:

sudo a2ensite 000-default.conf

sudo a2dissite your_domain_1.conf

sudo a2dissite your_domain_2.conf

sudo systemctl restart apache2

Versione Unix in Docker Alpine

Lanciare un contenitore Alpine e collegarsi:

docker run -d --name alp --privileged -p 8888:80 alpine sleep 1000000

docker exec -ti alp sh

Installare Apache:

apk add apache2

apk add curl

Non è necessaria l'abilitazione di alcun modulo.

Il file di configurazione principale, /etc/apache2/httpd.conf, include tutti i file *.conf dalla sottodirectory conf.d.

Andiamo in questa sottodirectory:

cd /etc/apache2/conf.d

Prepariamo due file di configurazione di due host virtuali che chiamiamo domain1 e domain2.

Il primo:

vi domain1.conf

<VirtualHost domain1:80>

ServerAdmin webmaster@domain1.com

DocumentRoot "/var/www/localhost/domain1/htdocs"

<Directory "/var/www/localhost/domain1/htdocs">

Options Indexes FollowSymLinks

AllowOverride None

Require all granted

</Directory>

ServerName domain1.com

ServerAlias domain1.com

ErrorLog "logs/domain1-error_log"

CustomLog "logs/domain1-access_log" common

</VirtualHost>

Il secondo:

vi domain2.conf

<VirtualHost domain2:80>

ServerAdmin webmaster@domain2.com

DocumentRoot "/var/www/localhost/domain2/htdocs"

<Directory "/var/www/localhost/domain2/htdocs">

Options Indexes FollowSymLinks

AllowOverride None

Require all granted

</Directory>

ServerName domain2.com

ServerAlias domain2.com

ErrorLog "logs/domain2-error_log"

CustomLog "logs/domain2-access_log" common

</VirtualHost>

Ciascuno ha i propri identificativi, e una sua directory DocumentRoot, con accesso regolato dalla direttiva <Directory>.

I log sono nella directory comune dei log di Apache.

Creiamo le directory DocumentRoot:

mkdir -p /var/www/localhost/domain1/htdocs

mkdir -p /var/www/localhost/domain2/htdocs

Creiamo dei files index.html in ciascuna di queste directory:

vi /var/www/localhost/domain1/htdocs/index.html

<h1>Hello from domain 1</h1>

vi /var/www/localhost/domain2/htdocs/index.html

<h1>Hello from domain 2</h1>

Occorre che i nomi dei domini siano risolti. Modifichiamo /etc/hosts:

vi /etc/hosts

Inserendo le linee:

127.0.1.1 domain1

127.0.1.2 domain2

Start del server:

httpd -k start

Test di raggiungibilità dall'interno:

curl domain1

curl domain2

Raggiungibilità dall'Esterno

Configurazione Interna

Scopriamo l'indirizzo IP del contenitore:

ip a | grep eth0 | grep inet

inet 172.17.0.2/16 brd 172.17.255.255 scope global eth0

Aggiungiamo altri due indirizzi:

ip addr add 10.0.0.1 dev eth0

ip addr add 10.0.0.2 dev eth0

Modifichiamo /etc/hosts sostituendo le linee di configurazione:

10.0.0.1 domain1

10.0.0.2 domain2

Configurazione Esterna

Apriamo un'altra finestra di terminale sulla macchina host.

Aggiungiamo la risoluzione di domain1 e domain2 al file /etc/hosts:

sudo vim /etc/hosts

10.0.0.1 domain1

10.0.0.2 domain2

Modifichiamo il routing:

sudo ip route add 10.0.0.0/8 via 172.17.0.2

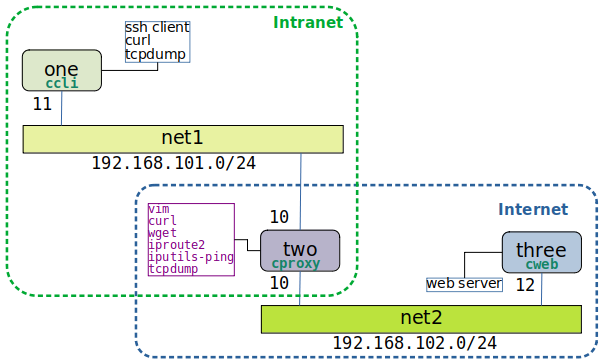

Forward Proxy

Proprietà di un Forward Proxy

Gestisce le richieste cliente di accedere a risorse in internet. E' posizionato tra i client e l'internet, e inoltra le richieste a server esterni.

Il server di destinazione vede arrivare la richiesta dal forward proxy e non sa del vero client che l'ha originata.

Può includere filtraggio di contenuto, controlli di accesso e anonimizzazione delle richieste, nascondendo l'indirizzo IP del client.

Posizionato al confine della rete intranet del client.

Esercizio con Versione Debian e Ubuntu

Creare la directory di esercizio:

mkdir 01net2-ccli-cproxy-cweb

cd 01net2-ccli-cproxy-cweb

NOTA

L'esercizio è scaricabile come file tar 01net2-ccli-cproxy-cweb.tar

Preparazione dello scaffolding:

mkdir ccli cproxy cweb

touch ccli/Dockerfile cproxy/Dockerfile docker-compose.yml

tree

.

├── ccli

│ └── Dockerfile

├── cproxy

│ └── Dockerfile

├── cweb

└── docker-compose.yml

Client

Il client ccli è un'immagine Alpine abbastanza semplice.

vim ccli/Dockerfile

FROM alpine:3.7

MAINTAINER John Smith <john@stormforce.ac>

RUN apk --update add --no-cache openssh tcpdump curl

CMD ["/bin/sleep","1000000"]

Proxy

Il proxy cproxy è un'immagine Ubuntu con la versione Debian/Ubuntu di Apache installata, più qualche altra utility.

vim cproxy/Dockerfile

FROM ubuntu

RUN apt update

RUN apt install -y apache2

RUN apt install -y vim curl wget iproute2 iputils-ping tcpdump

EXPOSE 80 443

CMD ["/bin/sleep","1000000"]

L'immagine Ubuntu di base è così scarna che non ha il comando ping e nemmeno il comando ip. Così, a scopo di debugging, vengono aggiunti i pacchetti iproute2, iputils-ping e tcpdump.

La configurazione del proxy viene mappata in un volume esterno, per la persistenza dei dati.

E' necessario creare a mano tale volume:

docker volume create conf

Web Server

Il web server cweb è un'immagine Alpine con la versione Unix di Apache, disponibile su Docker Hub.

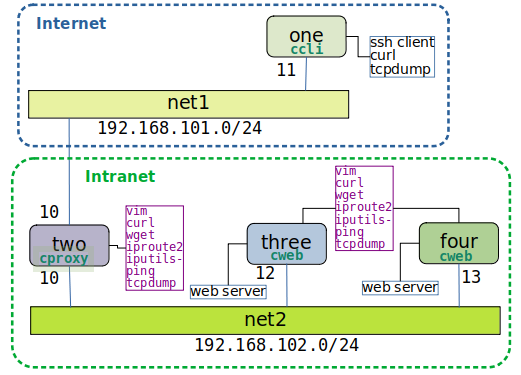

docker-compose.yml

Il docker-compose.yml è:

vim docker-compose.yml

version: '3.6'

services:

one:

build: ccli

image: ccli

container_name: one

hostname: one

cap_add:

- ALL

networks:

net1:

ipv4_address: 192.168.101.11

two:

build: cproxy

image: cproxy

container_name: two

hostname: two

cap_add:

- ALL

volumes:

- conf:/etc/apache2

networks:

net1:

ipv4_address: 192.168.101.10

net2:

ipv4_address: 192.168.102.10

three:

image: httpd:2.4-alpine

container_name: three

hostname: three

cap_add:

- ALL

networks:

net2:

ipv4_address: 192.168.102.12

networks:

net1:

name: net1

ipam:

driver: default

config:

- subnet: 192.168.101.0/24

net2:

name: net2

ipam:

driver: default

config:

- subnet: 192.168.102.0/24

volumes:

conf:

external: true

Lancio del progetto:

docker compose up -d

Controllo dei contenitori generati:

docker ps

Verifica Iniziale

Vogliamo verificare che il contenitore one (client) non riesce a connettersi col contenitore three (web server). Tra l'altro sono su due reti diverse e non è configurato il routing.

Connettersi a one:

docker exec -ti one sh

Provare la connessione:

curl http://192.168.102.12

Il comando si blocca: non è raggiungibile. Interrompere con Control-C

Uscire:

exit

Configurazione del Proxy

In una finestra di terminale collegarsi al contenitore two:

docker exec -ti two bash

Lanciare Apache:

apache2ctl -k start

Controllare che i processi siano attivi:

ps wax

Abilitare i moduli proxy, proxy_http, e proxy_connect:

a2enmod proxy proxy_http proxy_connect

Editare il file del modulo di proxy abilitato, scommentando le linee del proxy:

vim /etc/apache2/mods-enabled/proxy.conf

.....

ProxyRequests On

<Proxy *>

AddDefaultCharset off

Require all denied

Require local

</Proxy>

.....

Creare un nuovo Virtual Hosts:

vim /etc/apache2/sites-available/forward-proxy.conf

<VirtualHost *:8080>

ProxyRequests On

ProxyVia On

<Proxy "*">

Require ip 192.168

</Proxy>

ErrorLog ${APACHE_LOG_DIR}/error_forward_proxy.log

CustomLog ${APACHE_LOG_DIR}/access_forward_proxy.log combined

</VirtualHost>

Modificare il file di configurazione delle porte, per aggiungere l'ascolto alla porta 8080:

vim /etc/apache2/ports.conf

Listen 80

Listen 8080

<IfModule ssl_module>

Listen 443

</IfModule>

<IfModule mod_gnutls.c>

Listen 443

</IfModule>

Abilitare il sito virtuale:

a2ensite forward-proxy.conf

Restartare il server:

apache2ctl -k restart

Uscire dal container:

exit

Test del Proxy

Connettersi a one:

docker exec -ti one sh

Occorre configurare la variabile d'ambiente che setta il proxy:

export http_proxy=http://192.168.101.10:8080

Provare la connessione:

curl http://192.168.102.12

<html><body><h1>It works!</h1></body></html>

Prova di Persistenza Dati

Fermare e ristartare il progetto:

docker compose down

docker compose up -d

La configurazione precedente è rimasta perchè mantenuta nel volume conf.

Attivare il server proxy:

docker exec two apache2ctl -k start

Attenzione a non dare l'opzione -ti. Questa crea un terminale di collegamento, fa partire il server, poi il comando termina, il terminale muore e il processo apache2 rimane senza terminale di controllo e si trasforma in un processo zombie. L'unico modo di uscirne è di ristartare il progetto.

Il client ha lo stesso comportamento di prima.

Connettersi a one:

docker exec -ti one sh

Provare la connessione:

export http_proxy=http://192.168.101.10:8080

curl http://192.168.102.12

Esercizio con Versione Unix su Alpine Docker

Progetto

Nella stessa locazione dell'esercizio precedente, creare una nuova directory:

mkdir cproxyalp

Il Dockerfile è:

vim cproxyalp/Dockerfile

FROM alpine

RUN apk add apache2 apache2-proxy apache2-proxy-html curl

EXPOSE 80 443

CMD ["/bin/sleep","1000000"]

Il docker-compose.yml è:

vim docker-compose.yml

version: '3.6'

services:

one:

build: ccli

image: ccli

container_name: one

hostname: one

cap_add:

- ALL

networks:

net1:

ipv4_address: 192.168.101.11

two:

build: cproxyalp

image: cproxyalp

container_name: two

hostname: two

cap_add:

- ALL

networks:

net1:

ipv4_address: 192.168.101.10

net2:

ipv4_address: 192.168.102.10

three:

image: httpd:2.4-alpine

container_name: three

hostname: three

cap_add:

- ALL

networks:

net2:

ipv4_address: 192.168.102.12

networks:

net1:

name: net1

ipam:

driver: default

config:

- subnet: 192.168.101.0/24

net2:

name: net2

ipam:

driver: default

config:

- subnet: 192.168.102.0/24

Partenza del progetto:

docker compose up -d

Configurazione

Connessione al proxy:

docker exec -ti two sh

Configurazione:

cd /etc/apache2

vi conf.d/forward-proxy.conf

<VirtualHost *:8080>

ProxyRequests On

ProxyVia On

<Proxy "*">

Require ip 192.168

</Proxy>

ErrorLog logs/error_forward_proxy.log

CustomLog logs/access_forward_proxy.log combined

</VirtualHost>

Modificare il file di configurazione principale:

vi httpd.conf

Nella sezione Listen, aggiungere la linea:

Listen 8080

Far partire il server:

httpd -k start

Uscire:

exit

Test

Connettersi a one:

docker exec -ti one sh

Configurare il client proxy:

export http_proxy=http://192.168.101.10:8080

Provare la connessione:

curl http://192.168.102.12

<html><body><h1>It works!</h1></body></html>

Naturalmente questa configurazione non resiste ad un docker compose down. Se desideriamo la persistenza, allora dobbiamo creare un apposito volume docker e mapparlo alla directory di configurazione.

Reverse Proxy

Proprietà di un Reverse Proxy

Gestisce le richieste di un cliente esterno che accede a risorse nella intranet di un'organizzazione. Compie il forward delle richieste del client all'appropriato backend server.

Usato per load balancing, terminazione di SSL, cache e controlli di sicurezza.

I backend servers vedono la richiesta provenire dal reverse proxy come se questo fosse il client.

Posizionato al confine di ingresso dell'intranet di un'organizzazione, gestisce e controlla le richieste in ingresso.

Casi d'Uso di un Reverse Proxy

Con moduli del proxy server stesso:

- Load Balancing: bilanciamento del carico dei backend server.

- SSL Termination: possono gestire la crittografazione e decrittografazione con SSL/TLS per conto dei backend server.

- Caching: accelerazione dei tempi di responso al client e diminuzione del carico dei backend server.

Con software aggiuntivo installato a bordo del proxy:

- Sicurezza: possono filtrare il contenuto in provenienza dall'internet, e bloccare attacchi DDoS.

- Web Application Firewall (WAF): possono proteggere la sicurezza dell'applicativo dei backend server, impedendo p.es. SQL Injection e Cross Site Scripting (XSS).

- Conversione di Protocollo: possono tradurre richieste da un protocollo ad un altro.

- Compressione ed Ottimizzazione: possono effettuare compressione ed ottimizzazionne dei responsi verso il client, riducendo i tempi di trasferimento.

Moduli Requisiti

mod_proxy: modulo primario, requisitomod_proxy_http: gestisce i protocolli HTTP&HTTPSmod_ssl: supporta i protocolli SSL v3 e TLS v1.x

Esercizio su Debian e Ubuntu

Preparazione

Creare la directory di esercizio:

mkdir -p 02net1-ccli-net2-cproxy-2cweb

cd 02net1-ccli-net2-cproxy-2cweb

Preparare lo scaffolding:

mkdir ccli cproxy cweb

touch ccli/Dockerfile cproxy/Dockerfile docker-compose.yml

Verificare l'albero:

tree

.

├── ccli

│ └── Dockerfile

├── cproxy

│ └── Dockerfile

├── cweb

└── docker-compose.yml

Preparare volumi per la persistenza dati:

docker volume create confrev

docker volume create three-html

docker volume create four-html

docker volume ls

Client

Il client ccli è un'immagine Alpine abbastanza semplice.

vim ccli/Dockerfile

FROM alpine:3.7

MAINTAINER John Smith <john@stormforce.ac>

RUN apk --update add --no-cache openssh tcpdump curl

CMD ["/bin/sleep","1000000"]

Proxy

Il proxy cproxy è un'immagine Ubuntu con la versione Debian/Ubuntu di Apache installata, più qualche altra utility.

vim cproxy/Dockerfile

FROM ubuntu

RUN apt update

RUN apt install -y apache2

RUN apt install -y vim curl wget iproute2 iputils-ping tcpdump

EXPOSE 80 443

CMD ["/bin/sleep","1000000"]

Web Server

Il web server cweb è un'immagine Alpine con la versione Unix di Apache, disponibile su Docker Hub.

docker-compose.yml

Il docker-compose.yml è:

vim docker-compose.yml

version: '3.6'

services:

one:

build: ccli

image: ccli

container_name: one

hostname: one

cap_add:

- ALL

networks:

net1:

ipv4_address: 192.168.101.11

two:

build: cproxy

image: cproxy

container_name: two

hostname: two

cap_add:

- ALL

volumes:

- confrev:/etc/apache2

networks:

net1:

ipv4_address: 192.168.101.10

net2:

ipv4_address: 192.168.102.10

three:

image: httpd:2.4-alpine

container_name: three

hostname: three

cap_add:

- ALL

volumes:

- three-html:/usr/local/apache2/htdocs/

networks:

net2:

ipv4_address: 192.168.102.12

four:

image: httpd:2.4-alpine

container_name: four

hostname: four

cap_add:

- ALL

volumes:

- four-html:/usr/local/apache2/htdocs/

networks:

net2:

ipv4_address: 192.168.102.13

networks:

net1:

name: net1

ipam:

driver: default

config:

- subnet: 192.168.101.0/24

net2:

name: net2

ipam:

driver: default

config:

- subnet: 192.168.102.0/24

volumes:

confrev:

external: true

three-html:

external: true

four-html:

external: true

Lancio del progetto:

docker compose up -d

Controllo dei contenitori generati:

docker ps

Configurazione

Collegarsi a two ed abilitare il servizio web se non lo è già:

docker exec -ti two bash

apache2ctl -k start

ps wax

Moduli

Abilitare i moduli requisiti:

a2enmod proxy

a2enmod proxy_http

a2enmod ssl

Verificare:

apache2ctl -M

Disabilitare il sito di default

a2dissite 000-default.conf

Creare un nuovo sito virtuale

cd /etc/apache2/sites-available

vim example.com.conf

<VirtualHost *:80>

ServerName site1.com

ServerAlias www.site1.com

ServerAdmin postmaster@site1.com

ErrorLog ${APACHE_LOG_DIR}/error.log

CustomLog ${APACHE_LOG_DIR}/access.log combined

ProxyPass / http://192.168.102.12:80/

ProxyPassReverse / http://192.168.102.12:80/

ProxyRequests Off

</VirtualHost>